미 스탠포드대 인공지능(AI)연구진이 협동로봇작업이나 변화무쌍한 기후 변화같은 역동적 환경에서도 월등하게 작용하는 AI 강화학습 방법을 찾았다고 벤처비트가 1일(현지시간) 보도했다.

이에 따르면 스탠포드대 AI 연구실(SAI Lab) 연구원들은 시간 경과에 따라 역동적으로 변화하는 AI 데이터와 학습환경 하에서 과거경험을 활용하는 잠재 변수모델과 최대 엔트로피 정책을 사용함으로써 지금까지 최고로 꼽히는 강화학습 방식들을 능가하는 샘플효율성과 성능을 내는 결과를 보여주었다.

이 방식은 ‘평생 잠재 액터-크리틱(LILAC·Lifelong Latent Actor-Critic)’, 줄여서 ‘라일락(LILAC)’으로 불린다.

연구진은 라일락 관련 논문에서 “중대한 비정상(non-stationarity·일정하지 않은 분산) 시계열을 가진 다양한 도전적인 연속 제어 과제 수행시 우리의 접근방식이 기존의 최첨단 강화 학습법에 비해 상당한 개선으로 이어지는 것을 관찰했다”며 “환경에 적응할 수 있는 강화학습법은 예를 들어 기후조건 변화로 비가 오거나 눈이 오는 상황에서 로봇이나 자율주행차가 작동하도록 할 수 있다”고 썼다.

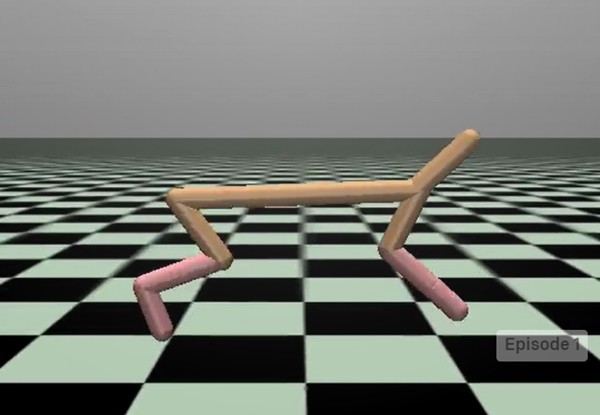

저자들은 멀티태스킹 및 메타 강화학습 벤치마크 및 평가를 하는 메타월드 벤치마크에서 고성능 협동로봇인 소여(Sawyer)로봇을 테스트하고, 오픈AI짐에서 하프 치타(Half-Cheetah)를 테스트하는가 하면 2D 내비게이션 과제 수행를 하는 등 동적 강화학습 환경 하에서 4가지 테스트를 실시했다.

연구진은 라일락을 2018년 버클리 AI연구소(Birke AIR)가 선보인 ‘SAC(Soft Actor-Critic)’나 올초 버클리대 연구진이 선보인 ‘확률론적 잠재 액터-크리틱(SLAC·Stochastic Latent Actor-Critic)’ 및 최고 수준의 강화학습 방식들과 비교 테스트한 결과 모든 영역에서 더 높고 안정적인 결과를 도출했다고 밝혔다.

스탠포드 대학의 연구원 애니 시에, 제임스 해리슨, 첼시아 핀은 2주전 인쇄 전 논문 저장소인 아카이브에 라일락에 대한 논문을 발표했다. 주 저자인 시에는 또한 세르게이 레빈 버클리대 교수와 SAC 및 SLAC에 대한 과제를 함께 수행했다.

논문은 “라일락은 이러한 방식들과 달리 향후 에피소드에서 환경이 어떻게 변하는지 추론함으로써 각 에피소드가 지속적인 환경변화를 보임에도 전 교육 과정에 걸쳐 꾸준히 높은 보상을 유지했다”고 지적했다.

저자들은 라일락 접근법이 평생학습 및 온라인 학습 알고리즘과 유사성을 공유한다고 말한다. 메타 학습과 메타 강화 학습 알고리즘도 새로운 설정에 빠르게 적응하려고 시도한다. 메타 강화학습은 강화학습 범주 내에 메타학습을 적용하는 것이다. 여기서 메타학습은 여러 가지 학습 자체를 잘하기 위한 학습 기법을 말한다. 기계학습 알고리즘도 학습자체를 잘할 수 있다면 새로운 작업에 대해 보다 빠르게 학습 성능을 높일 수 있다는 점에서 최근 메타학습이 활발히 논의되고 있다.

다른 최신 강화학습 뉴스에 따르면, 최근 구글 브레인, 카네기멜론대, 피츠버그대, 버클리대 와 레빈의 AI 연구진은 최근 도메인 적응에 대한 새로운 접근법을 소개했다. 이는 강화 학습 환경에서 에이전트에 대한 보상 기능(함수)을 바꾸는 기술이다. 다른 강화 학습 환경과 마찬가지로, 이 접근방식은 시뮬레이터의 소스 도메인을 더 타깃 도메인과 가깝게(현실 세계처럼) 만들려고 시도한다.

지난주 발표된 도메인 적응 논문은 “에이전트는 에이전트가 소스 도메인 또는 타깃 도메인과 상호 작용하는지 여부를 나타내는 전환 조치를 취할 경우 불이익을 받았다”고 썼다. 이어 “우리의 방법을 여러 제어 작업에 적용해 실험한 결과, 타깃 도메인에서 몇 가지 전환만 관찰했음에도 소스 도메인을 활용해 타깃상 도메인에서 잘 작동하는 정책을 학습할 수 있다는 것을 보여주었다”고 덧붙였다. 연구진은 소스 도메인과 타깃 도메인 전환을 구분하기 위해 만든 분류기로 보상 기능(함수)을 수정했다. 이들은 오픈AI짐(OpenAI Gym)에서 세 가지 과제를 가지고 그들의 접근법을 테스트했다. 오픈AI짐은 강화학습을 도와주고, 좀 더 일반적인 상황에서 강화학습을 할 수 있게 해주는 라이브러리다.

구글 브레인의 벤자민 아이센바흐와 카네기멜론대는 이 논문의 주요 저자다.

[관련기사] 인공지능이 타협도 한다고?...딥마인드, 승부 넘어 윈윈하는 AI 교육

[관련기사] 페이스북, AI로 컴퓨터 코드 자유자재로 변환