카네기멜론대, 소리-행동-비전 데이터세트·AI 알고리즘 계열 이용 시험

개체 식별 AI 모델, 소리로 79.2% 정확도로 물체 맞춰

‘훈련된 인공지능(AI)이 움직이는 물체의 소리만으로 그 위치를 파악하고 예측할 수 있다.’

벤처비트는 7일(현지시간) 미국 카네기멜론대(CMU) 연구원들의 발간 전 최신 연구 보고서를 인용, 소리가 물체의 출현과 움직임을 예측하는 데 사용될 수 있다는 사실을 발견했다고 전했다.

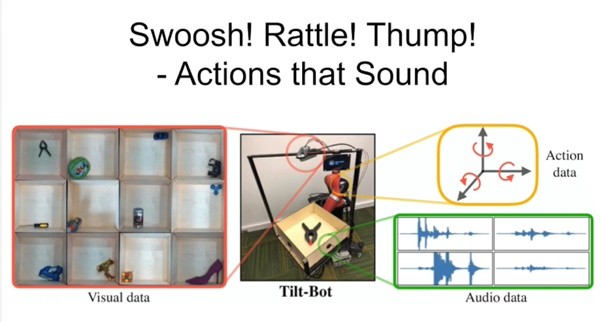

공동저자는 ‘음향(소리)-행동-비전(시각)(sound-action-vision)’ 데이터 세트와 AI 알고리즘 계열을 만들어 오디오, 비주얼, 움직임 간의 상호작용을 조사했다.

이들은 연구결과, 소리로부터 파생된 표현(representations)은 물리적 힘을 따르는 물체가 어디로 움직일 것인지를 예측하는 데 사용될 수 있다는 것을 보여주었다고 말했다.

시각이 지각의 기초인 반면, 소리역시 더 말할 것 없이 중요하다. 소리는 마른 잎의 (바스락 거리는 소리로 알 수 있는)질감이나 샴페인 병 내부의 압력(에 의해 나는 펑하는 소리)처럼 종종 시각적 데이터나 힘 데이터를 통해 감지할 수 없는 풍부한 정보를 포착하게 해 준다.

그러나 이를 물리적으로 이해하기 위한 소리를 이용한 시스템과 AI 알고리즘은 지금까지 거의 없었다. 카네기멜론대 연구팀은 그동안 간과된 이 부분에착안, 소리와 행동(액션) 사이의 시너지를 탐구하고 어떤 종류의 추론이 이루어질지 알아내려고 했다.

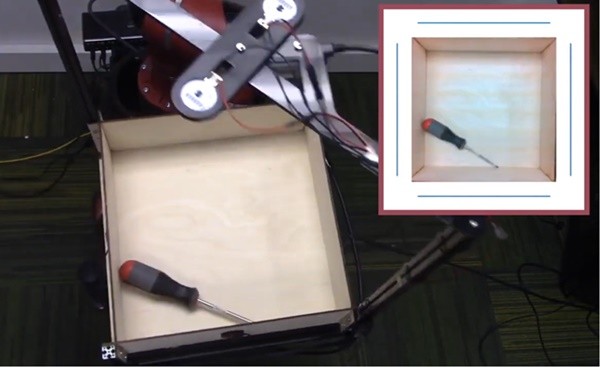

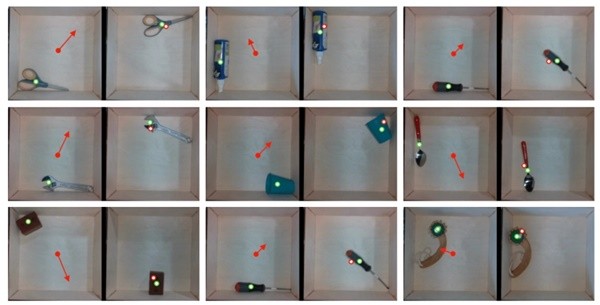

연구원들은 먼저 스크루 드라이버, 가위, 테니스 공, 큐브, 집게 등을 포함한 물체를 얕은 벽이 있는 사각 쟁반 위에 놓고 틸봇(Til-Bot) 로봇을 이용해 이들을 임의의 방향으로 계속해서 기울여 위치가 바뀌게 했다. 그리고 이를 바탕으로 한 음향-동작-시각 데이터 세트를 만들었다. 이 물체들은 석고 쟁반(트레이)의 얇은 면에 부딪혀 소리를 냈고, 이는 하나씩 자료에 추가됐다.

30×30cm 사각 쟁반(각 벽쪽에 하나씩)에 장착된 마이크 4개가 물체의 움직임에 따른 소리를 녹음했고, 머리위의 오버헤드 카메라는 적록청(RGB)색깔 정보와 깊이 정보를 캡처했다. 틸트봇은 각 물체를 1시간 동안 이리저리 움직였고, 물체가 쟁반과 접촉할 때마다 물체들이 쟁반 벽과 충돌하면서 내는 소리·RGB·깊이 데이터·물체 추적 위치 등을 포함하는 로그를 만들었다.

연구팀은 충돌 때 녹음된 오디오를 이미지로 처리할 수 있는 방법을 사용했다. 이는 모델들이 여러 오디오 채널 간 상관관계(여러 마이크의 녹음)는 물론 단일 오디오 채널(즉, 하나의 마이크에 의한 녹음)의 시간 상관관계까지 포착할 수 있게 해 주었다.

그런 다음 연구원들은 먼저 소리를 통해 물체를 식별하는 AI 모델을 훈련시키기 위해 60개가 넘는 물체와 쟁반 간의 1만5000번의 충돌에서 낸 소리를 포함하고 있는 자료를 사용했다. 두 번째로 이들은 좀더 도전적인 연습을 통해 보이지 않는 물체에 어떤 행동이 적용됐는지 예측하는 AI모델을 훈련했다. 세 번째로 이들은 로봇 팔에 의해 밀린 이후의 물체 위치를 알아내기 위해 포워드(전진) 예측 AI 모델을 훈련시켰다.

연구진은 개체 식별 AI 모델이 소리만으로 79.2%의 올바른 물체 예측 정확도를 보였고, 기울였을 때 발생한 소리가 너무 부드러울 때만 실패했다고 설명했다.

한편, 액션 예측 모델은 이전에 보이지 않았던 30개의 물체 세트에서 0.027의 평균 제곱 오차(mean squared error)를 기록했는데, 이는 카메라의 영상만으로 훈련된 모델보다 42% 더 나은 수치다. 그리고 포워드 예측 모델은 물체가 어디로 움직일지에 대한 예측에서 더 높은 정확도를 보였다.

연구진은 “포워드 모델 학습과 같은 일부 영역에서는 실제로 소리가 시각 정보만으로 얻을 수 있는 것보다 더 많은 정보를 제공한다는 것을 보여준다”고 썼다. 또 “우리는 우리의 발견과 함께 공개될 틸트-봇( Tilt-Bot)데이터 세트가 향후 음향-작동영역(sound-action domain)에서 영감을 주고 로봇공학에 광범위하게 적용될 수 있기를 바란다”고 말했다.

[관련기사] "나이스 캐치"...공중에서 뜬 물건 잡는 AI 드론 등장

[관련기사] 고전 텍스트 게임으로 간 인공지능...강화학습과 NLP로 병목현상 풀어

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com