GPT3는 1750억개, GPT4는 100조(兆)개 파라미터 사전학습

MIT 랙스 프리드먼 "2032년 GPT4 학습 비용 500만 달러" 추산

"2032년이전에 5백만 달러 수준의 학습비용으로 GPT-3의 1000배 수준인 100조 단위의 파라미터를 사전학습 시킨 GPT-4 출시가 가능하다"

오픈AI에서 출시한 자연어처리 언어모델 GPT-3의 뛰어난 성능 찬사와 오류 우려가 엇갈리는 가운데, AI학계에서 GPT-4 출현 논란이 시작됐다. 오픈AI 창립자인 일론 머스크는 "5년 내 AI가 인간을 추월할 것"이라며, 인공지능이 인간지능을 넘어서는 소위 '특이점(Singularity)' 논쟁에 불을 지핀 바 있다. ( [AI & Tech] “5년 내 AI가 인간 추월한다”…일론 머스크의 경고 ).

11일 MIT AI연구원 렉스 프리드맨(Lex Fridman) 박사에 따르면 "인간의 뇌 수준인 약 100조개 시냅스(연접 : 뉴런과 뉴런 사이 신호를 전달하는 연결지점)를 가진 모델이 GPT-4"로 정의됐다.

프리드맨 박사는 "GPT3는 1750억 개의 매개변수를 학습했고, 이는 GPT2의 100배 수준"이라면서 "GPT3의 계산 속도 기준을 3.14E +23플롭스로 잡으면 사전 학습 비용은 약 460만 달러(한화 약 55억 원)"라고 설명했다. 플롭스는 컴퓨터 성능 수치를 계산하는 단위.

그는 "2020년 출시를 가정하면 GPT4의 학습 비용은 약 26억 6000만 달러(한화 약 3조 867억원)에 달하지만, 컴퓨팅(하드웨어 및 소프트웨어) 기술 발달로 24년에는 3억 2500만 달러, 28년 4000만 달러, 32년에는 500만 달러로 그 비용이 줄어들 것"으로 분석했다. 이는 '신경망의 알고리즘 효율도 측정'연구 결과 ( https://arxiv.org/abs/2005.04305) 를 인용, 지난 7년간 인공신경망 훈련 효율이 16개월마다 2배씩 증가했다는 점을 반영한 계산 방식.

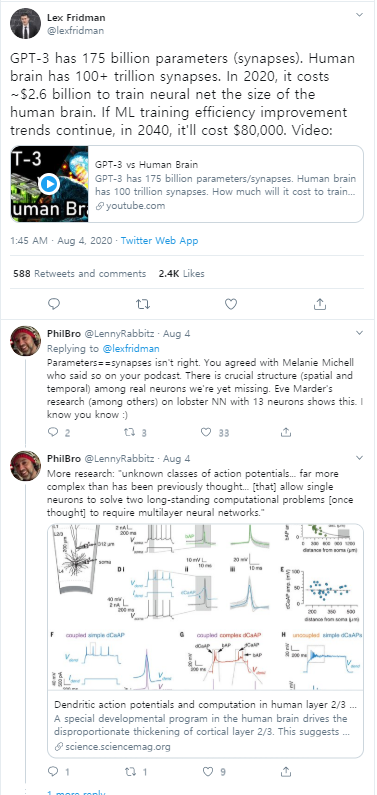

이같은 주장이 유튜브(https://www.youtube.com/watch?v=kpiY_LemaTc)와 트위터 계정을 통해 공개되자 찬반 댓글이 이어지고 있다.

반박의 요지는, "인간 뇌의 시냅스와 인공지능의 파라미터 작동 방식과 정의는 똑같지 않다(@Lenny Rabbiz)"는 것.

또, "GPT2와 GPT3 손실 함수 계산법을 근거로 GPT4 학습 비용을 추청했지만, 14억 개 이상의 매개 변수를 가진 모델에 사용할 수 있는 GPU가 존재하지 않으므로 GPT4 사전학습 비용은 약 880억 달러"라는 주장도 제기됐다.

김창경 전 교육부 차관은 "일론 머스크는 인공지능과 싸우기 위해 인공지능을 사람 두뇌와 연계하는 뉴럴링크를 만들고 있다"면서 ([AI & Tech] “뇌와 컴퓨터 연결한다”…일론 머스크, 뇌에 이식할 두뇌칩 '뉴럴링크' 개발 ) "지금은 아예 교육과 학습에 대한 사고 자체를 완전히 바꿔야 하고 살아남는 시점인데 한국의 교육계는 기이할 만큼 고요하다"고 지적했다.

오픈AI가 2018년 첫 출시한 GPT1은 1억 1700만 개의 매개변수로 학습했다. 2019년 4번에 걸쳐 공개된 GPT2는 모델의 크기에 따라 약 1억 2400만개에서 15억개로 GPT1의 10배 수준이다. 올 6월 1750억개의 매개변수로 훈련된 GPT3는 각각 GPT1의 1000배, GPT2의 100배 이상 크기이다.

[AI & Tech] GPT 인기몰이, 사례 모아놓은 닷컴 등장. 깃허브ㆍ트윗이어 웹사이트까지

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com