인공지능(AI) 학습 데이터셋의 편향성을 측정해주는 오픈소스 소프트웨어 라이브러리가 나왔다.

링크드인이 인공지능(AI)과 머신러닝 워크 플로우에서 편향성을 측정하는 오픈소스 소프트웨어(OSS) 라이브러리 링크드인 공정성 툴킷(LiFT)을 공개했다고 벤처비트가 25일(현지시간) 보도했다.

LiFT는 AI모델이 학습하거나 채점하는 과정에서 데이터 셋의 편향 정도를 측정해주고, AI모델 하위그룹 간의 성능 차이를 찾아주는 툴이다.

대부분의 편향성 측정 OSS 툴킷은 큰 규모의 문제를 해결하지 못하고 특정 클라우드 환경에서 작동한다. 반면, LiFT는 애드혹 공정성 분석과 두개의 변형 A와 B를 사용하는 종합 대조 테스트에 활용할 수 있다.

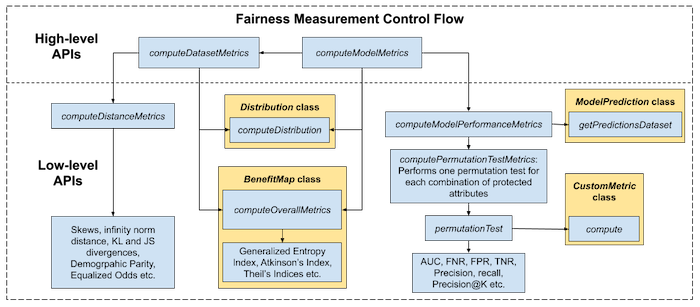

LiFT는 래퍼와 배포용 구성 언어로 재사용할 수 있다. 최상위 단계에서 라이브러리는 코드를 작성하지 않아도 간단한 구성으로 기본적인 드라이버 프로그램을 제공한다. 또 맞춤형 계산을 위해 주요 클래스를 확장해 모든 수준의 공정성 메트릭 계산에 사용하는 상위 레벨과 하위 레벨 API 액세스도 제공한다.

LiFT는 아파치 스파크에서 기본 키, 레이블, 예측 및 보호된 속성을 가진 데이터 셋을 데이터베이스에 불러 올 수 있다. 데이터 분산은 공정성 메트릭 계산을 가속화하기 위해 메모리 내 단일 시스템에 계산ㆍ저장한다. 사용자는 데이터 분산 과정에서 이를 구동하거나 관련성 높은 메트릭 데이터 셋을 캐시 처리하는데 사용할 수 있다.

현재 링크드인은 AI 모델 개발에 앞서 학습 데이터 셋의 공정성 측정을 하기 위해 LiFT를 내부에 적용했다. 향후 파이프 라인 수를 늘릴 계획이다.

스리람 바스데반 링크드인 수석 엔지니어는 "뉴스 헤드 라인과 학술 연구는 인간의 편견에 근거한 광범위한 사회적 불평등은 AI모델과 모델 자체를 훈련시키는 데 사용되는 데이터에 모두 반영될 수 있다"며 "우리는 링크드인 채용과정에서 편견을 해소고 능력 있는 구직자에게 평등한 기회를 보장하도록 노력하고 있다"고 블로그를 통해 밝혔다.

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com