AI가 모든 학생 집중도·이해도 판단, 교사에게 알린다

뇌파 혹은 표정, 손짓, 시선 등 시각 데이터 이용

한양대 임창환 교수 연구팀, 인텔, 에이서까지 참여 활발

선생님이 학생에게 천천히 다가간다. "OO아, 졸지 마. 선생님이 슬프단다" 라고 말한다.

학교에서 수업시간에 흔히 볼 수 있는 광경이다. 학생들이 고개를 젖히며 졸거나 몰래 유튜브 영상을 보는 광경은 곧 보기 어려워질 전망이다. 학생들의 얼굴 표정이나 행동, 혹은 뇌파를 분석해 수업에 집중하고 있는지 알아내는 AI 선생님이 교실에 등장할 날이 머지 않았다.

AI가 학생 개개인의 실시간 감정, 집중도, 이해도를 파악한 내용을 전달하면 인간 선생님이 수업 방식에 즉각 반영한다. 학생들의 집중력이 떨어지면 주위를 환기시킬 재미있는 이야기를 해주고, 이해를 못한 학생들이 늘어나면 어려운 내용을 다시 설명하는 식이다.

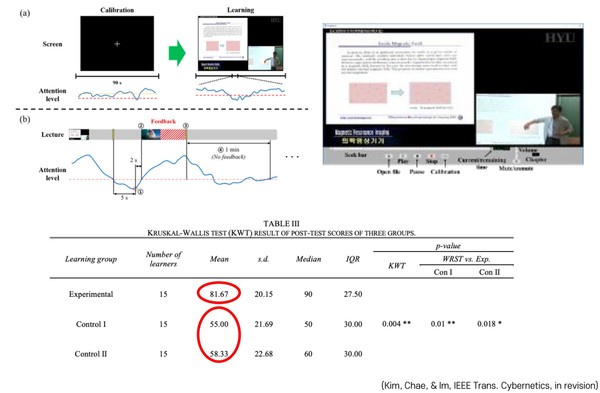

임창환 한양대 생체공학과 교수는 7일 카오스재단 주최 ‘AI와 뇌공학이 바꿀 인류와 미래’ 강연에서 집중도 향상 AI 시스템에 대한 연구 성과를 발표했다. AI가 학습효과를 높인다는 결과를 제시했다. 이 연구에서 AI 시스템은 온라인 강의를 시청하는 의과대학생들의 뇌파 데이터를 통해 집중도를 파악하고 교수에게 전달했다. 교수는 학생들의 집중도가 떨어질 때 특정 내용을 다시 설명하거나 주위를 환기시키는 이야기를 하는 등 즉각 대응하면서 강의를 진행했다. AI 시스템 효과를 확인하기 위해 강의 후에는 시험을 치렀다.

실험 결과, AI 시스템을 사용한 강의를 들은 학생 그룹의 시험 점수가 30점 가량 높게 나타났다. AI 도입 강의를 들은 학생들의 평균 점수는 81.67점이었고, 비교군으로 보통 강의를 들은 2개 학생 그룹의 경우 55점, 58.33점을 받았다.

뇌파를 분석해 학생들의 집중력을 개선하고 학습 성과를 올리려는 시도는 최근 전세계에서 활발히 일어나고 있다. 지난 4월 ACM SE 2020에서 공개된 ‘BCI(Brain Computer Interfaces)를 이용한 집중 패턴 감지’ 연구도 그 중 하나다. 이 연구에서 AI는 뇌파에서 감정을 파악하는데 90% 정확도를 보였다. 피실험자의 뇌 신호를 수집하는 기기도 이마에 부착하는 센서 1개만 사용해 간편화했다.

연구진은 BCI로 뇌파 활성도와 뇌파도(EEG)값을 측정한 후 RNN(Recurrent neural network) 훈련시켜 대상 학생이 수행 중인 행동 종류를 파악했다. 뉴로마케팅 데이터로 각 실험 대상의 긍정적 혹은 부정적 마음 상태를 구별했다. 14개 뇌 신호를 동시에 수집할 수 있는 이모티브 EPOC+(Emotiv EPOC+)를 도입해 여러 대상의 데이터를 시시각각 모았다.

총 1045개 신호를 분석한 초반 결과는 부정적 마음을 파악하는데서 한계를 보여 정확도 60%에 그쳤다. 정확도 개선을 위해 연구진은 스플라인(spline) 필터를 이용해 신호들을 표준화하고 빈도가 낮은 요소들을 추출했다. 이후 ANN(Artificial Neural Network)모델로 이 구성요소들을 분석해 숨겨진 값들을 발견, 정확도를 90%로 높였다.

◆얼굴 표정·손 움직임·시선으로 학생 마음 읽는 AI

얼굴 표정, 손 제스쳐, 시선, 입모양 등 시각 데이터를 분석해 학생들의 마음을 읽는 AI 선생님도 활발히 개발 중이다. 뇌파 분석 AI보다 비교적 최근 등장해 발표된 연구도 적고 성능도 떨어지지만 데이터 수집에 필요한 기기가 CCTV와 같이 비교적 간편하다는 장점이 있다.

홍콩대 연구팀은 금년 1월 학생들의 수업 참여 향상을 위한 얼굴 표정 분석 AI를 개발했다. 이 연구팀이 개발한 AI 시스템은 교실 내 CCTV를 통해 수집한 학생들의 실시간 얼굴 이미지 데이터에서 표정을 분석해 졸음, 지루함 등 마음 상태와 집중력을 파악했다.

실험은 어린이 학생과 대학생 2가지 대상으로 나눠 진행했다. 어린이 대상 실험 장소는 일본의 한 교실, 대학생의 경우 홍콩대학교 강의실로 정했다. 교수와 교사들은 강의 시간 동안 AI에게 개별 학생과 전체 학생의 감정 분석 결과를 받았다.

실험 결과, AI 시스템은 행복감과 같은 감정은 잘 파악했지만 분노, 슬픔과 같은 부정적인 감정 파악에서는 비교적 많은 오류를 냈다. 특히 수업에 집중하는 학생이 표정을 찡그리는 것을 불쾌감을 느끼는 것으로 인식하는 경우가 많았다.

연구를 주도한 후아민 추(Huamin Qu) 교수는 “이 문제를 해결하기 위해서는 새로운 감정 카테고리를 추가해 데이터를 라벨링하고 모델을 다시 훈련시켜야 한다”고 밝혔다.

얼굴 인식 AI 시스템 활용 사례에서와 같이 교실에 CCTV를 설치하는 데에는 프라이버시 침해 문제가 따른다. 개인의 얼굴 정보는 물론 감정 상태까지 노출되기에 위험성이 더욱 크다. 이는 뇌파 데이터를 사용하는 AI도 피해갈 수 없는 문제다. 프라이버시 문제로 인해 수업 질이 되려 떨어질수도 있다는 우려도 나온다.

추 교수는 “AI 시스템 도입이 학생들과 선생들의 주의를 더욱 산만하게 할 수도 있다. 누군가가 계속 그들을 감시하고 있다는 생각에 자유롭게 의견을 제시하지 못할 것”이라고 말했다.

이어 “선생님이 강의를 전하고 학생들은 듣는 기존의 일방향적 교실에 도입될 시 선생님만 기술을 사용해 진정한 양방향적 교육을 실현하기 어렵다”고 지적했다.

그럼에도 추 교수를 비롯한 많은 연구자들은 학생들의 마음을 읽는 AI 선생님이 미래 교실에서 유용하게 쓰일 것으로 기대하는 입장이다.

추 교수는 “현재 인간 교사들은 개개 학생들에 집중할 수 없다. (개인 맞춤형 교육 방식에 대해) 훈련받지도 않았고 시간도 부족하기 때문”이라며 “감정과 여타 행동을 분석할 수 있는 AI 선생님이 필요한 이유”라고 강조했다.

임창환 교수도 “최근 활발해진 비대면강의를 포함해 기존 수업방식은 모두 일방향적이다. AI를 통해 교사들이 학생들의 집중력, 감정 등을 알 수 있다면 양방향적 교육을 실현하는데 큰 도움이 될 것”이라고 말했다.

에이서(Acer)와 인텔도 시드니기술대학교(UTS)와 함께 개인 맞춤화 학습을 위한 AI 개발에 뛰어들었다. 2019년 UTS가 주최한 ‘Learner Attention Analytics Pilot Program’에 에이서와 인텔은 파트너사로 참여, 200명의 데이터 사이언스 전공 학생들과 함께 연구를 시작했다. 연구에서는 GUI(Graphical user interface)로 손 제스처, 시선 움직임, 입 모양, 키보드 및 디지털 펜 사용 내역, 눈 움직임 데이터를 모은다. 수집한 데이터에 AI를 적용해 학생들의 행동 패턴을 알아내고 학습 성과를 향상시키는 것이 목표다.

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com