연산량 성능 유지... 소형기기에 탑재 가능

NAS 아키텍처, 성능에 비해 큰 용량 단점

장기적 분야별 범용 아키텍처 설계 완성 목표

모델 경량화 기술은 높은 연산량의 성능을 유지하면서 소형기기에 탑재가 가능하도록 설계되는 AI 기술을 의미한다.

AI 모델 개발을 위해서는 많은 연산량과 데이터가 필요하다. 학습을 시킬 때도 물론이고, 후에 이를 활용할 때도 GPU 사용이 필수적이다. 최근에는 군사분야를 비롯해 민감한 개인정보, 정보보안에 중점을 두는 ‘폐쇄적 네트워크’의 중요성이 떠오르면서 경량화 기술에 대한 관심이 높아지고 있다.

모델 경량화는 크게 ▲경량 네트워크 설계 ▲다중 네트워크 경량화 ▲네트워크 모듈 경량화 ▲경량 연산 칩(Chip) 등 네 가지로 구분된다.

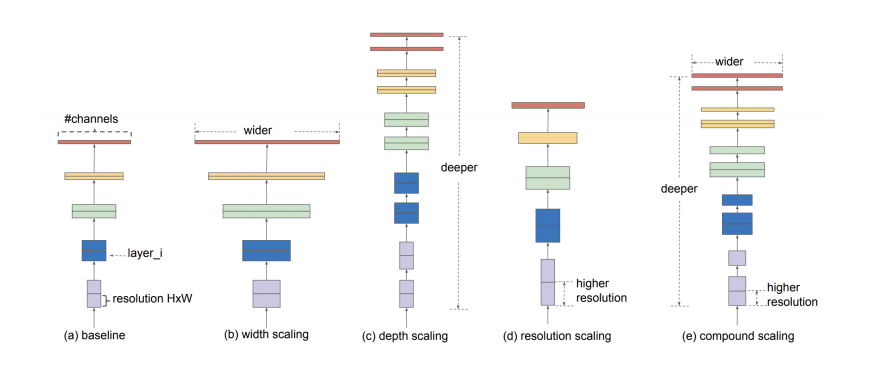

1) 경량 네트워크 설계 : 성능 대비 연산량과 메모리, 처리시간이 낮은 모델을 설계하는 단계다. EfficientNet 네트워크 제안을 예로 들 수 있다.

2) 다중 네트워크 경량화 : 성능을 개선하는 다량의 모델이나 대용량 모델을 경량화(압축)하는 단계다. Teacher-Student 학습 최적화가 한 예다.

3) 네트워크 모듈 경량화 : 모델에 사용되는 Conv, FCL 등 모듈의 연산·메모리 최적화를 통해 AI 처리 속도를 높일 수 있다. 양자화가 한 예다.

4) 경량 연산 칩(Chip) : 소형기기 탑재를 위해 연산 과정을 최적화 하는 단계다. 네트워크 전용 HW나 PIM(Processing in Memory) 구축이 여기에 해당된다.

◆기술동향

AI는 그 모델 구조에 따라 정확도, 성능·연산속도 등이 영향을 받기 때문에 이를 최적화하려는 시도가 늘고 있다. 하나의 대용량 모델이나 다수의 모델을 작은 규모의 모델로 학습하면서 성능을 유지하는 디스틸레이션(Distillation) 기술 등 아키텍처를 자동으로 설계하는 연구가 진행되고 있는 추세다.

딥러닝은 Resnet, Inception 등 다양한 아키텍처의 등장으로 크기 역시 증가하고 있다. 신경 구조망 탐색(Neural Architecture Search, NAS) 기반 아키텍처는 성능에 비해 큰 용량이 단점이다. 이 같은 문제를 해결하기 위해 구글은 2019년 EfficientNet을 도입했다. Resnet 아키텍처와 비교해 EfficientNet은 크기가 7.6배 줄어들었지만 5.7배 빠른 것으로 확인됐다.

처음 디스틸레이션 기법이 소개된 것은 2015년으로, 제프리 힌튼 토론토 대학 교수가 제안한 것이다. 당시 힌튼 교수는 논문에서 앙상블 모델을 압축해 음성인식 성능을 0.2% 감소시키는 데 성공한 사례에 대해 설명했다. 힌튼 교수는 실험을 통해 동일한 여러 모델을 사용한 성능과 유사한 하나의 모델을 생성하는 방법을 제안했다. 이 방법으로 소규모 모델을 생성하는 것이 가능하다고 제안했다. 이 실험은 현재 모델을 경량화시키기 위한 목적으로 활용되고 있다.

기술 초기단계인 2016년부터 이미지 분류에 활용되는 CNN, FCN 모델 경량화에 대한 연구가 진행됐다. 이후 2020년 언어 모델에 활용되는 어텐션(Attention) 기반의 트랜스포머(Transformer) 경량화 연구도 등장했다.

모듈 경량화 연구는 연산량을 고려하지 않은 상태에서 모델 크기만을 줄이는 연구방식에서 벗어나 연산량과 모델 크기를 함께 연구하는 형태로 발전했다.

2016년은 모델 경량화 기술 초기연도라고 할 수 있다. 이때는 모델 용량을 경량화 하는 형태로 양자화, Pruning, 무손실 압축 등의 방식으로 용량을 줄이는 연구가 이어졌다. 대용량 모델을 약 49배로 압축해 VGG-16 모델을 기준으로 552 MB에서 11.3 MB로 크기를 줄였다. 이는 클라우드 환경에서 분산처리 시 발생하는 모델 공유에 적용해 모델 전송 시간을 단축하면서 학습시간을 빠르게 앞당기는 것을 목표로 한다.

IoT 기기에 사용할 수 있는 기술로 양자화를 비롯해 정보를 소수의 요소만으로 표현하는 스파스 코딩(Sparse Coding)이 소개되고 있다.

멀티미디어부호화 국제 표준화위원회는 딥러닝 모델을 압축해 저장하는 NNR (MPEG-7 Part 17) 표준화를 진행 중이다. 한국항공대를 비롯해 노키아, 화웨이, 북경대 등 공인기관은 모델경량화 기술을 9개 분야로 나눠 검토·평가 중이며, 오는 4월 FDIS에 발간으로 목표로 제안 기술과 비교 평가 방식 등을 논의하고 있다. 5가지 이상의 양자화 방식 외에도, Entropy Coding 방식, Pruning, Sparsification, Matrix Decomposition 등 다양한 압축 기술이 제안되고 있다.

정확성을 유지하면서

AI 추론모델을 최대 1%로 줄여준다.

채명수 노타(온 디바이스 AI 기술기업)대표

텐서플로우, 파이토치 등 딥러닝 학습 프레임워크에서는 기본 양자화 알고리즘에서 적용한 모델을 학습에서 사용할 수 있도록 지원하고 있다. 앞으로 그 지원폭은 더욱 넓어질 예정이다.

모델 경량화 기술이 성능에 큰 개선점을 확보하자 이에 관한 연구도 점점 증가하고 있다. 경량화 연구는 그 접근방식에 따라 평가방법이 다양하기 때문에 정확한 평가를 내리기 어려운 항목도 존재한다. 이에 평가지표에 관한 연구에도 관심이 모아지고 있다.

◆시장 동향

엔비디아는 클라우드용 GPU부터 자율주행용 GPU 모듈까지 다양한 형태의 킷을 개발·제공한다. 또 자체적으로 양자화 처리를 통해 경량화하는 한편, 처리속도를 개선하는 도구도 개발·배포하고 있다. 최근에는 Drive AGX Devkit을 출시, 자율주행 기술업체인 Pony.ai 등과 협력 중이다.

구글은 추론환경에서 End-Device용 칩과 프레임워크를 제공하고 있다. 또 라즈베리 파이 등과 연동이 가능한 패키지를 개발해 확장성을 높이고 있다. 현재 동전보다 작은 사이즈의 액셀러레이터 모듈의 출시를 앞두고 있다.

인텔은 2016년 너바나(Nervana), 2019년 하바나(Habana)를 차례로 인수하면서 AI칩 개발을 강화는 동시에 오픈VINO 프로젝트를 통해 텐서플로우, 파이토치 프레임워크에서의 모델 경량화를 거쳐 자사 제품 상용화에까지 활용하고 있다.

자일링스는 파이토치에 양자화 모듈을 연동해 구현하는 FINN을 개발해 오픈소스로 공개하고 있다. 하이실리콘은 하이키(Hikey) 솔루션을 통해 자사칩에 Caffe 기반의 Porting 도구로 모델을 탑재할 수 있도록 제공하고 있다.

애플은 자체 뉴럴엔진과 코드를 지원하고 있으며, XNOR.ai를 2억 달러에 인수했다. 퀄컴은 네덜란드 소재 스타트업을 인수하면서 자체 학습 도구를 지원하고 있다.

◆발전전망

모델 경량화 기술은 현 시점에서 상당 부분 완성을 이루었다. 오는 2022년까지 단기적으로 추론모듈과 데이터 경량화 연구를 진행한다.

중기(2023~2026년)에는 생성, 분류, 강화학습 등 분야별 범용 아키텍처를 설계하는 것을 목표한다. 또 온디바이스 환경에서는 소규모 저전력 장치에서 학습하는 기술과 지속 학습, 연합학습과 연계해 자가 개선이 가능한 딥러닝 기술에 초점을 맞춘다. 클라우딩 환경에서는 전력 소모를 최소화하는 동시에 고성능 컴퓨팅 환경을 구축한다.

장기(2027~2030년)에는 범용 경량 아키텍처 설계를 완성하고, 온오프에서 활용 가능한 AI 디바이스를 개발한다. 그리고 주어진 제한 탄소 배출량을 고려한 딥러닝 개발 프로세스의 최적화 기술을 연구한다.

◆주요 프로젝트

[미국]

① Duke University ‘Optimizing Deep Learning Training through Modeling’

연구시기 : 2018~2021년

② MIT ‘Efficient Algorithms and Hardware for Accelerated ML’

연구시기 : 2020~2025년

③ MIT CSAIL ‘Contrastive Representation Distillation’

연구시기 : 2019년~

[국내]

① KETI(한국전자기술연구원) ‘140GHz 전파기반 차량용 3차원 고정밀 상황인지 SoC’

연구시기 : 2019~2021년

② KETI ‘활성화·커널 데이터의 압축·복원 통한 초저전력 모바일 딥러닝 반도체 개발’

연구시기 : 2019~2021년

③ 서울대 ‘임베디드 시스템 위한 딥러닝 알고리즘의 경량화 및 점진적 학습 기법 연구’

연구시기 : 2018~2021년

④ KAIST ‘딥러닝을 이용한 무인기에서의 조난자 탐지기술 개발’

연구시기 : 2016~2019년

⑤ LG전자 ‘실외 무인 경비 로봇을 위한 멀티모달 지능형 정보분석 기술 개발’

연구시기 : 2017~2021년

AI타임스 박혜섭ㆍ정윤아 기자 phs@aitimes.com

"인공지능과 자연지능 연계 집중할 때" AI 기술청사진 연구 총괄 IITP 박상욱 팀장

[특별기획] 인공지능 기술 청사진 2030 연재순서 표

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com