복잡한 연주도 가능한 AI 피아니스트 등장

고인이 된 유명 가수들 AI 기술로 부활

빅히트, 음성합성기술 스타트업 수퍼톤에 40억 투자

작곡으로 인간과 대결하는 수준까지 올라

편집자 주

'콩나물' 이어폰이나 헤드폰에 수십만원을 투자하고, 매월 유료 스트리밍 서비스 결제가 낯설지 않다. 음악 시장이 크게 바뀌고 있다.

코로나19로 촉발된 '집콕'으로 언택트(Untact)와 온택트(Ontact)가 조화를 이룬 소위 '음악 전성 시대'가 도래한 것.

관련 기업 매출과 주가는 연일 상승 추세에, 수준 높은 인력과 거대 자금이 유입되면서 더 우수한 상품과 서비스가 나타나는 선순환 구조를 만들고 있다.

▲음원 손실이 적은 녹음 기술 발달 ▲가상악기(VSTI) 만으로 실현 가능 ▲스마트폰 보급ㆍ발전 ▲통신 속도 향상으로 언제 어디서나 음악을 듣는 시대. 메타버스(Metaverse) 공간에서 신곡 발표, 쇼케이스가 진행되는 디지털 음악 시장의 바탕에는 AI(인공지능) 기술과 IT(정보통신) 기술이 깔려 있다.

◇특별취재팀: 팀장 권영민, 최명현ㆍ정윤아ㆍ박혜섭ㆍ장희수 기자

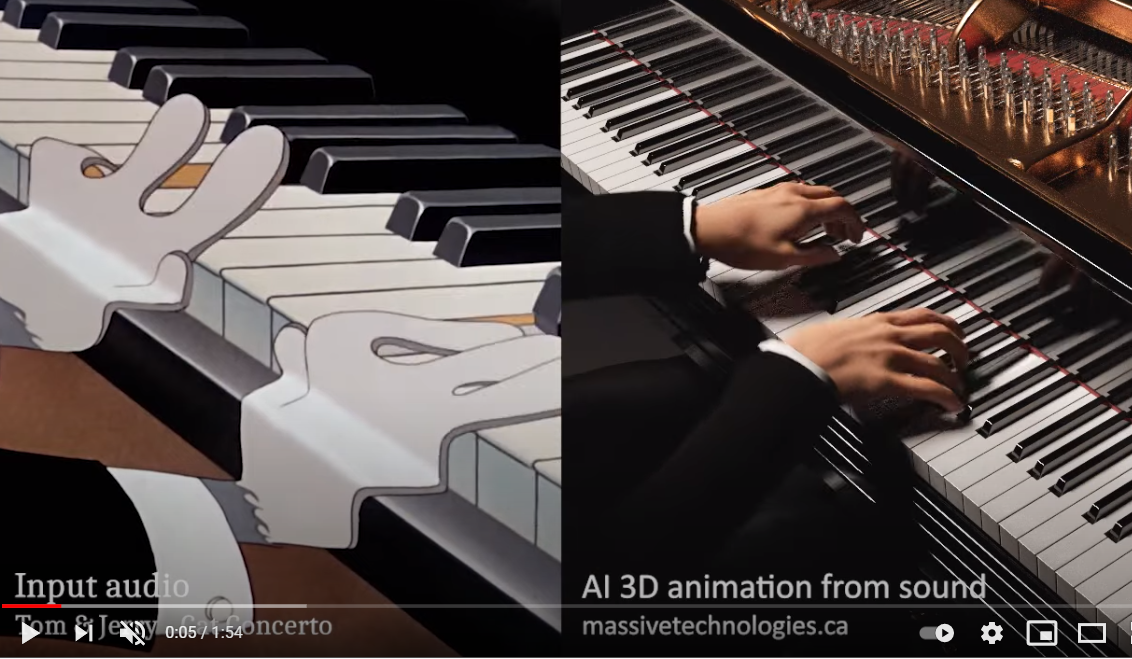

캐나다 기술 기업 매시브 테크놀로지(Massive Technologies)의 창업자 Fayez Salka는 트위터에 흥미로운 영상을 공개했다. (영상 링크) 3D 렌더링된 사람 모습의 AI 피아니스트가 클래식 음악과 애니메이션 음악을 연주한다. 매시브 테크놀로지는 원시 오디오(Raw audio) 파일을 입력, 학습시켜 연주 기법과 신체의 움직임을 애니메이션으로 구현했다.

영상 속 AI 피아니스트는 어떤 어려운 곡이든 연주해낸다. 해당 영상은 50만 뷰를 돌파했으며 AI도 연주할 수 있다는 것을 보여줬다.

◆ 빅히트, 음성합성기술 기업 수퍼톤에 투자

지난해 음성 AI를 연구해온 서울대 이교구(지능정보융합학과) 교수는 음성합성기술 스타트업, 수퍼톤을 설립했다. 수퍼톤은 'AI 음악 프로젝트-다시 한번'과 SBS '세기의 대결! AI vs 인간' 등 프로그램을 통해 음성합성기술을 선보였다. 엠넷 '다시 한번'에서 혼성그룹 '거북이'의 고(故) 터틀맨(임성훈)과 가수 김현식의 목소리를 복원했다. 'AI vs 인간'에서는 고(故) 김광석의 목소리를 구현했다.

AI 스피커의 유행으로 구글과 네이버가 TTS(Text to Speech, 글을 말로 읽어주기)에 달려들 때 이들은 AI와 음악을 연구했다. 지난해 수퍼톤을 설립해 시기는 뒤쳐졌지만 야마하 보컬로이드보다 완성도 높다.

많은 음악 AI 기업들은 '불편한 골짜기'에 빠져 기술의 정체를 겪는다. 불편한 골짜기란 인간이 아닌 존재를 볼 때 인간과 더 닮을 수록 호감을 갖지만 일정 수준에 도달하면 불쾌감을 느낀다는 이론이다. (원문 링크) 수퍼톤은 극복했다. 야마하를 제치고 수퍼톤은 2019년 음성국제학회에서 최우수논문상을 수상했다.

코로나19로 대면 활동이 단절돼 엔터 업계의 주 수익원이던 오프라인 콘서트가 불가능했다. 활로를 찾고 있던 해당 업계는 수퍼톤의 음성합성 기술을 주목했다. 수퍼톤은 대형 엔터 기업 빅히트와 손을 잡았다. 빅히트는 지난달 수퍼톤에 40억 원 규모의 투자를 유치했다.

엔터와 음성합성 기술이 합쳐져 연예인 목소리를 활용한 컨텐츠 사업이 가능하다. 이교구 교수에 따르면, " 시간 부족한 톱스타가 오디오북을 녹음하고 광고를 찍을 수 있다. BTS가 한국어, 영어뿐 아니라 각국 언어로 동시에 노래할 수 있다."라고 언급했다.

국내 기업이 기술적 우위를 유지할 수 있는

교두보를 마련하겠다

이교구 수퍼톤 대표이사

한국 애니메이션 캐릭터나 연예인의 목소리로 어떤 외국어든 표현할 수 있어 해외 시장에 적합한 콘텐츠를 생산할 수 있다. 박지원 빅히트 헤드쿼터(HQ) 최고 경영자(CEO)는 "IP와 기술의 단순 융합을 넘어 팬들에게 위로와 감동을 전할 수 있는 디지털 콘텐츠 제작에 힘쓰겠다."라고 포부를 밝혔다.

AI 작곡은 기계학습을 기반으로, 특히 딥러닝이라는 기계학습 알고리즘이 활용되고 있습니다. 인간 작곡가가 수많은 곡을 들어보고 이로부터 일종의 패턴을 찾아내어 자기만의 색깔을 입혀 새로운 곡을 만드는 것과 마찬가지죠.

기계학습 알고리즘에 기존에 만들어진 곡의 일부를, 예를 들어 첫 두마디를 입력으로 주고 그 다음 마디를 출력하라고 훈련하는 방법을 수없이 반복하게 되면 그 상관 관계를 파악하게 됩니다. 훈련이 끝난 후에는 임의의 음표를 입력으로 주고 나머지는 알고리즘이 만들어냅니다.

음악과 같은 창작물은 정량적, 계량적 평가가 거의 불가능하기 때문에 성능이 얼마나 우수한지 알기 어렵습니다. 연주자나 가수, 트렌드, 기획 의도 등 작곡 이외의 매우 다양한 요소들이 평가에 영향을 미치기 때문에 아주 제한적인 평가만이 가능하다고 볼 수 있죠.

아직까지 인공지능은 인간이 주도하는 음악 창작의 보조적 도구입니다. 인공지능이 더욱 발달해 인공지능 스스로 창작을 하게 되면 예술 정의에 변동이 필요하겠네요. 빠른 시간에 수 많은 곡을 만드는 인공지능 덕분에 사람은 더 좋은 곡을 취사선택할 수 있습니다. AI가 작곡하는 동안 잉여시간을 인간만의 창작 작업에 투입해 새롭고 양질의 음악 생산이 가능하게 됩니다. <서울대 이교구 교수>

◆ 딥페이크 음악

딥페이크는 딥러닝(Deep Learning)과 가짜(Fake)를 합친 말. 딥러닝을 이용해 이미지나 동영상 위에 다른 영상을 중첩, 결합하여 원본과는 다른 가공 콘텐츠를 생성하는 기술이다.

딥페이크의 핵심기술은 생성적 적대 신경망(GAN: Generative Adversarial Network). 생성모델과 식별모델이 공존하며 학습을 반복한다. 생성모델과 식별모델은 서로를 적대적 경쟁자로 인식하며 상호 발전 ○ 생성모델이 데이터를 기반으로 훈련 후 가짜 동영상을 만든다. 식별모델은 가짜를 감지하며 다른 모델이 감지할 수 없을 때까지 가짜를 만든다.

지난 4월 오픈 AI에서 딥페이크 기술을 이용해 음악 생성 모델 주크박스를 출시했다. 딥페이크 음악은 AI로 뮤지션 곡을 학습한 뒤, 비슷한 스타일로 곡을 새롭게 만들거나 뮤지션의 목소리를 모방한 노래다. 엘비스 프레슬리, 엘라 피츠제럴드 등 고인이 된 가수는 물론 셀린 디온, 브루노 마스 등 현존 가수 딥페이크 음악도 선보였다.

주크박스 코드는 깃허브에 공개하고 있다. (코드 링크) 일부 개발자는 코드를 이용해 딥페이크 음악을 생성했다. 유튜브 채널 다다봇에서 브리트니 스피어스의 댄스곡 'Toxic'을 20세기 대중음악 가수 프랭크 시나트라의 스탠더드 팝 스타일로 바꿨다. (영상 링크) 노래만 프랭크 시나트라 목소리로 부른다.

오픈 AI는 원시 오디오(raw audio) 파일로 주크박스를 훈련시켰다. 원시 오디오는 압축되지 않은 파일 형태다. 주크박스는 변이형 자동 인코더(VAE) 중 다중 스케일(VQ-VAE)를 사용해 오디오의 긴 레코드를 압축했다. 이를 자동 회귀 트랜스포머로 모델링, 음악으로 만든다. 디지털 신호를 아날로그로 복원하는 디코드 과정을 거친다.

주크박스는 음악을 기호화했다는 점에서 의미 있다. 기호화된 음악은 목소리를 포함하지 않는다. 그럴 경우 사람들의 음색, 표현력을 포착할 수 없다. 원시 오디오의 인코딩과 디코딩 과정을 통해 문제점을 보완했다.

◆ 작곡하는 AI

걸그룹 소녀시대 멤버 태연의 동생 하연이 AI가 작곡한 곡으로 데뷔를 했다. AI 작곡가 이봄(EvoM)이 작곡, 신인가수 하연이 작사해 'Eyes on you'를 지난해 10월 발매했다.

AI가 작곡한 곡을 들은 네티즌들은 '듣기 편하다.', '이상하지 않았다' 등의 반응을 보였다. 해외 유명 음반을 마스터링한 Conor Dalton도 '올해 들어본 가장 캐치한 음악'이라는 평을 남겼다.

이봄은 한국음악저작권협회에 등록된 유일한 AI 작곡가이며 광주과학기술원(GIST) AI 대학원 안창욱 교수팀이 개발했다.

지난달 <SBS 신년특집 세기의 대결 AI vs 인간>에서 이봄과 44년 음악 경력을 가진 김도일 작곡가가 트로트 신곡 대결을 했다. 이봄은 수식화된 음악 이론을 학습해 인간처럼 작곡한다. 대량의 곡을 학습해 작곡하는 기존의 AI 작곡 시스템과 다르다.

이봄이 작곡한 곡을 들은 판정단은 '기존 트로트에서 볼 수 없는 세련된 선율'이라며 최신 음악 트렌드를 적극 반영한 점을 주목했다. 하지만 트로트 고유의 정서를 자가 학습으로 구현해내지 못한 한계와 학습 데이터량 부족으로 인간에게 패했다.

한편 해외에는 유럽 스타트업 에이바 테크놀로지가 개발한 AIVA(에이바)가 있다. 2018년 12월 글로벌 영화 제작사 소니픽처츠에서 에이바가 작곡한 곡을 영화 OST로 사용했다. 2019년부터 팝, 재즈 등 여러 스타일의 곡을 3분 내에 작곡 가능하다.

AIVA는 심층신경망(DNN)을 이용해 곡들에서의 패턴들을 분석한다. 현존하는 곡들에서 몇개의 바를 기반으로 트랙 뒤에 어떤 음들이 나오는게 적절할지 추론한다. 그 후 특정 음악 스타일에 따라 수학적 규칙들과 집합을 구성해 작곡한다.

음악은 각자 선호하는 것이 다른 주관적인 예술. 에이바 컴퍼니 창업자 피에르 바로우(Pierre Barreau)는 곡 분위기, 작곡가의 성향 등을 기준으로 30개가 넘는 카테고리 라벨을 정했다. 라벨링된 데이터를 바탕으로 학습한 AIVA는 인간이 원하는 곡을 작곡할 수 있다.

특별취재팀 정윤아 기자 donglee0408@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com