텍스트를 편향되거나 유해한 이미지로 변환

목소리만 듣고 차별적인 얼굴 이미지 생성

얼굴 이미지만 보고 사람의 성향을 추론

AI의 편향을 악용하는 오남용 우려 커져

사람처럼 판단하고 생각하는 인공지능(AI) 기술이 화제다. 문장 한 두 마디의 설명을 듣고 그림이나 사진으로 묘사하는 AI가 등장했다. 사람의 목소리만 듣고 그 사람의 얼굴 생김새를 그려내는 AI나 사람의 얼굴만 보고 그 사람의 성향을 추측하는 AI도 주목 받는다. 기술의 발전이 놀랍지만 AI가 인간의 지능을 닮아 갈수록 편향과 오남용의 우려는 커진다.

얼마 전 미국의 오픈AI(OpenAI)가 문장 한 두 마디를 듣고 사진이나 그림을 만들어내는 ‘DALL-E 2’를 공개한 바 있다. DALL-E 2는 고해상도의 이미지를 짧은 응답 시간안에 생성하고 포토샵이나 디지털 아트 기술 없이 간단한 도구와 텍스트 수정으로 이미지를 쉽게 편집할 수 있다.

[관련기사]오픈AI, 텍스트를 고해상도 이미지로 생성하는 AI 시스템 ‘DALL-E 2’ 개발

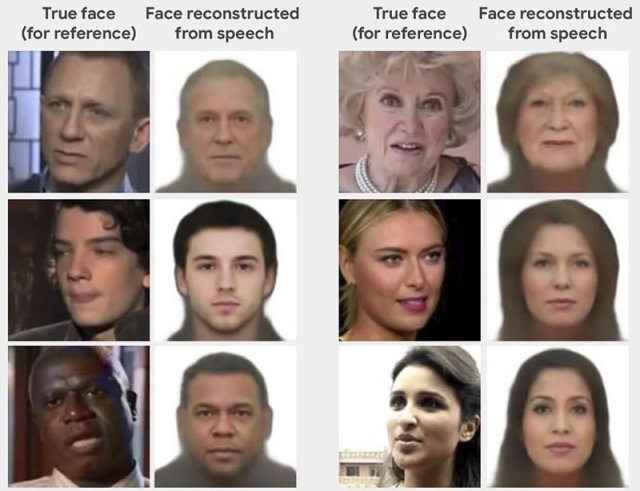

유사한 기술로, 앞서 미국 매사추세츠 공과대학교(MIT)의 컴퓨터 과학·인공지능 연구소(CSAIL) 소속 연구원들이 공개한 목소리 인식 AI 기술 ‘Speech2Face’가 화제가 됐었다. 이 인공지능은 사람의 목소리를 듣고 억양과 높낮이, 단어와 발음을 토대로 그 사람의 얼굴 생김새를 추론한다.

MIT 연구원들은 유튜브에 올라온 동영상 수백만 개를 활용해 심층 신경망을 설계하고 사람 얼굴과 목소리의 특성 사이의 상관관계를 학습했다. 이러한 상관 관계를 통해 화자의 나이, 성별 및 인종을 추측할 수 있었다. 데이터에 수동으로 레이블을 지정할 필요가 없었기 때문에 훈련 과정에 인간의 개입은 없었다. AI는 단순히 엄청난 양의 비디오를 받아 음성 특징과 얼굴 특징 간의 상관 관계를 학습하는 임무를 맡았다. 그 결과 Speech2Face는 사람의 목소리만 듣고도 놀라울 정도로 정확하게 그 사람의 얼굴을 재현했다.

이 두 AI 기술도 일부 AI 기술의 사례와 마찬가지로 악용될 가능성이 제기됐다. 오픈AI는 DALL-E 2가 나쁘게 쓰이지 않도록 음란·폭력·증오 관련 단어와 문구를 데이터베이스에서 지웠다. 사람의 얼굴을 만들지 못하게 설계하고 이 기술을 일반 소비자에게는 제공하지 않는다.

Speech2Face의 결과는 성별, 인종 및 출신 국가 등에 대한 강한 편견을 내포하고 있다. 목소리가 높은 사람은 여성으로, 목소리가 낮은 사람은 남성으로 분류하는 경향이 있다. 아시아 언어를 사용하는 사람들은 아시아인으로 분류된다. 예를 들어 중국 남성은 중국어로 말할 때 아시아인으로, 영어로 말할 때 백인으로 식별됐다.

소리에 따라 사람의 인종이나 민족적 배경을 말할 수 있다고 생각하지만 종종 잘못된 경우가 많다. 억양과 같은 요인에 의존하여 사람의 출신 국가를 예측하는 것은 위험하다. 많은 사람들, 특히 이민자들은 출신 국가 또는 현재 거주 국가와 극적으로 다른 억양을 가질 수 있다. 특정 그룹의 사람들에 대한 표준 ‘외관’이 있다고 가정하면 그것은 위험한 발상이다.

MIT는 Speech2Face를 만들 때 유튜브의 동영상을 활용한 만큼 데이터 분포가 균등하지 않다고 밝혔다. 이어 이 기술을 사람의 목소리의 특징을 연구하고 더 많은 응용 프로그램을 만들기 위해 개발했다고 강조했다.

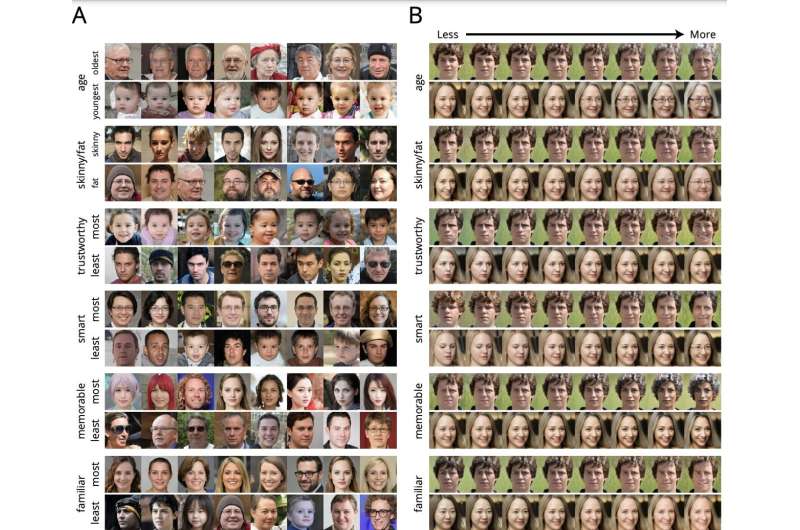

스티븐스 공과대학(Stevens Institute of Technology)의 연구원들은 프린스턴 대학 및 시카고 대학과 협력해 이러한 첫인상을 모델링 하고 얼굴 사진을 기반으로 사람들이 어떻게 인식될지 예측하는 AI 모델을 개발했다.

사람들은 첫 대면에서 순식간에 서로를 가늠하고 외모만으로 상대방의 나이부터 지능, 믿음직스러움까지 모든 것을 판단한다. 이러한 첫 인상은 종종 부정확하지만 매우 강력해서 우리의 관계를 형성하거나 채용이나 재판 등 많은 영역에 영향을 미칠 수 있다.

연구팀은 수천 명의 사람들에게 컴퓨터로 생성한 1,000장 이상의 얼굴 사진을 보여주고 나이, 지능, 비만, 신뢰성, 친근함, 매력도, 외향성 등의 34개 속성에 대한 첫 인상을 묻고 순위를 매기게 했다. 그런 다음 사람들의 응답을 신경망 훈련에 사용했다. 신경망에 사람의 얼굴 사진을 보여주면 그 사람의 특성을 추론한다.

알고리즘이 특정한 특성을 사람에게 부여하는 이유를 이해하기 어려운 부분이 있었지만 내놓은 결과의 많은 부분은 일반적인 직관 또는 사회적 통념과 일치했다. 예를 들어 웃는 사람은 더 신뢰할 수 있는 사람으로 보이고 안경을 쓴 사람은 더 지능적으로 보이는 경향이 있다. 알고리즘이 내놓은 결과에 대한 이유를 설명하지 않았지만 자신이 어떻게 보이는지 이해하는 데 도움이 될 수 있었다.

이 알고리즘은 원래는 심리학자들이 사회적 인지에 대한 실험에 사용하기 위한 얼굴 이미지를 생성하는 것을 돕기 위해 개발됐지만 실제로는 다른 용도로 사용될 수 있다. 예를 들어 사람들은 자신을 긍정적으로 보이기 위해 가장 지능적이거나 자신감 있고 매력적으로 보이게 한다고 생각하는 사진만 선택해 공개 페르소나로 공유할 수 있다.

더 큰 문제는 이 알고리즘을 사용해 사진을 조작하고 피사체가 특정 방식으로 보이도록 할 수도 있다는 것이다. 예를 들어 어떤 정치인 후보를 더 신뢰할 수 있는 것처럼 보이게 하거나 상대방이 지능이 없거나 의심스러워 보이도록 만들 수도 있다. AI 도구는 실제로 일어나지 않은 사건을 보여주는 ‘딥페이크’ 비디오를 만드는 데 이미 사용되고 있지만 새로운 이 알고리즘은 피사체에 대한 시청자의 의견을 조작하기 위해 실제 이미지를 미묘하게 변경할 수 있다.

연구팀은 그들의 기술을 보호하기 위해 특허를 확보했고 현재 사전 승인된 윤리적 목적을 위해 알고리즘을 라이선스하는 스타트업을 만들고 있다고 밝혔다. 또한 이 기술이 해를 끼치는 데 사용되지 않도록 할 수 있는 모든 조치를 취하고 있다고 강조했다.

AI타임스 박찬 위원 cpark@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com