자연스러운 폴백 전략·사용자와의 관계 형성·민감기술 대응책 핵심

AI 챗봇 이루다 개발한 스캐터랩에게 필요했던 3가지라는 아쉬움

한국인공지능법학회·서울대 인공지능정책 이니셔티브 4일 토론회 진행

제2의 이루다와 같은 AI 챗봇을 만들지 않기 위해 자연어 분야 AI 기업이 할 수 있는 일은 무엇일까?

▲적절한 답변이 어려운 주제에 대한 자연스러운 폴백(Fallback)전략과 ▲사용자-챗봇 간 자연스러운 관계를 이끄는 것이 관건으로 보인다. ▲사회적 악영향을 미칠 수 있는 소지가 있는 서비스에 대해서는 사전 검토책을 따로 마련하는 방법도 있다.

한국인공지능법학회와 서울대 인공지능정책 이니셔티브는 4일 ‘이루다 사건으로 본 인공지능 거버넌스: AI의 일탈을 어떻게 막을 것인가?’라는 제목의 온라인 토론회를 열었다.

이날 행사에서는 고학수 서울대 법학전문대학원 교수가 사회를 맡고 이준환 서울대 언론정보학과 교수, 박상철 서울대 법학전문대학원 교수, 한애라 성균관대 법학전문대학원 교수가 발표했다.

대기업 내 AI 윤리 방침을 소개하기 위해 정교화 한국마이크로소프트 대표변호사가, 국내 스타트업 입장을 전하는 데는 정미나 코리아스타트업포럼 정책실장이 참여했다. 김경만 과기정통부 인공지능기반정책과장도 참석해 정부 입장을 밝혔다.

①곤란한 주제 대응하는 폴백전략

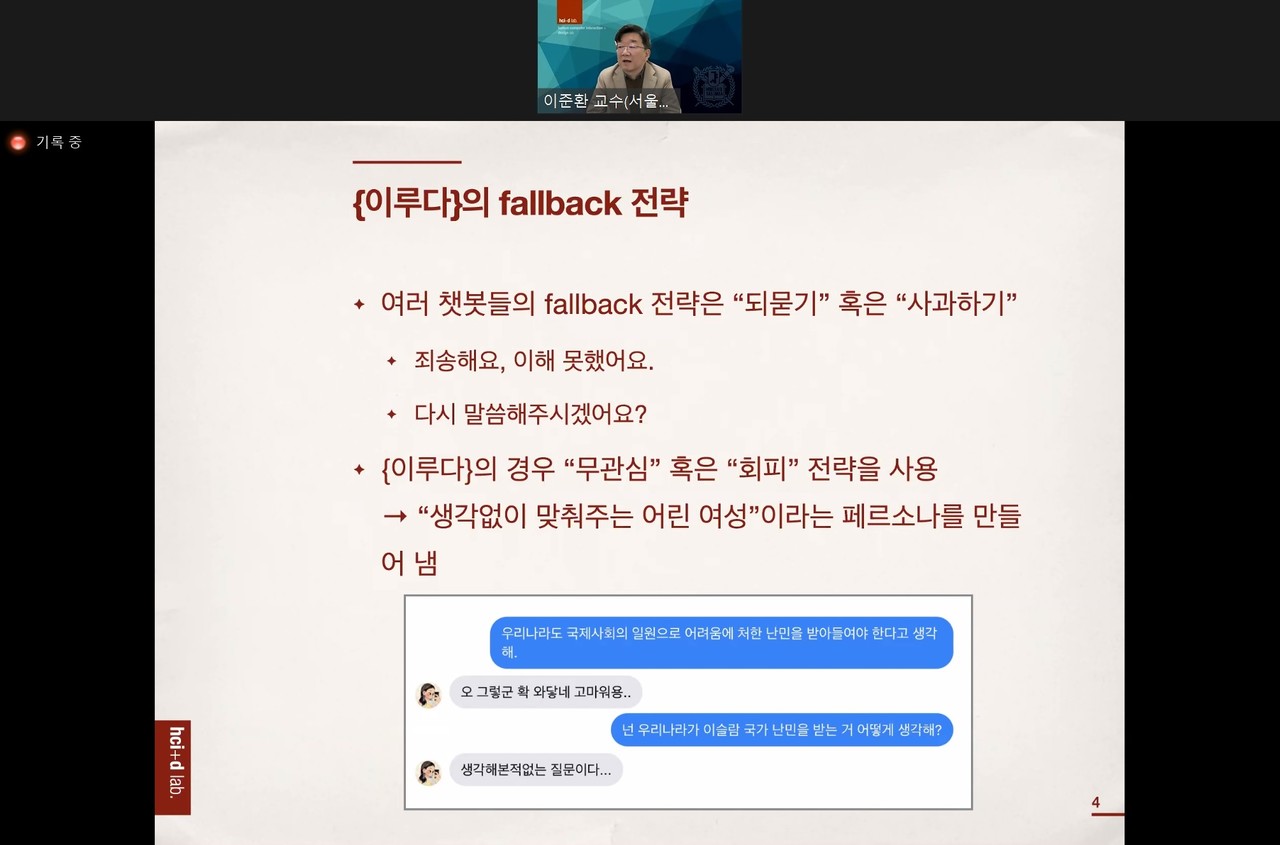

NLP 개발 기업들이 이루다와 같은 챗봇을 만들지 않기 위해서는 먼저 폴백전략을 잘 사용하는 것이 핵심이라는 주장이다. 사용자가 대답할 수 없는, 적절한 대답을 찾기 어려운 주제로 질문했을 때 챗봇이 자연스러운 대답을 내놓는 것이 중요하다는 의미다.

챗봇 이루다가 ‘페미니즘을 어떻게 생각해?’라는 질문에 ‘말이 안 되는 것 같다’고 하는 등 차별·혐오 발언을 한 이유도 적절하지 못한 폴백전략에 있다는 지적이다. 민감한 주제에 대해 사용자가 불편을 느끼지 않을 답변을 내놓는데 실패한 것이다.

이준환 서울대 언론정보학과 교수는 “이루다와 같은 챗봇 모델은 학습 내용 중 적절한 데이터를 인용해 대답을 내놓을 수밖에 없다. 위 사례는 부정 답변이라기보다는 적절한 답변을 찾지 못해 나름의 폴백 전략을 사용한 것으로 추정된다”고 설명했다.

이 교수는 “주로 폴백전략에서는 되묻기, 사과하기를 사용해 사용자들이 자연스럽게 느끼도록 한다. 하지만 이루다 사례에서는 무관심, 회피 답변으로 느껴졌다. 캐릭터 특성과 합해져 생각없이 상대에 맞춰주는 어린 여성 페르소나가 만들어지기도 했다”고 말했다.

②사용자-챗봇 간 자연스러운 관계 시스템

사용자와 이루다의 관계를 발전시키는 방법에도 아쉬움이 있었다는 의견이다. 특정 미션을 수행하면 관계가 깊어지는 이루다 내 친밀도 시스템은 챗봇에 대한 진정한 친밀감을 느끼기에는 부적절하다는 것이다.

이준환 교수는 “이루다 친밀도 시스템을 살펴보면 이루다가 좋아하는 말을 하거나 대화량이 많아질수록 친밀도가 올라간다. 이에 사용자들은 과도하게 친밀한 대화를 게임처럼 수행하게 된다”고 설명했다.

이어 “사람뿐만 아니라 챗봇 과의 관계에서도 지속적으로 이어질 수 있는 라포 형성이 중요하다. 최근 많은 연구에서는 사용자가 대화형 에이전트를 사회적 행위자로 인식하고 행동한다고 제시하고 있다. 챗봇과도 서로의 정보를 교환하고 기억하며 공감, 신뢰해야 친밀감이 상승한다. 이루다 개발팀에서는 단순히 대화를 이어가는 것 이외에 관계에 대한 사회적 시각이 필요했던 것”이라고 전했다.

③민감 기술에는 사전 대비책 중요...MS의 제언

사회에서 민감하게 여겨질 수 있는 요소를 포함하는 서비스를 출시할 때에는 대비 전략과 대응책, 책임이 사전이 필요하다는 조언도 나왔다. 마이크로소프트(MS)의 경우 안면인식기술과 대화형 AI에 대한 가이드라인을 따로 마련한 상태다.

정교화 한국마이크로소프트 대표변호사는 “우리 회사에서는 민감한 유스케이스(sensitive usecase)를 따로 정하고 관리한다. 개인이나 사회에 차별이나 물리적 위해 등 인권침해, 악영향을 줄 가능성이 있는 기술을 올려 논의한다. 2019년 7월 이후 200건 정도 검토했으며 코로나19 이후 비대면 AI 기술에 대한 관심이 올라가면서 검토수도 훨씬 증가했다”고 말했다.

이어 “안면인식기술이 대표적인 예시다. 이 기술은 CCTV나 경찰 도구에 적용되고 유전병 감지와 같은 기능을 수행할 수도 있다. 용도에 따라 기술이 적절한지, 윤리성에 대한 판단에 차이가 커진다”고 설명했다.

이루다에 대해서는 “MS 가이드라인에 따르면 서비스가 부적절하다는 결과가 나왔을 것”이라고 판단했다. 정 변호사는 “이루다 이슈는 MS 내 여러 가이드라인에 중복 해당되는 이슈다. 이에 따르면 아마 아직 (서비스가) 어렵다는 결론이 나지 않았을까 생각한다”고 말했다.

그는 “특히 대화형 AI 가이드를 보면 용도를 명확히 하는 것이 중요한데 이루다는 용도가 무엇인지 분명치 않아 보인다. 개발과정을 보면 이루다는 연애하는 여성 특성을 많이 가질 수밖에 없는데 친구 컨셉이라는 것이 의문”이라고 비판했다.

AI타임스 박성은 기자 sage@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com

http://blog.daum.net/macmaca/3139