Pathways 아키텍처, 5,400억 개의 매개변수, Transformer 기반 모델

문제 해결 방법을 학습해 모든 문제를 해결할 수 있는 단일 AI 모델

프로그래밍, 수학 문제 해결 및 농담을 설명할 수 있는 최신 언어 모델

구글이 프로그래밍, 수학 문제 해결 및 농담을 설명할 수 있는 새로운 언어 모델인 PaLM (Pathways Language Model)을 공개했다.

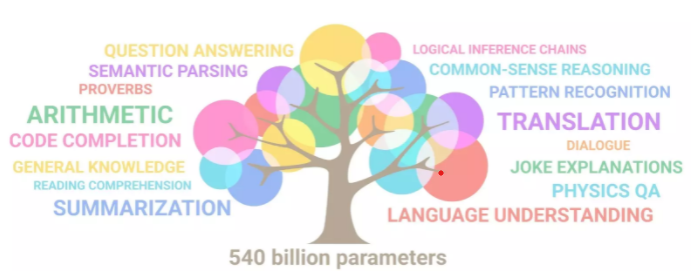

PaLM은 6,144개의 TPU v4 칩을 결합해 단일 모델을 효율적으로 훈련할 수 있도록 하는 Pathways 시스템으로 학습된 5,400억 개의 매개변수, 트랜스포머(Transformer) 기반 모델이다. PaLM은 수백 가지의 언어 이해 및 생성 작업에 대해 시험됐으며 현재까지 만들어진 다른 언어 모델보다 학습 효율성이 높다.

특정 작업을 매우 잘 수행하도록 학습된 알고리즘을 만드는 일반적인 접근방식과 달리 Pathways는 문제를 해결하는 방법을 학습해 모든 문제를 해결할 수 있는 단일 AI 모델을 만드는 접근방식이다. 이렇게 하면 수천 개의 다른 작업을 완료하기 위해 수천 개의 알고리즘을 훈련하는 방식을 피할 수 있다.

PaLM은 고품질 웹 문서, 책, 위키피디아, 대화 및 깃허브(GitHub) 코드를 포함하는 영어 및 다국어 데이터 세트의 조합을 사용해 학습했다. 또한 모든 공백(코드에 중요)을 유지하고 어휘에 없는 유니코드 문자를 바이트로 분할하며 숫자를 각 자릿수에 대해 하나씩 개별 토큰으로 분할하는 ‘무손실’ 어휘를 구성했다.

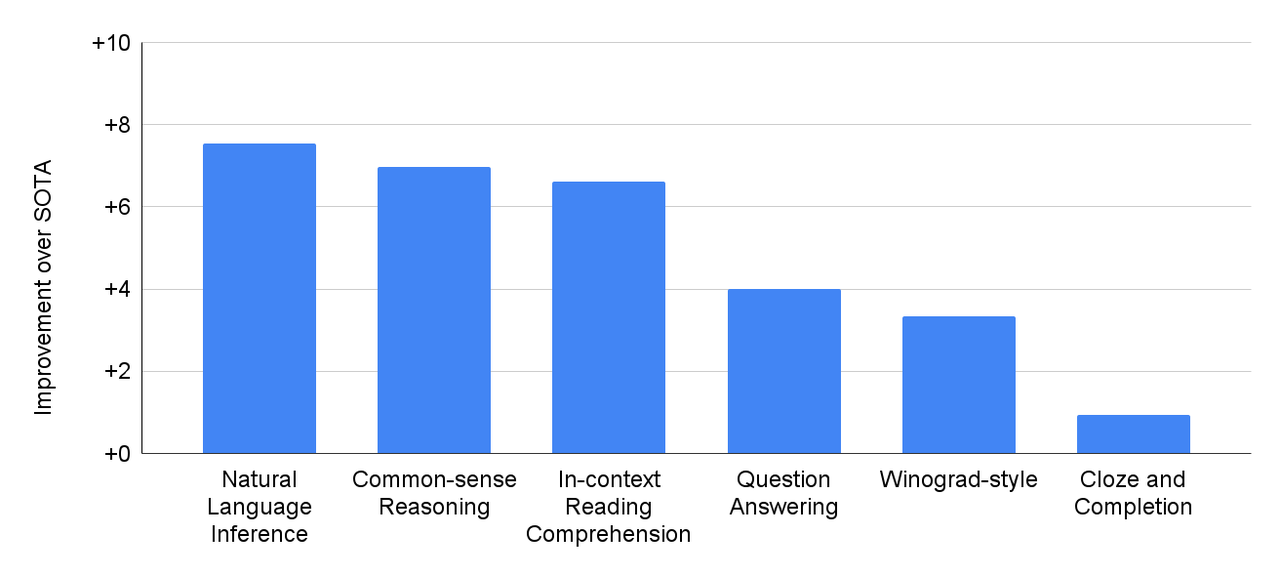

질의 응답, 문장 완성, 문맥 이해, 상식 추론 등 널리 사용되는 29개의 영어 자연어 처리(NLP) 작업에 대해 PaLM을 평가했다. PaLM은 29개 작업 중 28개 작업에서 GLaM, GPT-3, Megatron-Turing NLG, Gopher, Chinchilla 및 LaMDA와 같은 언어 모델의 성능을 능가했다 .

PaLM은 언어 모델에 대한 벤치마크인 BIG-bench에서 우수한 자연어 해석 및 생성 기능을 보여준다. 예를 들어 모델은 원인과 결과를 구별하고, 적절한 맥락에서 개념적 조합을 이해하며, 이모티콘으로 영화를 추측할 수도 있다.

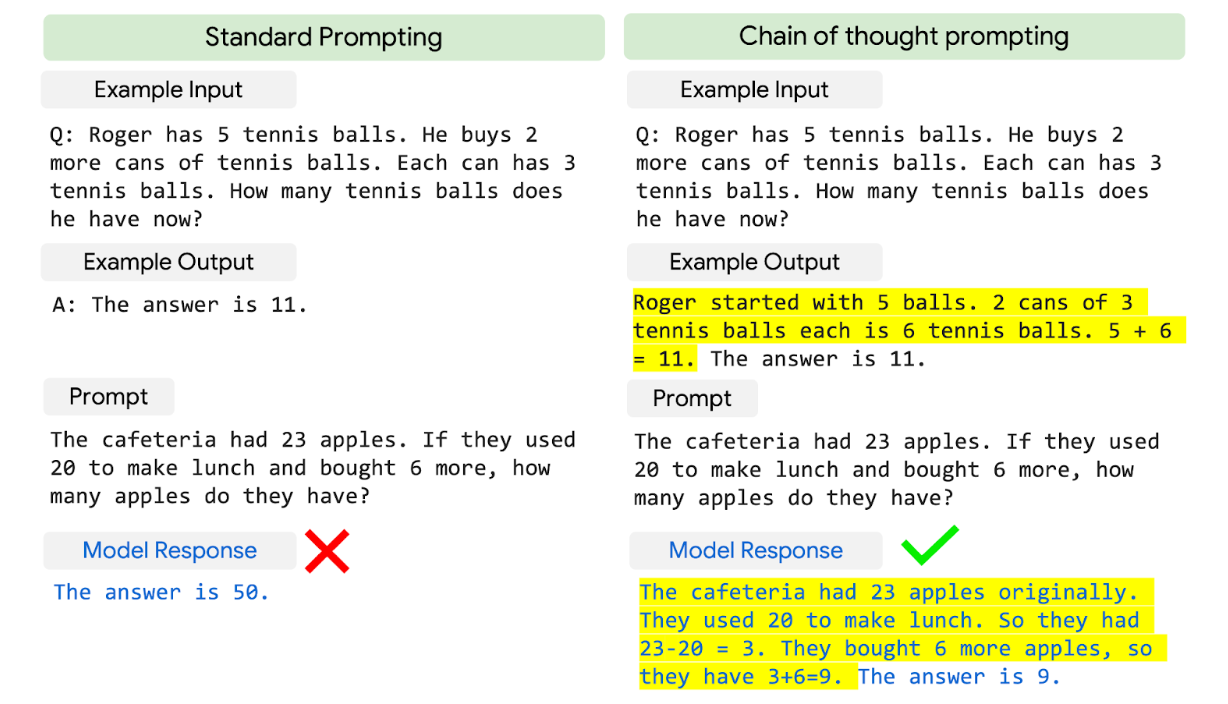

모델 규모를 사고 연쇄 프롬프링과 결합함으로써 PaLM은 다단계 산술 또는 상식적인 추론이 필요한 추론 작업에 대한 획기적인 기능을 보여준다. Gopher와 같은 언어 모델은 성능 향상에 있어 모델 규모의 이점이 적었다.

PaLM에서 3개의 산술 데이터 세트와 2개의 상식적인 추론 데이터 세트에 대한 사고 사슬 프롬프트가 결합된 강력한 성능을 관찰했다. 예를 들어 PaLM은 8번의 프롬프팅을 통해 수천 개의 초등학교 수준 수학 문제의 벤치마크인 GSM8K 문제의 58%를 해결해 GPT-3 모델이 기록한 최고 점수 55%를 능가한다. 이 새로운 점수는 질문 세트의 대상인 9-12세 어린이의 실제 평균 점수 60%에 근접한 것이다.

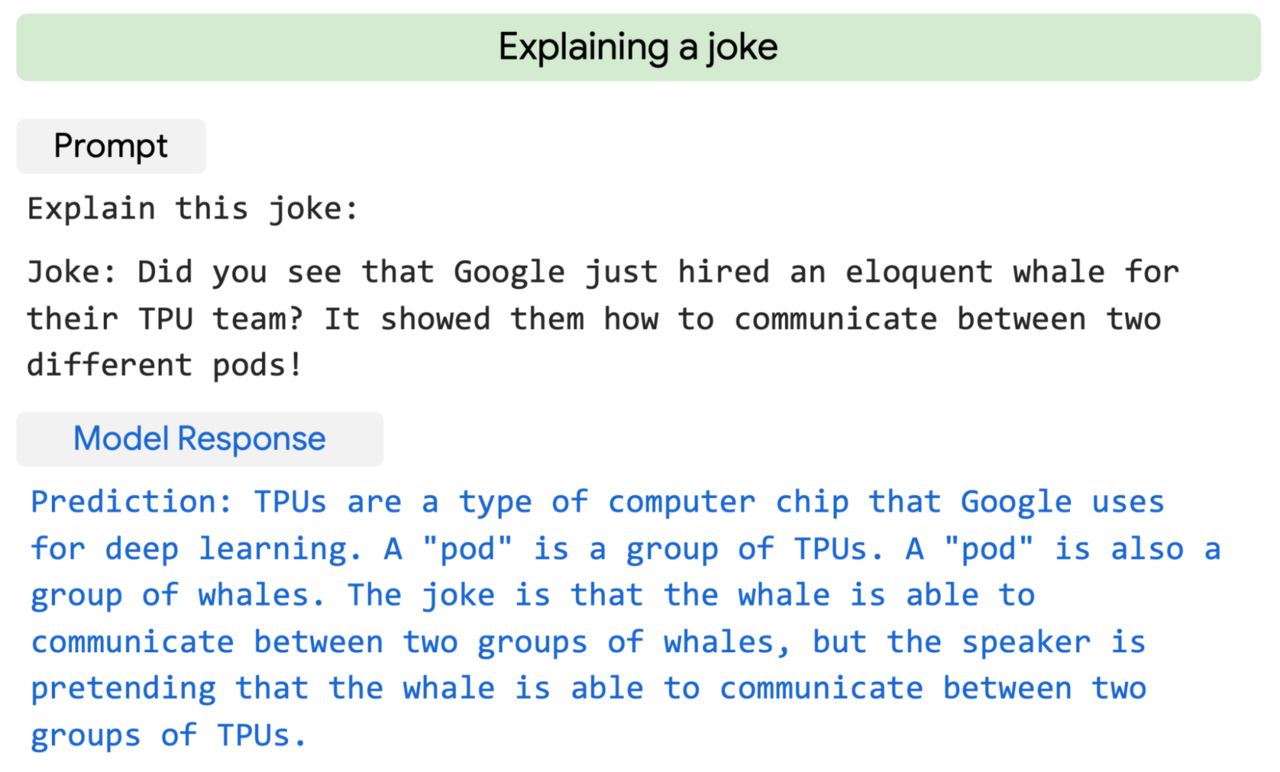

놀랍게도 PaLM은 다단계 논리적 추론, 세계 지식 및 깊은 언어 이해의 복잡한 조합이 필요한 시나리오에 대한 명시적인 설명도 생성할 수 있다. 예를 들어 웹에서 찾을 수 없는 참신한 농담에 대한 고품질 설명을 제공할 수 있다.

PaLM은 자연어 설명이 제공된 코드 작성(텍스트에서 코드로), 한 언어에서 다른 언어로 코드 번역 및 컴파일 오류 수정을 기반으로 코드를 작성하여 프로그래밍할 수 있다. 사전 훈련 데이터 세트에 5%의 코드만 있음에도 PaLM는 단일 모델의 코딩 및 자연어 작업 전반에 걸쳐 고성능을 보여준다. 50배 적은 Python 코드로 훈련하지만 OpenAI의 Codex와 동등한 성능을 보여준다. 이 결과는 더 큰 언어 모델이 다른 프로그래밍 언어와 자연어 데이터로부터 학습을 더 잘 전달하기 때문에 더 큰 모델이 더 작은 모델보다 더 효율적일 수 있다는 것을 시사한다.

AI타임스 박찬 위원 cpark@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com