IBM 세뜨 도브린 부사장, 비즈니스에 AI 활용하기 위해서는 '신뢰' 구축이 가장 중요

설명가능한 AI 통해, 편견 스스로 감지하고 사용자에게 알릴 수 있어야

▲AI는 인간 능력 향상 목표▲데이터,아이디어- 창작자의 것 ▲AI 시스템 반드시 투명하게 설명 가능해야

지난해 서울시와 협력... 코로나19 대응책 마련 위한 데이터 수집에 '투명한 AI' 활용

“비즈니스에 활용되는 AI는 신뢰성이 중요하다”

23일 IBM이 화상 브리핑을 개최해 ‘신뢰가능한 인공지능(AI)’을 주제로 AI 기술 개발 준칙을 공개했다.

최근 AI챗봇 ‘이루다’ 사태 이후 AI윤리에 대한 관심이 매우 높아졌다. 최근 네이버와 카카오도 AI 윤리 대책을 발표했다. 국내외 기업이 윤리적 AI로 거듭나기 위해 노력하는 모습이다.

이날 브리핑은 IBM의 AI 전략 부문 최고데이터책임자(CDO) 겸 부사장 세뜨 도브린(Seth Dobrin)의 발표로 진행됐다.

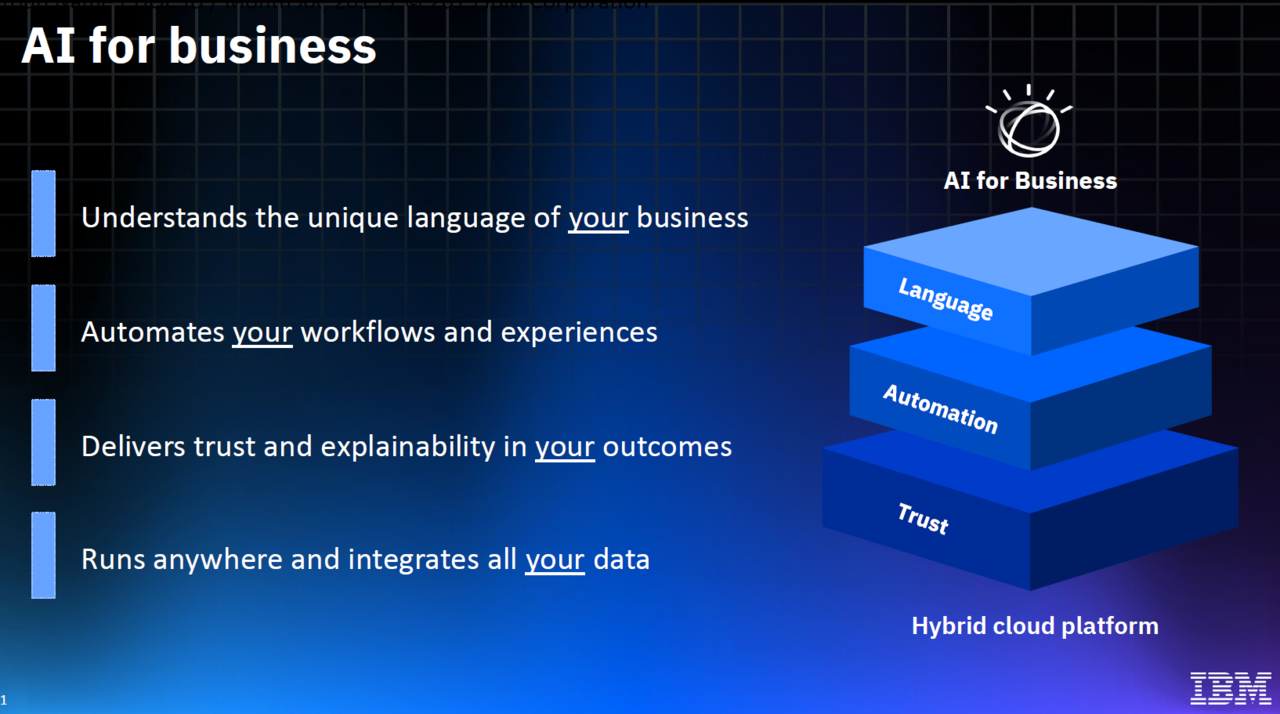

비즈니스 분야에서 AI 서비스를 제공하기 위해 IBM이 주목하는 건 크게 3가지다. ▲비즈니스 언어를 이해하는 AI ▲AI로 자동화 체계 구축 ▲투명하고 설명가능한 AI 등.

IBM이 말하는 비즈니스에 활용될 수 있는 AI란 분야마다 특성이 다른 비즈니스 언어를 AI가 이해하고, 데이터를 요약한 뒤 FAQ와 같은 형식의 알고리즘을 자동 추출할 줄 알아야 한다. 이에 업무 흐름을 자동화해 생산성을 높인다.

이 과정에서 AI가 범할 수 있는 문제를 스스로 감지하고 인간에게 투명하게 설명해 인간이 신뢰할 수 있게 해야 한다.

특히 도브린 부사장이 강조한 건 ‘투명성’과 ‘신뢰’다. AI가 내놓은 예측을 인간이 신뢰할 수 있어야 비즈니스 업무에 활용할 수 있다는 주장이다.

◆비즈니스 AI 가장 중요한 건 ‘신뢰’... IBM AI 개발 준칙 3가지

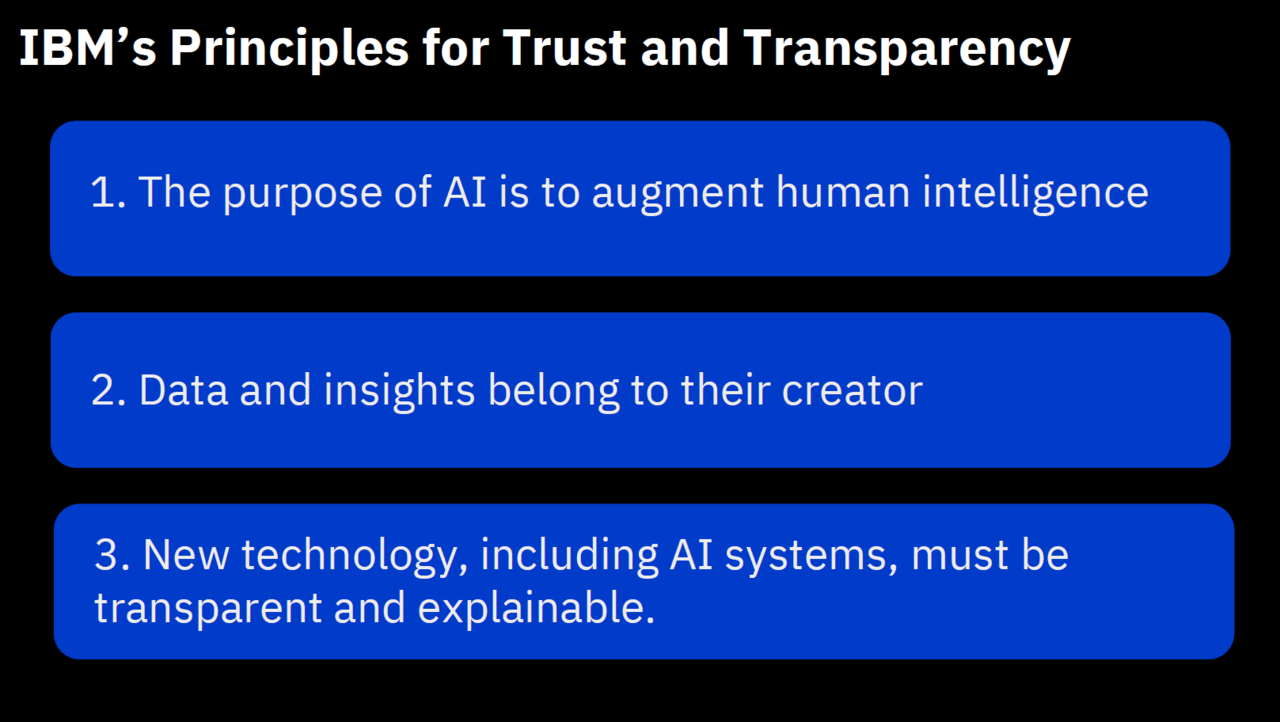

이날 IBM은 AI 개발 투명성 제고 준칙 3가지를 제시했다.

▲AI는 인간의 능력 향상을 목표한다 ▲데이터와 아이디어는 창작자의 것이다 ▲AI 시스템을 포함한 신기술은 반드시 투명하게 ‘설명 가능해야’ 한다.

그에 따르면 AI는 인간의 판단을 대체하는 것이 아닌, 기능을 보완하는 영역이다. 따라서 인간이 AI 예측을 신뢰할 수 있도록 개발해야 한다.

IBM은 AI 모델 개발 플랫폼을 제공할 뿐이며, 데이터나 아이디어에 대한 권리가 없다. IBM은 클라우드에 저장된 고객 데이터를 보호하며, 어떠한 정부 기관에도 제공하지 않는다고 말했다.

기술 기업은 누가 AI를 학습시키고, 어떤 데이터를 입력하는지 투명하게 관리해야 한다. 이에 새로운 기술이 등장해도 앞선 공개 자료를 기반으로 AI 알고리즘이 내놓는 결과를 설명할 수 있어야 한다고 말했다.

◆IBM, 서울시와 ‘투명한 AI’로 협력해 코로나19 시민 데이터 수집

IBM은 지난해 8월 서울시와 협력해 시민들이 처한 코로나19 문제에 대한 설문 조사를 진행하는 ‘아이케어유(I Care You)’ 프로젝트를 실시한 바 있다. 이에 서울시는 시민들에게 코로나19 팬데믹 상황을 극복할 정책 수립 데이터를 수집했다.

서울시는 IBM 왓슨 어시스턴트(Watson Assistant)를 활용해 설문 챗봇을 제작했다. 왓슨 어시스턴트는 사용자가 AI 챗봇을 제작하고 학습시킬 수 있도록 돕는 AI 제작 툴이다.

시민들로부터 식습관, 여가시간, 사회적 상호작용 등 코로나19 이후 일상의 변화를 설문했다. 이에 반복적인 답변을 AI가 알고리즘으로 분석한 뒤 FAQ를 도출해 코로나19 대응 관리를 위한 데이터를 수집했다.

왓슨 어시스턴트로 개발된 AI 챗봇은 수집한 시민과의 대화 기록을 추적하고, 재확인하는 것도 가능해 데이터 투명성을 높인다.

이어 FAQ로 도출된 결과에서 편향된 데이터를 제거하기 위해 왓슨 오픈스케일(Watison OpenScale)이 활용됐다. 왓슨 오픈스케일은 이용자에게 AI가 어떤 과정을 거쳤는지 추적할 수 있도록 돕는 AI 제작 툴이다.

◆‘AI 윤리’ 문제 막기 위해서는... 개발 단계별 검증 필요

도브린 부사장은 이루다 논란처럼 AI가 개인 정보를 학습해 유출하는 사태를 막기 위해 기업이 해야 할 일로 ‘스택형 관리’를 언급했다.

AI 모델 개발을 하나의 단계로 보는 게 아닌, 데이터 수집·비식별화·제공 등 분야를 여러 단계로 나눠 세밀하게 관리해야 된다는 뜻이다.

단계별 모니터링을 통해 AI가 편견을 학습했는지, 잘못된 결과를 도출하지는 않았는지 점검이 필요하다는 주장이다.

AI 투명성을 위해 기업의 알고리즘을 공개해야 되냐는 질문에는 '그렇지 않다'라고 대답했다. 대신 기업이 사용한 AI가 어째서 그런 결과를 냈는지 개인에게 설명할 수 있어야 한다고 말했다.

이에 IBM 왓슨 팩트시트(Watson Factsheets)가 해결책이 될 수 있다고 말했다. 왓슨 팩트시트는 AI 모델의 기반이 되는 알고리즘 종류와 성능을 표기하는 서비스다.

식료품 라벨에 포함된 ‘영양성분표’처럼 AI 모델에도 그 성분을 파악할 수 있는 알림 장치가 있어야 된다는 주장이다.

AI타임스 장희수 기자 heehee2157@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com