인텔, AMD 차세대 칩 공개…엔비디아 아성에 도전

인텔, AMD, 엔비디아, IBM, 구글 등 주요 반도체 기업이 최근 고성능 컴퓨팅(HPC)과 인공지능(AI)를 위한 차세대 칩을 잇따라 공개했다. 차세대 슈퍼컴퓨팅 반도체 시장을 둘러싼 주도권 경쟁이 한층 뜨거워졌다.

몇 년 전까지만 해도 CPU는 인텔과 AMD가 경쟁하고, GPU는 엔비디아가 거의 독점하는 구도였다. 그러나 최근 엔비디아가 데이터 센터를 겨냥해 CPU를 내놓고, 이에 질세라 인텔과 AMD가 맞불 전략으로 GPU 생산 계획을 발표하면서 경계가 허물어지기 시작했다. 경쟁은 날이 갈수록 점입가경이다.

특히 엔비디아가 독주하고 있는 GPU 시장에서는 세트 업체들이 시스템반도체를 직접 설계해 생산하겠다고 나서면서 전선이 확대되는 모양새다.

엔비디아가 CPU를 만들고, 인텔과 AMD는 GPU를 생산하려는 것이다. 여기에 IBM과 구글 등이 필요한 칩을 직접 개발하겠다며 '반도체 독립'을 시도하고 나선 것이다. 이같은 양상은 인공지능(AI)이 거의 모든 기기에 탑재되면서 더욱 심화되고 있다.

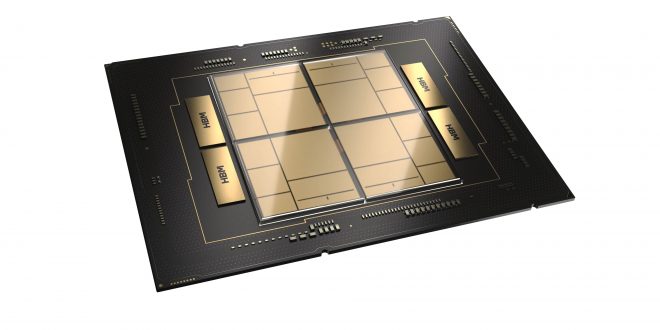

인텔은 내년 초에 '사피르 레피드(Sapphire Rapids) HBM'이라는 새로운 제온(Xeon) CPU 맥스(Max)와 '폰테 베키오(Ponte Vecchio)'라는 데이터 센터 GPU 맥스 제품군을 출시할 계획이라고 발표했다.

인텔이 출시할 예정인 데이터 센터 GPU 맥스는 최대 128GB의 고대역폭 메모리가 있는 최대 128개의 코어로 구성된 47타일 패키지에 1000억개 이상의 트랜지스터를 포함하는 인텔의 고밀도 프로세서다. 408MB의 L2 캐시와 64MB의 L1 캐시를 갖추고 있어 처리량과 성능을 높여준다. 아르곤 국립 연구소의 오로라 슈퍼컴퓨터에 장착될 예정이다.

인텔은 이 제품이 물리적 분야 가상 원자로의 NekRS 시뮬레이션 처리에서 엔비디아 A100을 50% 앞서고, 금융 거래에 사용되는 신용 옵션 가격 분석 처리에서 A100의 2.4배에 달한다고 주장했다.

AMD는 인텔의 제온 신제품을 상대하기 위해 최근 4세대 데이터 센터 CPU 라인업인 AMD EPYC 9004 ‘제노아’를 출시했다.

제노아는 데이터 센터를 위한 업계 최초의 5nm(나노미터) x86 CPU다. 플래그십 96코어 192스레드 EPYC 9654는 5나노미터 노드 및 4세대 마이크로아키텍처와 결합된 AMD의 칩렛 기반 칩 설계 덕분에 단일 섀시에 최대 192개의 코어와 384개의 스레드를 포함하는 슬림 서버를 구축할 수 있다. 제노아는 성능면에서 이전 3세대에 비해 클럭당 명령(IPC)이 14% 증가했다.

AMD는 제노아가 '인텔 아이스 레이크 제온'보다 정수 및 부동 소수점 연산 모두에서 코어당 최대 30% 더 높은 성능을 제공한다고 주장했다. 아이스 레이크 제온과 '제온 CPU' 맥스 시리즈보다 60% 더 많은 코어를 제공한다는 것이다.

AMD는 특히 이 제품을 인텔이 최신 데이터 센터 칩인 제온 CPU 맥스 시리즈 출시 지연 문제로 어려움을 겪는 시기에 출시하는 등 인텔을 정조준했다.

델 EMC 파워에지 서버는 이미 AMD의 3세대 EPYC 프로세서로 구동되고 있으며, 휴렛팩커드는 최근 차세대 서버 발표에서 EPYC 제노아 라인을 도입했다.

리서치 회사 IDC에 따르면 x86 아키텍처 기반 클라우드 서비스에 사용되는 AMD의 칩 시장 점유율은 2016년 0%에서 지난해 약 29%로 증가했다. IDC는 AMD가 계속해서 퍼블릭 클라우드 배포에서 시장 점유율을 높일 것으로 전망했다.

AMD는 조만간 출시할 MI250X MCM GPU도 자세하게 공개했다. MI250X는 현존하는 최상위 엑사스케일 슈퍼컴퓨터에 탑재할 목적으로 성능을 극대화한 새로운 아키텍처다. TSMC 6nm 공정에서 생산할 계획이다.

MI250X MCM GPU는 기존 MI100 GPU와 비교해 FP64 Matrix 성능이 3.8배 증가하고 FP32 및 FP16 성능은 2.1배 증가한 것이 특징이다. 총 580억개의 트랜지스터를 2개의 GPU에 탑재했다. 128GB 용량의 HBM2e 메모리와 3.2TB/s급 메모리 대역폭을 제공한다.

AMD는 MI250X GPU를 구성하는 10개의 칩을 보유하고 있다. GPU 다이와 HBM2 메모리 다이가 혼합돼 있는데, 각 GPU 다이는 110개의 컴퓨팅 유닛으로 구성됐다. MCM GPU에는 총 220개의 컴퓨팅 유닛이 있다. GPU당 7168개의 스트림 프로세서로 분할해 총14080개의 스트림 프로세서를 제공한다.

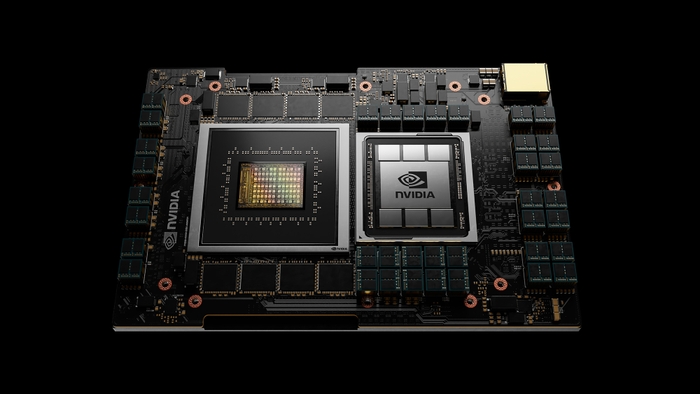

엔비디아는 최근 서버용 프로세서 '그레이스(Grace) CPU'를 발표하며 CPU 시장 경쟁 참여를 선언했다. 장치 및 시스템 수준에서 전력 소비와 성능을 최적화하면서 데이터 센터 컴퓨팅, 특히 AI 처리를 위해 설계한 CPU라는 설명도 곁들였다.

그레이스 CPU는 엔비디아 패브릭과 분산 캐시 설계를 연결하는 메시 상호 연결 아키텍처인 SCF(Scalable Coherency Fabric)를 사용한다. SCF는 메모리, CPU 코어 및 I/O를 포함해 Grace CPU 내의 다양한 내부 하위 시스템을 연결하기 위한 것이다. 최대 117MB의 L3 캐시를 지원하고, 최대 72개 이상의 코어까지 확장 가능한 2,335.6GB/s의 이중 섹션 대역폭을 제공할 수 있다.

그레이스 CPU는 2개의 프로세서를 NVLink-C2C로 결합한 총 144개의 Arm Neoverse 코어로 구성된다. NVLink-C2C 비트당 1.3피코줄을 소비하는 데이터 전송 덕분에 기존 PCIe Gen 5 표준의 5배 에너지 효율성으로 900Gb/s의 속도로 프로세서와 그래픽 카드를 연결한다. 최대 효율성을 위해 LPDDR5X 메모리를 사용한다. 이 칩은 메모리에서 초당 테라바이트의 대역폭을 가능하게 하는 동시에 전체 전력 소비를 500와트로 유지한다.

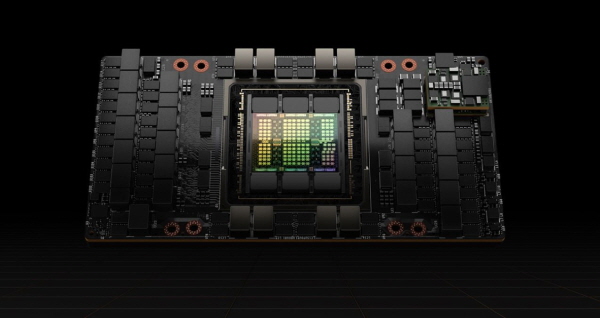

또 엔비디아는 'H100 텐서 코어(Tensor Core) GPU'가 본격 생산에 돌입했다고 밝혔다. 지난 4월에 처음 공개된 H100은 A100보다 9배 높은 대규모 훈련 성능과 30배 높은 대규모 언어 모델 추론 처리 제공한다. H100은 800억개의 트랜지스터를 탑재하고, TSMC 4nm 공정에서 제조된다.

델 테크놀로지스, 휴렛펙커드 엔터프라이즈, 레노버, 슈퍼마이크로와 클라우드 서비스 공급업체 AWS, 구글 클라우드, 마이크로소프트 애저, 오라클 클라우드 등이 H100을 기반으로 한 제품 및 서비스를 출시할 계획이다.

엔비디아는 Arm IP를 기반으로 H100 GPU와 그레이스 CPU를 결합한 아키텍처를 설계, 대규모 AI와 HPC(고성능 컴퓨팅)를 실현하겠다는 전략이다.

엔비디아는 AI 워크로드와 HPC 부문의 최근 MLPerf 벤치마크 테스트 결과를 공개했다. H100 GPU는 MLPerf AI 워크로드 부문에서 훈련 모델에 대한 세계 기록을 세웠다. 기존 최고 성능의 A100 GPU보다 최대 6.7배 더 높은 성능을 제공했다.

IBM과 구글은 독자적인 AI 칩을 선보였다.

IBM은 딥러닝 작업을 실행하기 위해 32개의 프로세싱 코어와 230억 개의 트랜지스터를 포함하는 새로운 AI 시스템온칩(SoC) ASIC(Application Specific Integrated Circuit) ‘AIU(AI 장치)’를 공개했다. 화면에서 음성 언어, 텍스트 또는 이미지를 처리하는 딥 러닝을 위해 AIU를 설계했다. AIU는 사용하기 쉬운 그래픽 카드로 설계했다. PCIe(PCI Express) 슬롯이 있는 모든 컴퓨터 또는 서비스에 연결할 수 있다.

IBM은 칩을 처음부터 설계하지 않고 2021년 8월에 출시된 텔룸(Telum) 칩에 내장된 AI 가속기의 확장 버전을 사용했다고 밝혔다. IBM AIU의 32개 코어는 IBM의 z16 시스템을 구동하는 텔룸 칩에 내장된 AI 코어와 유사하다. 차이점은 텔룸은 크기가 7나노미터(nm)인 트랜지스터를 사용하는 반면 AIU는 더 빠르고 더 작은 5nm 트랜지스터를 사용한다.

IBM은 딥 러닝 모델용 CPU 또는 GPU를 실행하면 결국 작업을 완료할 수 있지만 가장 효율적이거나 최선의 방법은 아니라고 말했다. 딥 러닝을 위한 행렬 및 벡터 곱셈 연산 유형에 최적화된 다목적 칩이 필요했다. AIU 아키텍처는 다목적 CPU보다 단순한 레이아웃이 특징이며 한 컴퓨팅 엔진에서 다음 컴퓨팅 엔진으로 직접 데이터를 보내도록 설계되어 에너지를 절약할 수 있다.

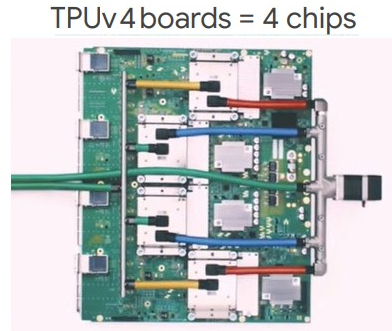

구글은 4세대 TPU(Tensor Processing Unit)를 구글 클라우드를 통해 일반 대중에게 출시했다. TPU는 AI 학습 및 추론에 쓰이는 구글의 반도체 칩이다. 구글 클라우드의 TPU v4 기반 가속기는 가상머신(VM) 1개당 4개의 TPU 칩으로 구성된 단일 TPU 모듈에서 고속 패브릭을 통해 최대 4096개의 칩(TPU VM 1024개)을 연결한 포드(Pod)에 이르기까지 다양한 구성으로 사용할 수 있다. 각 칩의 최고 성능은 275테라플롭이며 각 포드는 최대 1.1엑사플롭의 컴퓨팅 성능을 제공한다.

TPU 가속기는 본질적으로 MXU라고 하는 큰 행렬 연산 엔진의 집합이며, 고대역폭 메모리와 프로그래밍을 가능하도록 만드는 몇 개의 CPU 코어에 의해 제어된다. CPU 코어는 고속 처리를 위해 AI 행렬 연산을 MXU에 공급한다. 각 TPU VM은 각각 2개의 CPU 코어와 총 128GB의 메모리가 있는 4개의 칩으로 구성된다. TPU v4는 TPU v3보다 2배 커진 최대 32GB의 메모리에 액세스할 수 있게 해주며, 2배 더 빠른 임베딩 가속을 제공해 대규모 추천 모델 학습의 성능을 개선하는 데 도움이 된다.

구글은 미국 오클라호마 데이터 센터에 TPU v4를 이용해 9엑사플롭스의 연산 성능을 지원하는 세계 최대 규모의 머신러닝(ML) 클러스터를 구축했다.구글은 이것이 적어도 일반 대중이 액세스할 수 있는 세계에서 가장 큰 허브가 되었다고 주장했다.

박찬 위원 cpark@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com