오픈 Ko-LLM 리더보드

한동안 국내 미세조정의 대명사였던 '라마 2' 대신 프랑스 미스트랄 AI의 오픈 소스 모델 ‘미스트랄 7B’가 새 인기 모델로 떠올랐다.

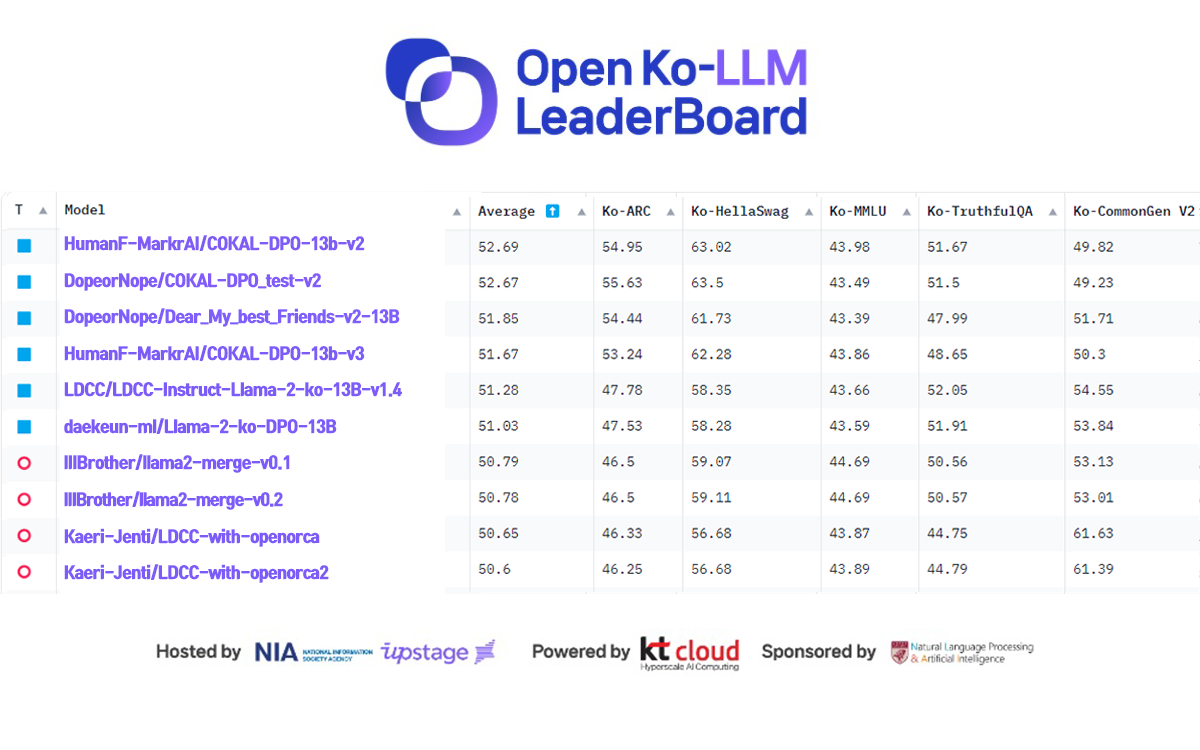

업스테이지와 한국지능정보사회진흥원(NIA)이 공동으로 주최하는 '오픈 Ko-LLM 리더보드' 12월 1주 상위권은 여전히 '라마 2 13B'를 베이스로 한 모델이 상위권을 점령하고 있다.

그러나 7B 분야에서는 미스트랄 일색이다. 7B 이하 분야 10위권에는 미스트랄 7B를 미세조정한 모델이 무려 8개다. 10위 이하에서도 비슷한 양상이다.

이중 엔터테크 전문 기업 미니레코드는 지난달 22일 7B 이하 순위에서 미스트랄 7B를 베이스로 한 미니케로드의 ‘Minirecord/Mini_synatra_7b_02’로 1위에 올랐다.

이에 앞서 10월30일자 1위를 차지한 마인즈앤컴퍼니의 모델 'MNC-Jihun/Mistral-7B-OP-u1k-ver0.7'도 마찬가지다.

지난 9월27일 오픈 Ko-LLM 리더보드가 오픈됐을 당시 등록된 50여개의 모델은 대부분 라마 2를 베이스로 하고 있었다. 물론 아직도 상위권에는 라마 2 13B가 주를 이루고 있다.

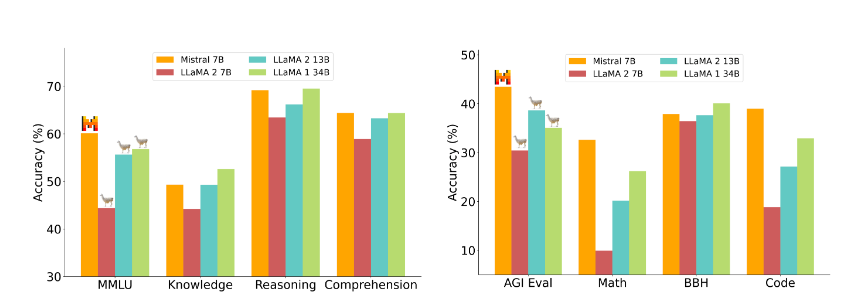

그러나 역시 9월27일 출시된 미스트랄 AI의 모델은 매개변수가 73억개인데도, 벤치마크 전 분야에서 메타의 라마 2 13B를 능가했으며 매개변수 340억개인 '라마 1 34B'까지 상당 분야에서 뛰어넘는 등 뛰어난 성능을 갖춘 것으로 알려졌다.

이 때문에 국내 개발자들에게도 채택, 10월 중순부터 리더보드에 서서히 모습을 드러내기 시작했다. 그리고 1개월여 만에 본격적으로 한국어에 최적화, 본격적으로 순위에 모습을 드러내기에 이르렀다.

이런 점을 감안하면 향후 미스트랄 기반 모델이 라마 2 13B를 밀어내고 오픈 Ko-LLM 리더보드 메인 순위까지 점령할지 지켜볼 만하다.

이에 대해 박찬준 업스테이지 테크니컬 리더는 "미스트랄 모델은 라마 2와는 달리 '그룹 쿼리 어텐션(GQA)' 구조를 채택, 빠른 추론이 가능해졌다"라고 소개했다.

이어 "사전훈련 모델(Pre-trained)로 이 분야에서 'beomi/llama-2-koen-13b'에 이어 두번쨰로 뛰어난 성능을 보이고 있다”라며 "미스트랄이 영어 모델임에도 2등이라는 것은 다국어에도 매우 강한 좋은 모델이라는 말"이라고 설명했다.

더불어 최근 일론 머스크의 xAI가 내놓은 '그록'이나 중국 스타트업 01.AI가 공개해 화제가 된 ‘Yi-34B’ 등 오픈 소스 모델이 기존 폐쇄형의 성능을 거의 따라잡은 것으로 알려져, 향후 이들 모델이 Ko-LLM 리더보드에 등장할지도 지켜볼 만하다. 미스트랄 AI도 내년 현재 7B보다 큰 모델을 상업용으로 출시하겠다고 밝힌 바 있다.

한편 이번 주 순위는 11월 3주차 리더보드와 큰 변동 사항이 없다.

이승유 사람과숲-마커AI 컨소시엄 개발자(DopeorNope)가 여전히 강세로, 1~3위를 모두 차지했다. 또 4위에 오른 'HumanF-MarkrAI/COKAL-DPO-13b-v3' 역시 마커AI의 작품이다.

반면 2주전 3위였던 롯데정보통신이 5위로, 4위였던 김대근 연구원의 'daekeun-ml/Llama-2-ko-DPO-13B'이 6위로 밀려난 정도로 큰 변화는 없다.

리더보드 상세 내용은 NIA 홈페이지나 허깅페이스 홈페이지에서 확인할 수 있다.

이주영 기자 juyoung09@aitimes.com

무단전재 및 재배포 금지

기사제보 및 보도자료 news@aitimes.com