안면인식 기술 편향성에 대한 논란이 뜨거운 감자로 떠오르고 있는 가운데 28일(현지시간) IT 전문매체 벤처비트가 알고리즘 차이나 데이터세트 다양성이 안면인식 편향성 문제를 해결하지 못한다는 다수의 연구 결과를 소개했다.

안면인식 기술 편향성에 대한 연구는 그동안 여러 차례 실시되면서 지속적으로 문제점이 지적돼왔다. 특히 현재 사용되고 있는 안면인식 알고리즘은 인종 뿐만 아니라 성별 등 다양한 범주에 따라서도 편향성을 나타냈다.

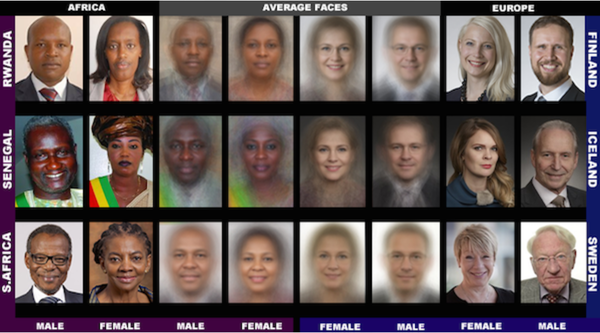

최근 미국 위치토주립대학교 연구진은 수만 개의 얼굴 이미지를 포함한 데이터세트로 훈련된 알고리즘을 조사한 결과 안면인식 모델들의 인종 편향성을 확인했다. 해당 연구에 따르면 안면인식 알고리즘 모델들은 백인과 비교해 흑인과 중동인, 라틴계 사람들에 대한 인식률이 훨씬 떨어지는 것으로 나타났다. 물론 이번 연구는 안면인식을 위해 미세 조정되지 않은 모델을 대상으로 조사가 이뤄졌다는 점에서 한계가 있으나, 알고리즘 편향성을 다시 한번 확인시켜준 셈이다.

지난해 미 상무부 기술관리국 산하 미국표준기술연구소(NIST)의 연구보고서에 따르면 안면인식 소프트웨어 대다수가 안면인식 정확도에 있어 인종‧성‧연령별로 편차를 보였다. 백인에 비해 아시아인과 아프리카계 미국인에 대한 안면인식 오류율이 더 높은 것으로 나타냈다. 알고리즘에 따라 오류 편차는 있으나 최소 10배에서 최대 100배 차이를 보이기도 했다.

또 콜로라도대학교 볼더캠퍼스 연구진은 지난해 가을 발표한 논문에서 아마존과 마이크로소프트, 클래리파이 등 여러 기업이 제공하는 안면인식 서비스가 생물학적 성과 성 정체성이 일치하지 않는 ’비시스젠더(non-cisgender)‘를 인식하는 데 얼마나 오류가 많은지를 밝혀냈다. 테스트 결과 이들 AI 알고리즘이 시스젠더 남녀는 95% 이상의 정확도로 인식하는 반면 트랜스남성을 여성으로 잘못 인식하는 경우가 무려 38%에 이르는 것으로 나타났다.

젠더쉐이즈(Gender Shades) 프로젝트와 미국 표준기술연구소(NIST) 역시 주요 판매업체들의 시스템을 대상으로 독자적인 테스트를 수행하면서 안면인식 기술이 인종‧성별로 편향성을 보이고 있다는 사실을 알아냈다. 현행 안면인식 프로그램이 경우에 따라서는 96% 이상 사람들을 잘못 분류할 만큼 매우 부정확할 수 있다는 게 연구진의 설명이다.

연구진은 오픈소스 이미지넷(ImageNet) 데이터세트에서 120만개의 이미지를 토대로 사전 훈련된 VGG, ResNet, InceptionNet 등 세 가지 모델에 초점을 맞춰 연구를 진행했다. 구조적 차이를 지닌 모델들을 기반으로 테스트한 결과 시스템의 편향성은 특정 알고리즘에 기인하지 않으며, 왜곡‧편향된 데이터세트가 인종‧성별 정확도 차이를 더욱 심화시킬 수 있음을 시사했다.

연구진은 포즈나 조명, 메이크업 등과 같은 변수가 인식 분류 정확도에 미치는 영향에 대해서도 연구할 계획이라고 밝혔다.

[관련기사] 국제앰네스티, EU에 안면인식 기술 대중국 수출 규제 강화 촉구

[관련기사] 트위터, 이미지 크롭 알고리즘 인종 편향성 논란 사과