엔비디아(Nvidia), 암(Arm), 인텔(Intel) 등 반도체 3사가 더 빠르고 효율적인 AI 시스템 개발을 추구하기 위해 '8비트 부동 소수점(FP8)' 표준 형식을 제안했다.

엔비디아는 15일(현지시간) 암 및 인텔과 공동으로 AI 학습 및 추론 모두에 작동하면서 하드웨어 메모리 사용을 최적화하고 AI 개발을 가속화할 수 있는 FP8 표준 형식을 제안했다고 블로그를 통해 발표했다.

AI 시스템을 개발할 때 데이터 과학자는 시스템 학습을 위해 단순히 데이터를 수집하는 것 이상의 주요 엔지니어링 선택에 직면한다. 그 중 하나는 시스템의 가중치를 나타내는 형식을 선택하는 것이다.

가중치는 시스템의 예측에 영향을 미치는 훈련 데이터에서 학습된 요소다. 예를 들어 'GPT-3'가 문장 길이의 프롬프트에서 전체 단락을 생성하거나 '달리2'와 같은 시스템이 프롬프트에서 사실적인 이미지를 생성할 수 있도록 하는 것이다.

일반적인 형식으로는 16비트를 사용해 시스템의 가중치를 나타내는 '반정밀도 부동 소수점(FP16)'과 32비트를 사용하는 '단정밀도(FP32)'가 있다. 반정밀도 이하에서는 AI 시스템을 훈련하고 실행하는 데 필요한 메모리 양을 줄이면서 계산 속도를 높이고 대역폭과 전력 사용량을 줄일 수 있다. 그런 이득을 얻기 위해 대신 어느 정도 정확도를 희생한다.

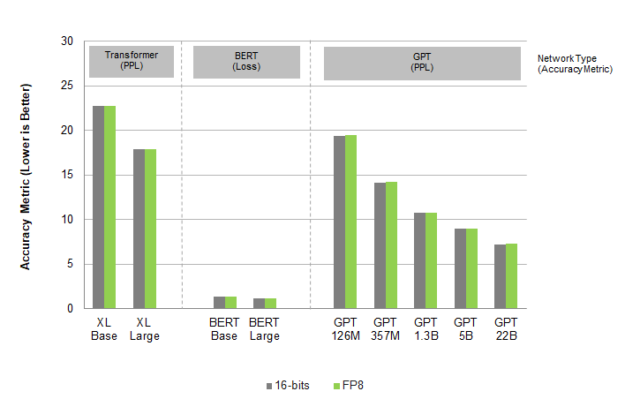

그러나 반도체 3사를 비롯한 많은 기업이 FP8을 기본 형식으로 통합하고 있다. 샤 나라심한 엔비디아 마케팅 이사는 "FP8 형식이 컴퓨터 비전 및 이미지 생성 시스템을 포함한 사용 사례에서 16비트 수준의 정확도를 보여주면서 상당한 속도 향상을 제공한다"고 언급했다.

3사는 FP8 형식을 라이선스가 필요 없는 개방형 형식으로 만들고 있다. 사양을 IEEE(전기전자공학자협회)에 표준으로 제출할 예정이다.

나라심한 이사는 "상호 교환 가능한 공통의 표준 형식을 채택함으로써 하드웨어 및 소프트웨어 플랫폼 모두의 빠른 발전과 상호 운용성이 AI 기술을 발전시킬 수 있다"고 강조했다.

박찬 위원 cpark@aitimes.com

[관련기사]엔비디아, GPU 벤치마크 테스트서 기술력 입증

[관련기사]핫칩스34에서 맞붙은 미래 반도체 전쟁