인공지능(AI) 기술을 활용해 눈으로만 말해도 알아듣고 전달하는 앱이 나왔다. 그동안 언어장애를 비롯해 의사소통에 어려움을 겪는 이들이게 희소식이 될 전망이다. 또 샤워 중이거나 긴급한 상황일 경우 등 다양하게 사용될 수 있을 것으로 보인다.

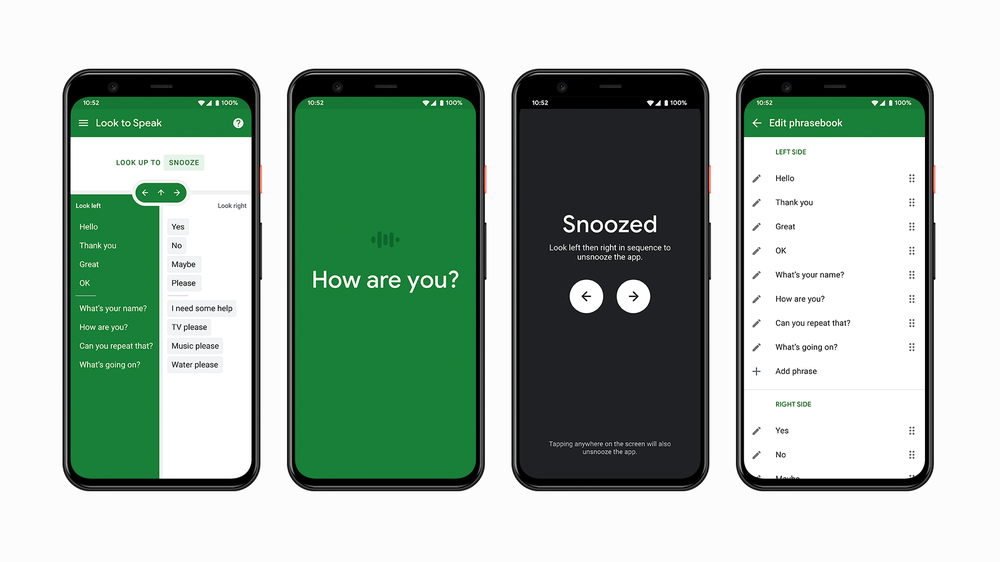

구글이 인공지능(AI)을 기반으로 언어장애와 운동장애를 가진 사용자들이 원활하게 의사소통할 수 있도록 시선을 추적함으로써 문구를 선택해 소리 내어 읽어주는 안드로이드용 시범 앱(‘Look to Speak’)을 출시했다고 지난 8일(현지시간) 영국 일간지 인디펜던트 등 외신이 전했다.

앱 사용자들은 눈의 움직임만으로도 개개인 맞춤으로 사전에 설정된 단어와 문장을 자신의 휴대폰 화면에서 선택할 수 있다. 구글 측은 블로그 게시글에서 “이 앱을 통해 사람들은 왼쪽‧오른쪽‧위쪽 등 그저 눈으로 보기만 해도 구절 목록에서 자신이 하고 싶은 말을 빠르게 고를 수 있다”고 말한다.

앱은 시선 추적 AI 기술과 정면 카메라 등을 이용해 사용자의 의도를 파악한다. 개인화된 단어와 문장을 디바이스를 통해 목소리로 전달할 수 있다는 게 구글 측의 설명이다. 또 눈의 감도 설정을 조정할 수 있어 사용자가 휴대폰을 사용하는 동안 의도치 않게 문장을 선택하는 일이 없도록 설계됐다.

일반적으로 시선 추적 장치는 대개 휴대하기 힘들고 비용이 많이 든다. 예를 들어 '토비(Tobii) 아이 트래커 4C(Eye Tracker 4C)'의 경우 가격이 최소 150달러다. 해당 앱은 무료로 누구나 이용 가능하며 안드로이드 9.0 이상 버전과 호환된다. 앱의 모든 사적인 데이터는 비공개로 앱이 설치된 휴대폰에만 저장된다.

(영상=구글 유튜브).

한편 구글은 지난 11월에 시각장애인과 저시력 사용자를 위한 ‘프로젝트 가이드라인(Project Guideline)’을 공개했다. AI를 활용해 시각장애를 가진 이들이 스마트폰으로 러닝 코스를 안내받을 수 있도록 돕겠다는 취지다.

또 구글은 컴퓨터 비전 기술로 포장된 식품을 식별하고 편지나 우편물 등을 보다 쉽게 검토할 수 있도록 문서를 스캔해 시각장애인에게 알려주는 앱 ‘룩아웃(Lookout)’을 개발하고 있다. 이 밖에도 구글은 언어장애인의 의사소통을 돕는 ‘유포니아(Euphonia) 프로젝트’ 등 장애인 사용자를 위한 다양한 서비스 개발에 주력해오고 있다.