카이스트(KAIST)가 기계학습ㆍ인공지능 분야 국제적인 학회 ICLR 2021 세계 연구 기관별 순위에서 TOP 7에 올랐다. (원문링크)

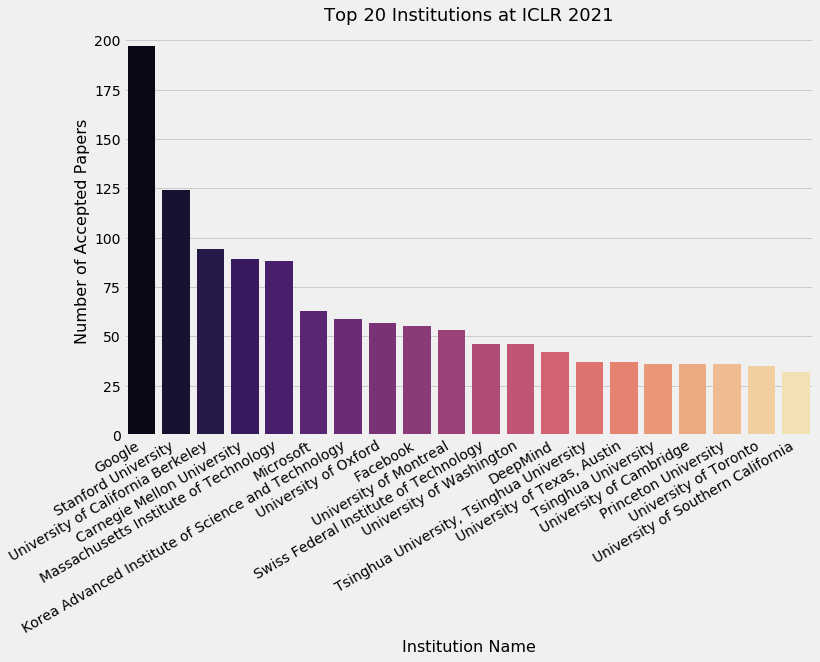

18일 ICLR 2021이 선정한 탑 20 기관 순위에 따르면 ▲1위 구글 ▲2위 스탠포드대 ▲3위 버클리대 ▲4위 카네기멜런대 ▲5위 MIT ▲6위 마이크로소프트로, 모두 20편을 제출(Accepted)한 카이스트는 7위로 분석됐다.

이는 페이스북, 딥마인드, 옥스포드대 등 세계 굴지 연구기관보다 앞서는 성과다.

카이스트 논문 20편 중 16편은 인공지능(AI)대학원이 제출했다. 카이스트 인공지능대학원은 지난해 세계적인 인공지능 관련 학회 ▲NeurIPS에 총 20편 ▲ICML에 11편 ▲AAAI에 8편이 각각 등재된 바 있다.

이번 ICLR 2021에는 연구논문 2997편이 제출되고, 860편의 논문이 채택되어 28.7%의 채택률을 나타냈다.

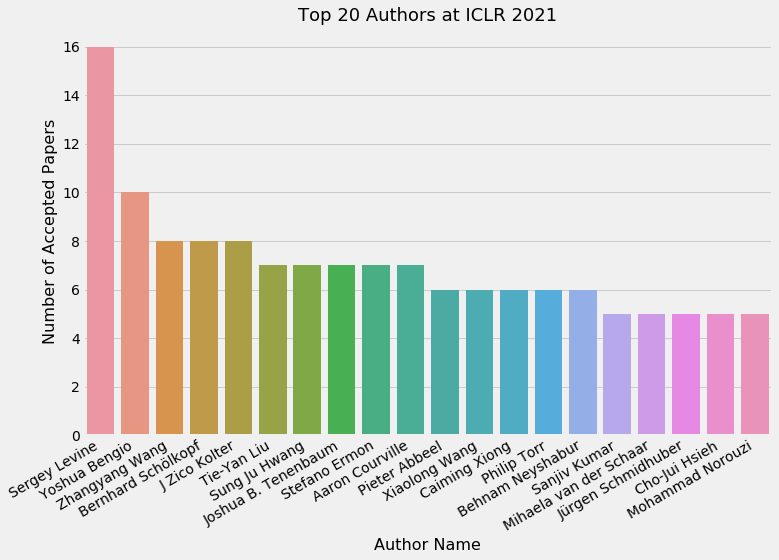

한편, 개인별 순위에서는 탑 20 저자들 중에서 황성주 교수가 7 편으로 6위, 신진우 교수는 5 편으로 16위를 기록했다.

다음은 황성주 교수 참여 논문 목록

▲Meta-GMVAE: Mixture of Gaussian VAE for Unsupervised Meta-Learning Dong Bok Lee, Dongchan Min, Seanie Lee, and Sung Ju Hwang (Spotlight Presentation)

▲Accurate Learning of Graph Representations with Graph Multiset Pooling Jinheon Baek, Minki Kang, and Sung Ju Hwang

▲Federated Semi-Supervised Learning with Inter-Client Consistency & Disjoint Learning Wonyong Jeong, Jaehong Yoon, Eunho Yang, and Sung Ju Hwang

▲Rapid Neural Architecture Search by Learning to Generate Graphs from Datasets Hayeon Lee, Eunyoung Hyung, and Sung Ju Hwang

▲Contrastive Learning with Adversarial Perturbations for Conditional Text Generation Seanie Lee, Dong Bok Lee, and Sung Ju Hwang

▲Learning to Sample with Local and Global Contexts in Experience Replay Buffer Youngmin Oh, Kimin Lee, Jinwoo Shin, Eunho Yang, and Sung Ju Hwang

▲FedMix: Approximation of Mixup under Mean Augmented Federated Learning Tehrim Yoon, Sumin Shin, Sung Ju Hwang, and Eunho Yang

ICLR 2021에 접수된 나머지 9편의 논문 목록

▲Minimum Width for Universal Approximation

Sejun Park, Chulhee Yun, Jaeho Lee, and Jinwoo Shin (Spotlight Presentation)

▲Winning the L2RPN Challenge: Power Grid Management via Semi-Markov Afterstate Actor-Critic

Deunsol Yoon, Sunghoon Hong, Byung-Jun Lee, and Kee-Eung Kim (Spotlight Presentation)

▲Monte-Carlo Planning and Learning with Language Action Value Estimates

Youngsoo Jang, Seokin Seo, Jongmin Lee, and Kee-Eung Kim

▲Training GANs with Stronger Augmentations via Contrastive Discriminator

Jongheon Jeong and Jinwoo Shin

▲Representation Balancing Offline Model-based Reinforcement Learning

Byung-Jun Lee, Jongmin Lee, and Kee-Eung Kim

▲Layer-adaptive Sparsity for the Magnitude-based Pruning

Jaeho Lee, Sejun Park, Sangwoo Mo, Sungsoo Ahn, and Jinwoo Shin

▲i-Mix: A Strategy for Regularizing Contrastive Representation Learning

Kibok Lee, Yian Zhu, Kihyuk Sohn, Chun-Liang Li, Jinwoo Shin, and Honglak Lee

▲BOIL: Towards Representation Change for Few-shot Learning

Jaehoon Oh, Hyungjun Yoo, ChangHwan Kim, and Se-Young Yun,

▲FairBatch: Batch Selection for Model Fairness

Yuji Roh, Kangwook Lee, Steven Euijong Whang, and Changho Suh

AI타임스 배준영 기자 jybae0127@aitmes.com