텍스트는 물론 이미지까지 읽어내고 생성하는 대형멀티모달모델(LMM)이 차세대 모델의 기준으로 떠오르는 가운데 LMM의 ‘환각’을 수정하는 도구가 등장했다. 기존처럼 특정 데이터로 모델을 재훈련해서 환각을 해결하는 것이 아니라, 생성된 텍스트에서 문제가 되는 부분을 직접 골라 수정한다는 점에서 주목된다.

벤처비트는 25일(현지시간) 중국 과학기술대학교와 텐센트 연구진이 LMM에서 환각을 수정하도록 설계된 ‘딱따구리(Woodpecker)’라는 프레임워크 논문을 온라인 아카이브(arXiv)에 게재했다고 보도했다.

LMM의 환각은 생성된 텍스트가 입력한 텍스트와 일치하지 않는 현상을 말한다.

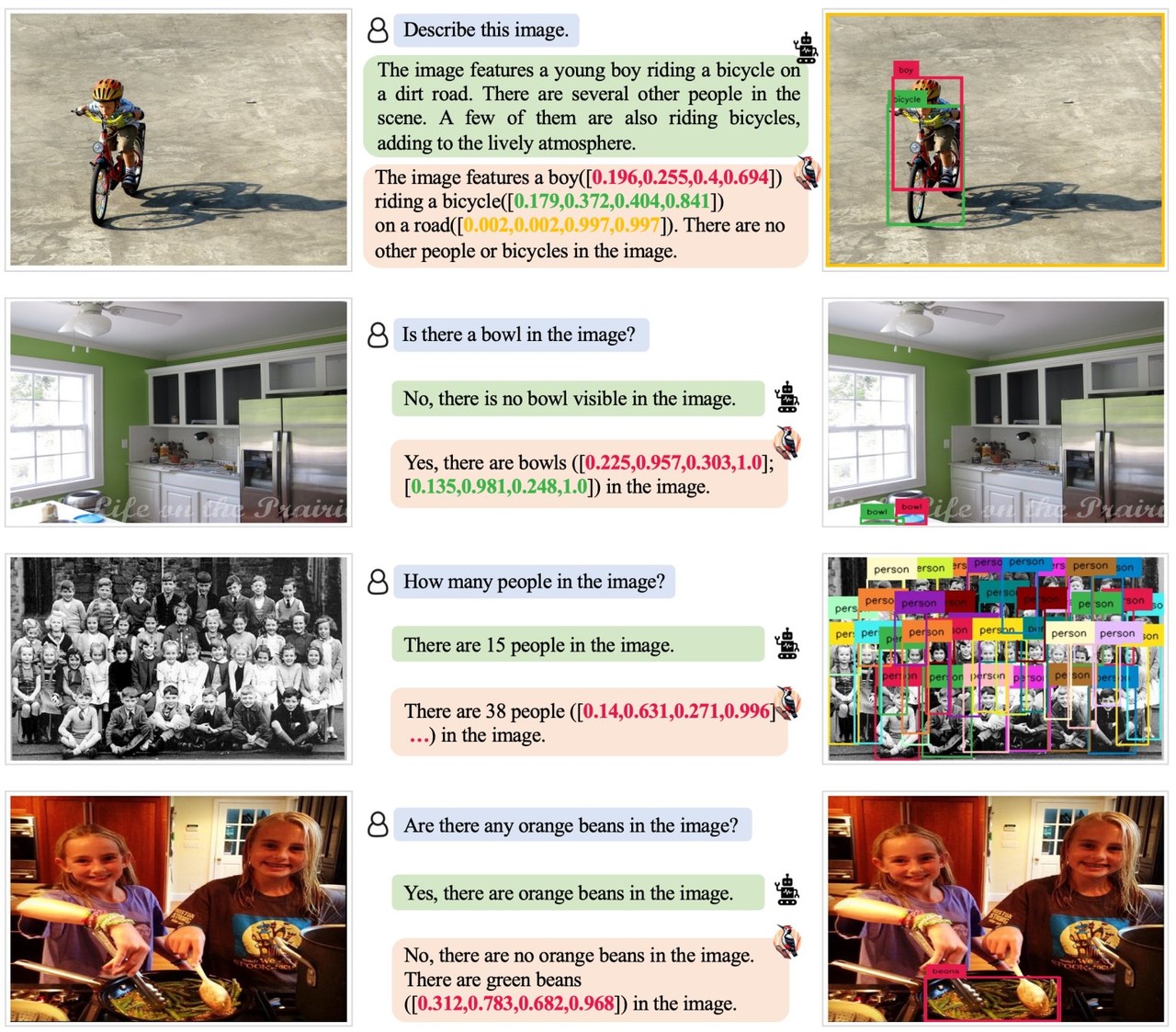

이번에 발표된 딱따구리는 ▲핵심 개념 추출 ▲질문 공식화 ▲시각적 지식 검증 ▲시각적 주장 생성 ▲환각 교정 등 5단계 프로세스를 거쳐 생성 콘텐츠를 진단한 뒤 필요한 부분을 수정한다.

딱따구리는 먼저 본문에 언급된 주요 개체를 식별한다. 그 다음 추출된 객체에 대해 개수와 속성 등 질문한다. 시각적 지식 검증 단계에서는 전문가 모델을 사용해 이런 질문에 답한다.

이후 질문-답변 쌍을 이미지에 대한 시각적 지식 기반으로 변환한다. 마지막으로 시각적 지식 기반의 안내에 따라 환각을 수정하고 해당 증거를 추가한다.

연구진은 “딱따구리가 나무를 치료하는 것처럼 생성된 텍스트에서 AI 파이프라인의 각 단계별로 문제가 되는 부분을 골라 수정한다”라고 설명했다.

또 유효성을 평가하기 위해 다양한 데이터세트를 활용해 실험을 진행했다. 그 결과 POPE 벤치마크에서는 '미니GPT-4' 모델의 정확도는 54.67%에서 85.33%로, '엠플러그-오울(mPLUG-Owl)' 모델은 62%에서 86.33%로 크게 향상된 것을 발견했다.

기존 대형언어모델(LLM)보다 활용폭이 넓은 LMM은 차세대 AI 모델의 기준으로 변하고 있다. 얼마전 공개된 오픈AI의 'GPT-4V'를 시작으로 내년 출시 예정인 구글의 차세대 모델 '제미니'가 그 예다. 그러나 LLM에서 그랬듯 LMM의 환각은 실제 적용에 큰 장애물로 꼽힌다.

연구진은 "재학습 없이 환각을 교정할 수 있는 딱따구리 프레임워크는 LMM의 판도를 바꾸는 중요한 역할을 할 것'이라고 강조했다.

딱따구리는 오픈소스로 제공되며, 깃허브에서 사용할 수 있다.

박찬 기자 cpark@aitimes.com