중국의 오픈 소스 대형언어모델(LLM) ‘Yi’의 컨텍스트 창 크기가 현재 최고 수준인 20만 토큰인 것으로 알려졌다. 늘어난 컨텍스트 창으로 인한 성능 향상으로 오픈AI나 앤트로픽 등 폐쇄형 LLM을 빠르게 따라잡고 있는 것으로 나타났다.

디크립트는 15일(현지시간) 중국의 생성 인공지능(AI) 스타트업 '01.AI'가 출시한 LLM ‘Yi-6B’와 ‘Yi-34B’가 20만 토큰의 컨텍스트 창을 제공한다고 보도했다. 이는 ‘GPT-4 터보’의 12만8000 토큰, 클로드 2의 10만 토큰을 뛰어넘는 수치다.

LLM 컨텍스트 창은 프롬프트 입력에 사용할 수 있는 토큰의 수를 말한다. 컨텍스트 창이 클수록 프롬프트에서 컨텍스트 내 학습(in-context learning)을 수행하는 기능이 향상, 프롬프트 입력으로 더 많은 예제를 제공해 LLM이 더 나은 답변을 제공할 수 있다.

예를 들어 책 한권을 통째로 프롬프트 입력하면 내용에 관련된 질문에 바로 답을 찾아낼 수 있다. 또 LLM 학습 과정에 사용할 수 없었던 새로운 정보도 제공할 수도 있다.

기존에는 AI 모델을 훈련하고 실행하는 GPU의 메모리 제한으로 대규모 입력을 처리할 수 없기 때문에 대규모 입력을 처리하도록 컨텍스트 창의 크기를 확장하는 데에는 한계가 있었다. 하지만 LLM이 경쟁적으로 출시되자, 모델의 성능에 높여주는 것으로 알려진 컨텍스트 창의 크기 확장에도 관심이 모이고 있다.

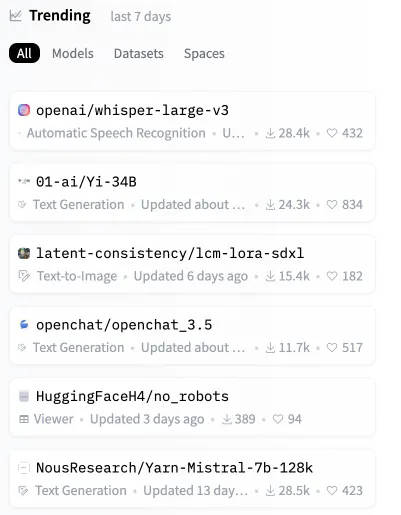

실제로 Yi 모델은 뛰어난 성능으로 출시된 지 몇 시간 만에 허깅페이스의 LLM 리더보드에서 2위에 오르며 이름을 알렸다.

또 벤치마크 테스트 결과에서도 다른 LLM을 능가하는 것으로 나타났다. 글로벌 투자분석 업체 아크 인베스트가 공개한 MMLU(대규모 멀티태스크 언어 이해)' 벤치마크 점수에서 ‘Yi-34B’는 오픈 소스 사상 최고치인 76.3%를 기록, 클로드 2(76.5%)와 흡사한 수준을 기록했다.

01.AI는 "Yi-34B는 '라마 2 70B'나 '팰컨 180B'와 같은 더 큰 모델보다 성능이 뛰어나다"라며 "반면 모델크기가 작아 비용은 적게 드는 등 개발자가 프로젝트를 구축하는 데 안성맞춤"이라고 설명했다.

반면 일반적으로 입력 컨텍스트가 길어지면 성능이 크게 떨어진다는 지적이 있다. 분석 결과 Yi 모델도 입력이 프롬프트 용량의 65% 이상을 차지할 경우 어려움을 겪는 것으로 나타났다.

더불어 큰 컨텍스트 창에는 치명적인 문제도 있다. 토큰 수가 증가함에 따라 비용이 기하급수적으로 증가한다. 예를 들어 토큰 크기를 4000개에서 8000개로 두 배로 늘리면, 비용은 2배가 아니라 4배로 늘어난다. 결국 긴 입력을 처리하면 모델의 계산 속도가 크게 느려지고 비용은 눈덩이처럼 불어날 수 있다.

즉 컨텍스트가 LLM 성능의 모든 것을 말하는 것은 아니라는 뜻이다. 컨텍스트 창 크기 확장에만 의존하는 대신 모델 기술과 모델 사용 간의 균형을 유지하는 것이 중요하다는 지적이다.

하지만 Yi의 가장 중요한 차별성은 컨텍스트 창 말고도, 오픈 소스인데다 로컬에서 온디바이스로 실행할 수 있다는 점이 꼽힌다. 디크립트는 "클로드나 GPT-4가 헤드라인을 장식하는 동안, 이 중국 모델은 사용자의 장치에서 실행될 수 있다"라며 "언젠가 새 컴퓨터를 구입하게 될 경우 그 장치에서 돌아가는 게 Yi라는 것을 발견할 수도 있다"라고 지적했다.

한편 Yi를 개발한 중국의 스타트업 01.AI는 설립 8개월 만에 기업 가치 10억달러(약 1조3000억원)를 넘기며 유니콘에 오른 데다, 출시한 오픈 소스 모델이 뛰어난 성능으로 인기를 글며 단번에 스타급으로 떠올랐다. 이 회사에는 구글 차이나의 전 사장인 이카이푸를 비롯해 구글, 마이크로소프트(MS), 화웨이, 알리바바 등 빅테크 출신의 LLM 전문가들이 포진해 있다.

박찬 기자 cpark@aitimes.com