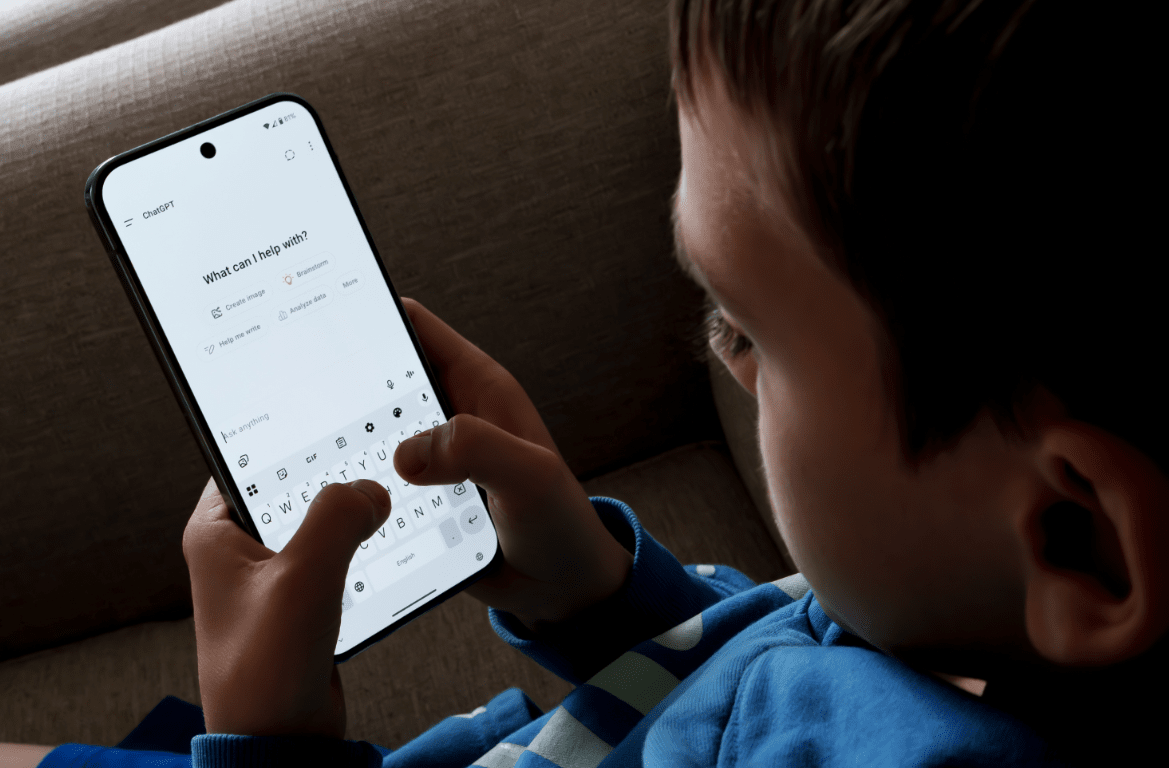

청소년 자살 문제로 고소를 당한 오픈AI가 재발 방지 대책을 공개했다. 장시간 채팅을 경고하고, 성인 인증을 도입해 미성년자 보호를 강화하고, 문제성 대화가 진행되면 차단하거나 전문가를 연결하겠다는 것이 핵심이다.

오픈AI는 26일(현지시간) 블로그를 통해 '사람들이 가장 필요할 때 도움을 준다'라는 글을 올리고, 정신 건강 문제와 관련한 '챗GPT' 조치를 예고했다.

인공지능(AI) 기업들이 사용자를 챗봇에 오랫동안 붙잡아놓기 위해 아첨과 같이 사용자가 듣고 싶은 말을 하도록 설계됐다는 지적을 의식한 듯, "우리의 목표는 사람들의 관심을 끄는 것이 아니다. 소요 시간이나 클릭 수로 성공을 측정하는 대신, 진심으로 도움을 주는 집중하고 있다"라고 밝혔다.

이를 위해 "모델의 안전 교육에 어긋나는 응답은 자동으로 차단되며, 미성년자나 로그아웃된 사용자에 대한 보호가 더 강화된다"라고 전했다.

장기간 대회에서 문제가 발생한다는 점을 인정했다. "우리의 안전장치는 짧은 대화에서 안정적으로 작동한다. 하지만 장시간 상호작용에서는 때로 신뢰성이 떨어질 수 있다는 것을 알게 됐다"라고 설명했다.

이에 따라 "챗GPT가 사용자를 현실에 집중시켜 긴장을 완화하도록 하는 GPT‑5 업데이트를 개발 중"이라고 밝혔다. 그 예로 심야에 장시간 채팅이 진행되면, 챗봇이 수면 부족의 위험을 경고하고 휴식을 취할 것을 권장한다는 것을 들었다.

이처럼 챗GPT는 일정 사용 시간이 지나면, 경고 메시지가 등장할 것으로 예측된다.

청소년 보호를 위해서는 나이 확인과 별도의 필터링 시스템 적용을 예고했다. 이제까지 챗GPT에는 연령 인증 절차가 없었다.

"과거에는 모든 사용자에게 단일 모델을 지정했지만, 사용자가 18세 미만인 경우 보호 기능을 추가하기 시작했다"라고 설명했다.

또, 부모가 자녀의 챗GPT 사용 방식을 자세히 파악하고 조정할 수 있는 '자녀 보호 기능'도 곧 도입할 예정이라고 밝혔다.

구체적인 내용은 공개하지 않았다. 이와 관련, 앞서 청소년 자살 문제로 고소 당한 캐릭터닷AI는 '주간 활동 보고서'를 발송하고 있다. 여기에는 자녀의 채팅 시간과 상호 작용한 캐릭터 등이 표시된다.

이 밖에도 사용자가 자해나 자살에 대한 의도를 보이면, 챗봇이 도움을 요청할 수 있는 전문가를 연결하겠다고 밝혔다. 미국과 유럽에서는 이미 작업을 시작했으며, 다른 국가로 확장할 계획이다. 이런 핫라인을 확대할 뜻도 전했다.

이처럼 신속한 대책 발표는 그동안 챗GPT가 'AI 정신병'이나 망상을 부추긴다는 것이 집중적으로 지적됐기 때문이다. 이 때문에 오픈AI는 'GPT-5'를 출시하며 문제가 됐던 'GPT-4o'를 폐기하려고 했다. 그러나 사용자 반발로 이는 무산됐다.

이날도 오픈AI는 "GPT‑5는 건강에 해로운 정서적 의존을 피하고, 아첨을 줄이며, 비이상적인 모델 반응 빈도를 GPT-4o 대비 25% 이상 감소시키는 등 의미 있는 개선을 보였다"라고 설명했다.

임대준 기자 ydj@aitimes.com