마이크로소프트(MS)도 수학 전용 모델을 내놓았다. 특징은 다른 모델처럼 추론 능력만 사용하는 것이 아니라, 모델이 내부에서 코드를 생성해 LLM의 답을 검증할 수 있는 점이다.

MS는 30일(현지시간) 깃허브를 통해 추론 과정을 파이썬 실행과 상호작용하도록 만든 'r스타2-에이전트(rStar2-Agent)'를 오픈 소스로 공개했다.

추론 기능으로 인해 대부분 대형언어모델(LLM)은 수학 능력이 비약적으로 발전했다. 그러나 사고 사슬(CoT) 구조는 추론 초기 미묘한 오류만 발생해도, 오답 확률이 크게 늘어난다.

따라서 MS는 모델이 오래 생각하는 것만 아니라, 코딩 생성 능력을 활용해 추론 과정을 검증하는 방식을 도입했다.

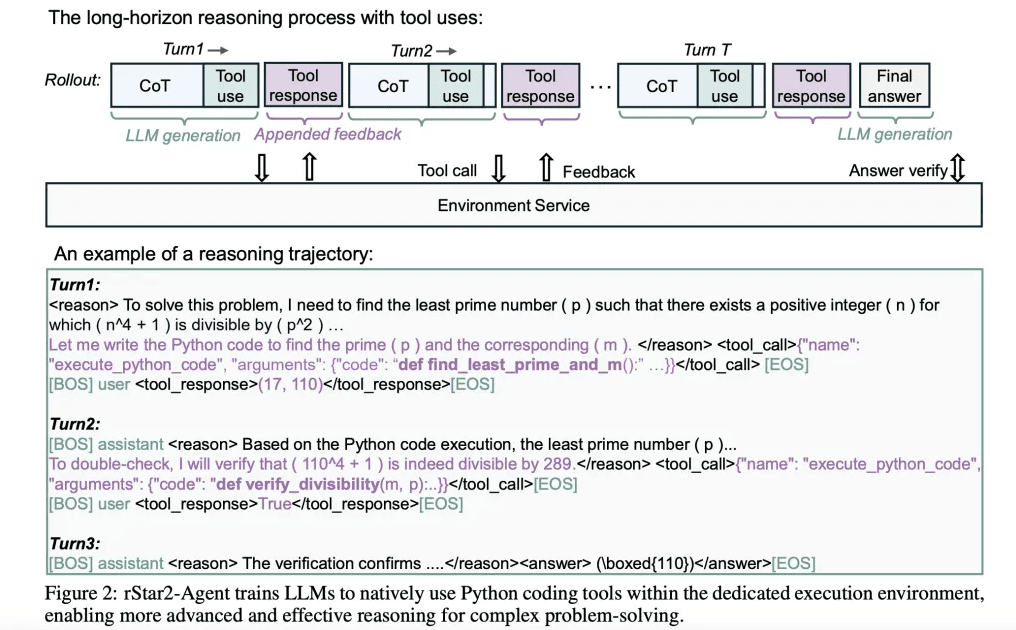

r스타2-에이전트는 14B 매개변수 모델로, 추론 과정 전반에 걸쳐 파이썬 실행 환경과 상호 작용한다. 모델이 복잡한 수학 문제에 풀기 위해 먼저 추론을 생성하고, 가설을 검증하기 위한 파이썬 코드를 작성해 실행 결과를 분석한다. 아 과정을 반복하며 더 정확한 답을 찾아간다는 내용이다. 이는 수학자들이 계산 도구를 활용해 가설을 검증하고 해결 방법을 찾아가는 것과 같은 구조다.

이를 실제로 적용하는 과정에서는 모델이 동시에 수만개의 코드 실행 요청을 생성하는 등 GPU의 병목 현상을 일으킬 수 있다. 따라서 연구진은 두가지 방법으로 이를 해결했다.

먼저, 동시에 4만5000건의 도구 호출을 1초도 안 되는 시간에 처리할 수 있는 분산 코드 실행 시스템을 구축했다. 또 GPU 가용성을 높이기 위해 정적 할당이 아닌, 동적으로 계산 작업을 할당하도록 만들었다.

이를 통해 MS는 64개의 AMD 'MI300X' GPU를 사용해 모델 학습을 1주일 만에 완료했다고 밝혔다. 리소스를 효율적으로 배분하면 추론 기능 개발에도 엄청난 비용과 시간이 들어가지 않는다는 것이다.

정답을 찾아내는 알고리즘의 핵심은 정답을 찾아가는 과정에서 그룹 상대 정책 최적화(GRPO-RoC)를 적용한 것이다. 즉, 여러 답안을 만들어 이를 비교하고 가장 뛰어난 것을 골라내는 방식이다. 이 경우에는 추론 과정에 오류가 있거나 도구 사용이 비효율적인 경우라도 가장 정답에 가까운 답을 얻어낼 수 있도록 한다.

훈련 과정도 3단계로 구분했다.

처음에는 응답을 8000개 토큰으로 제한, 모델의 간결한 추론을 유도한다. 이 과정만으로도 벤치마크 성능은 0%에서 70% 이상으로 크게 향상된다고 설명했다.

이어 다음 단계에서는 토큰 한도를 1만2000개로 확장, 더 복잡한 추론을 가능하게 했다. 마지막으로는 가장 어려운 사례에 추론을 집중하는 방식이다.

이처럼 간결한 단계부터 난이도가 높아지는 방식으로, 학습 효율을 극대화한다는 설명이다.

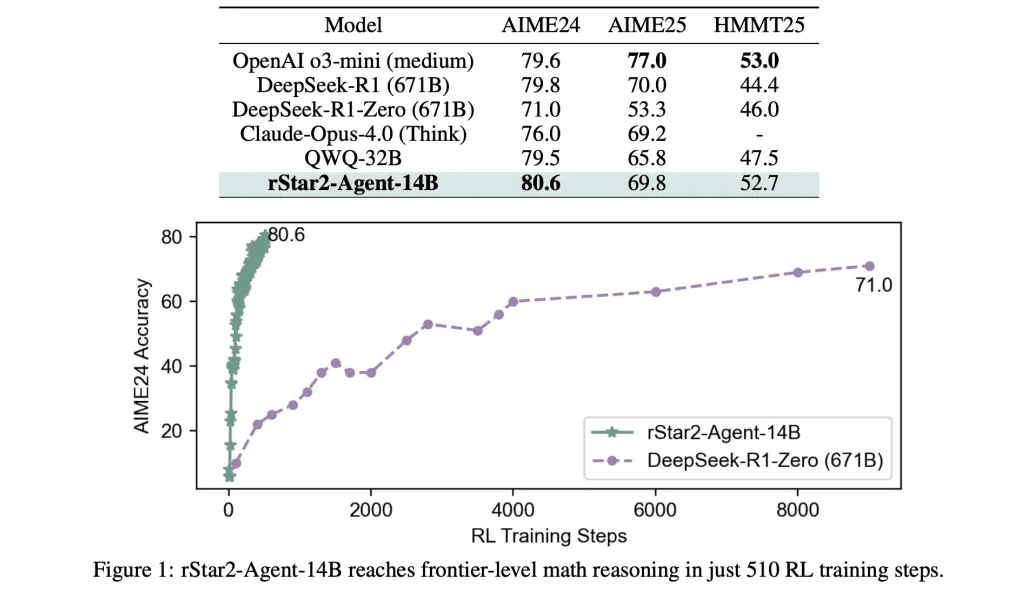

벤치마크에서는 뛰어난 성능을 발휘했다. 'AIME24'에서 80.6%, 'AIME25'에서 69.8%의 정확도를 달성했다. 이는 671B 매개변수를 가진 '딥시크-R1'을 포함한 훨씬 더 큰 모델을 능가한다.

특히 이 모델은 복잡한 문제를 작은 단계로 나누는 추론 추적(reasoning traces) 회수를 평균 1만개 정도로 크게 줄였다는 점이다. 이는 다른 모델의 1만7000개보다 훨씬 짧다.

물론, 수학 문제만을 학습했지만, 과학적 추론 벤치마크에서도 뛰어난 성능을 보여주는 전이 학습 효과를 보였다고 덧붙였다.

이처럼 이번에 개발된 모델은 성능 향상을 위해 데이터와 인프라를 늘리는 전략 말고도 정교한 학습 과정을 통해 프론티어급 성능을 가진 소형 모델을 만들 수 있다는 것을 보여줬다는 평이다.

즉, 단순 연산 능력보다 도구 통합과 효율성 결합이 중요하다는 것을 보여준 사례로 꼽혔다.

임대준 기자 ydj@aitimes.com