생물은 태어나면서부터 환경을 인식하고 학습하는데, 보이는 사물과 환경이 더 많아지고 넓어지며 방대한 학습 정보에 노출되고, 그렇게 학습 수준을 높여 나간다. 은닉층의 구조가 단순한 단층 신경망인 퍼셉트론은 소수 정보로도 충분히 학습이 가능했고, 그래서 소수 이미지에 대한 인식만 가능했다.

하지만, 다층 4신경망으로 발전해 나가며 은닉층은 비교할 수 없이 깊어지고 복잡해지며 수많은 학습 정보가 필요하게 됐다. 특히 이미지 인식을 위한 AI의 개발에는 많은 디지털 이미지 데이터가 필요했는데, 과거에 이는 쉽게 구하기 힘든 귀한 자원이었다. 이런 상황에서 AI 연구계는 오랫동안 데이터가 부족한 상황에서도 효과적인 기능을 발휘할 수 있는 알고리즘 개발에 더 많은 시간을 쏟아야 했다.

그러나 1990년대 중반부터 디지털카메라가 일반인들에게 보급되기 시작했고, 2000년에는 휴대폰에 최초로 카메라가 장착됐으며, 2007년 애플이 스마트폰을 출시하면서 디지털 이미지는 더 이상 귀한 자원이 아니게 되었다. 이와 함께 인터넷의 발전은 디지털 이미지를 공유하고 전송하는 새로운 방법을 제공하며, 디지털 이미지 데이터 희소성의 시대가 저물게 됐다.

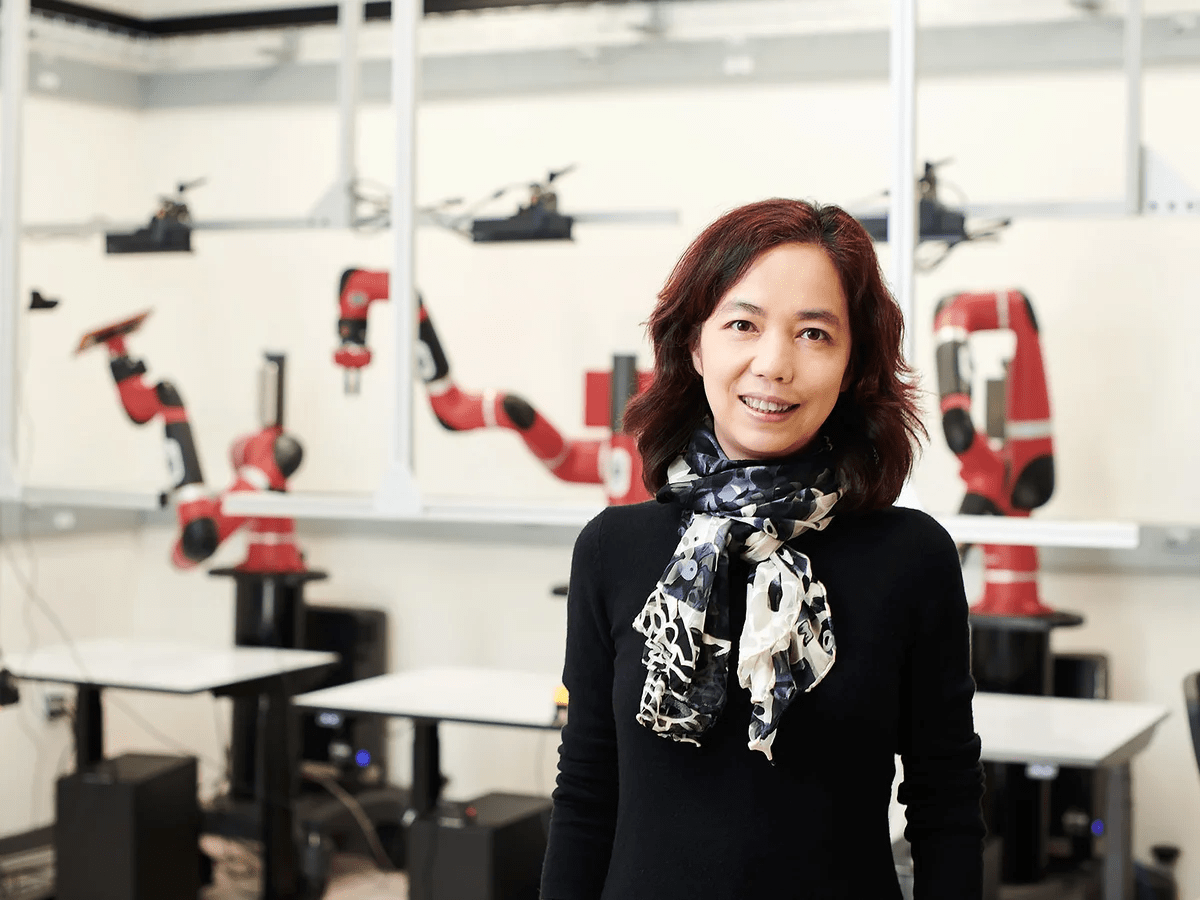

이에 따라 복잡한 알고리즘 개발에 더 큰 노력을 쏟아부었던 AI 연구계도 풍부한 데이터를 이용해 좀 더 단순한 알고리즘을 구현할 수 있는 시대로 접어들었다. 이런 변화에 결정적 기여를 한 사람이 스탠포드대학교의 페이페이 리 교수이며, 또 그녀가 2009년에 구축한 이미지 데이터베이스 ‘이미지넷(ImageNet)’이었다.

페이페이 리(Fei-Fei Li, 李飞飞) 교수는 북경에서 태어나 16살에 가족과 함께 미국으로 건너갔다. 프린스턴대학교 시절, 주말에는 부모님의 세탁소에서 일하며 물리학을 전공했고, 칼텍에서 전기공학 전공으로 석사 과정과 박사 과정을 마쳤다. 2005년부터 2009년까지 일리노이대학교와 프린스턴대에서 컴퓨터학과 조교수 생활을 하다가, 2009년에 스탠포드대 컴퓨터 과학과로 옮겨와서 현재까지 근무하고 있다.

안식년을 갖게 된 2017년에는 구글 클라우드에서 부사장 겸 AI 및 머신러닝 부분 수석 과학자로 근무하기도 했다. 당시 구글은 미 국방부와 계약한 메이븐 프로젝트(Maven Project)로 직원들과 마찰을 빚는 사태가 벌어졌다. 드론으로 사물을 인식하는 프로젝트로 밝혀지며, AI 기술이 무기화에 사용될 것을 우려한 직원들의 반발이 있었기 때문이다.

자신의 업무가 아니었음에도 프로젝트에 대해 영업팀에 조언한 그녀의 메일이 공개되고 논란이 되면서, 그녀는 회사 경영진과 학계의 동료들 사이에서 난처한 입장에 됐고, 중국 온라인 게시판에서 살해 위협을 받기도 했다. 이 사건으로 프로젝트의 개발자들과 다수의 관리자가 구글을 떠날 때, 페이페이 리도 구글을 사직하고 스탠포드대로 돌아갔다.

구글에서의 논란에도 불구하고, 리의 다양한 연구 중 AI에 대한 가장 큰 기여는 그녀가 구축한 이미지넷과 동료들과 함께 주최한 이미지 인식 대회였다. 휴대폰에 본격적으로 카메라가 장착되던 2003년, 많은 AI 연구자는 여전히 학습 모델과 알고리즘 개발에 중점을 두고 있었다.

칼텍 대학원생으로 AI를 연구하던 리는 AI가 실용적이고 유용하기 위해서는 실제 세계를 반영하는 좋은 훈련 데이터가 있어야 한다고 생각했다. 그래서 AI의 알고리즘 훈련에 사용할 수 있는 데이터베이스를 구축하고, 확장해 나가기로 결심하고, ‘칼텍-101(CalTech-101)’이라는 이미지 데이터베이스를 내놓았다.

당시 칼텍-101은 101개의 항목으로 분류된 9146장의 이미지가 있었는데, 2007년에는 칼텍-101을 확장해 256개의 항목으로 분류된 3만607개의 이미지를 가진 ‘칼텍-256’을 내놓았다. 좀 더 실용적인 연구를 해보라는 동료들의 조언에도 불구하고, 그녀는 더 방대한 데이터로 새로워진 데이터베이스 ‘이미지넷(ImageNet)’을 2007년에 구축하고 AI 연구자들에게 훈련과 테스트에 필요한 대규모 이미지를 제공하려는 노력을 이어갔다. 리가 스탠포드대 교수가 된 2009년에 공개한 이미지넷에는 5,247개의 항목에 320만개의 이미지 데이터가 포함됐는데, 2021년 3월 마지막 업데이트되며 2만1841개의 항목에 1420만개의 이미지가 제공되고 있다.

리의 이미지넷은 단순히 많은 수의 이미지 데이터만을 제공하는 것은 아니다. 이미 인터넷에는 흘러넘칠 만큼 많은 이미지가 존재하고 구하기도 어렵지 않다. 이런 데이터가 AI의 학습, 특히 지도 학습을 통해 신경망의 훈련과 학습에 활용되기 위해서는 이미지가 항목별로 엄격히 분류돼 이미지마다 정확한 레이블이 있어야 한다.

이미지넷의 이미지는 영단어 어휘 데이터베이스인 워드넷에 따라 레이블이 지정됐으며, ‘synset’이라고 하는 유의어 그룹 즉, 항목으로 정렬돼 신경망 훈련과 학습에 활용하기 좋게 레이블링 되고 분류돼 있다. 이미지가 많지 않았던 초기에는, 리와 동료들이 이미지 하나하나를 검토하며 어떤 항목에 해당하는지 확인하고 레이블을 붙여줄 수 있었지만, 이미지가 수십만장으로 늘어나게 되면서 그렇게 할 수는 없었다. 그래서 리는 아마존의 메커니컬 터크 서비스를 활용했다.

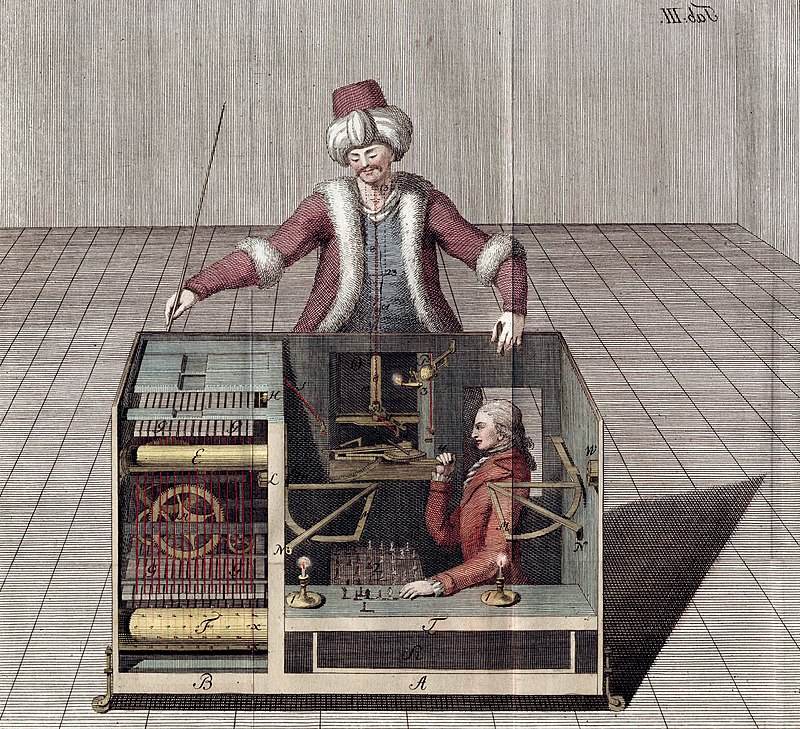

원래 ‘메커니컬 터크(Mechanical Turk)’ 또는 ‘더 터크(The Turk)’라고 불리는 장치는 1770년 헝가리 발명가 볼프강 폰 켐펠렌이 만들었다. 그는 앞서 AI 비서의 기술에서도 등장한 음성학 이론의 선구자였다. 더 터크는 그가 오스트리아 합스부르크 왕국의 유일했던 여성 황제 마리아 테레사에게 선물한 자동 체스 기계였는데, 1854년 화재로 소실될 때까지 여러 사람이 소유하기도 했고 유럽과 미주를 순회하며 나폴레옹이나 벤자민 프랭클린 같은 유명인들과 체스 경기를 하기도 했다.

큰 테이블 위에 오스만 투르크인의 복장을 한 사람 크기의 인형과 체스판이 있었는데, 인형의 손이 움직이며 체스 말을 이동해 사람과 체스 시합을 했다. 시합전에 켐펠렌은 이 장치가 기계임을 알려주기 위해 테이블 하단의 문을 열어 보여주었는데, 시계와 같이 톱니 기어 등의 부속이 많고 복잡하게 구성돼 사람이 숨을 공간이 없음을 확인해 줬다. AI 역사 관점에서 보면 최초의 자동 체스 게임기인 셈이다. 상당 기간 메커니컬 터크의 작동 방식에 대해 많은 책과 기사가 작성됐지만, 대부분 부정확했으며 기계의 정확한 비밀이 파악되지는 않았다.

당연히 메커니컬 터크는 AI나 자동 로봇이 아니었고, 복잡한 테이블 속에 진짜 인간 체스 고수가 교묘하게 숨어 자석을 이용해 말을 움직이고 여러 레버 장치로 인형의 동작을 만들어냈다고 알려져 있다. 당시 사람들도 작동 원리를 정확히 파악하지는 못했지만, 그래도 이 장치가 마술과 혼합된 정교한 속임수라고 생각했을 것이다.

하지만 다른 한편으로 메커니컬 터크는 당시에 기계가 어느 정도의 일을 할 수 있을지, 기계가 인간의 어떤 능력을 대체할 수 있을지 궁금해하는 계기를 만들어 줬다. 산업혁명을 이끌어낸 기계화나 계산하는 기계인 차분기관과 해석 기관을 고안한 찰스 배비지도 이 기계에서 영향을 받았다고 한다. 또 초기 AI 연구의 하나인 클로드 섀넌의 체스 프로그램부터 IBM의 딥블루에 이르기까지 AI 개발 역사에 체스는 꾸준히 중요한 자리를 차지하고 있었다는 점에서, 250년 전 자동 체스 기계의 흔적이 여전히 남아 있는 것인지도 모른다.

아마존은 2005년 ‘아마존 메커니컬 터크(Amazon Mechanical Turk, MTurk)’ 서비스를 선보였다. 250여년전의 기계에서 영감을 받고 이름을 따왔듯, 이 온라인 서비스는 컴퓨터로 수행하기 어려운 문제나 작업을 엠터크(MTurk)라 불리는 컴퓨터 인터페이스 뒤에 숨겨진 수많은 원격 인력의 노력이나 지능을 이용해서 해결해 주는 서비스였다.

대표적으로 이미지나 동영상의 특정 콘텐츠 식별, 색깔 구분, 정보 수집, 데이터 유효성 검사 또는 처리, 설문조사 등 인간이 컴퓨터보다 더 효과적으로 할 수 있는 일에 활용되는데, 기업이나 요청자는 분산된 글로벌 인력의 집단지능이나 통찰력을 활용할 수 있게 된다. 엠터크는 작업당 1센트부터 수센트의 임금을 받고 작업을 수행하게 되는데, 특히 수많은 엠터크들이 동시에 작업하며 시간이 많이 걸리고 지루한 반복 작업을 쉽게 완수해 낼 수 있다.

10억장의 후보 이미지로부터 이미지넷의 1400만장에 달하는 이미지를 골라내고 항목별로 분류하는 고된 작업도 167개국의 5만여명의 엠터크들에 의해 이뤄졌다. 엠터크들은 분당 평균 50개의 이미지를 식별했다고 하는데, 이는 아마존 메커니컬 터크 사상 최대의 학술 사용자였다고 한다.

이렇게 AI 학습을 위한 데이터가 모이고 정리되자, 리와 그의 동료들은 다시 AI의 알고리즘으로 시야를 확대했다. 자신들이 구축한 데이터베이스를 이용해서 AI 연구자들이 개발한 이미지 인식 프로그램을 세상에 소개할 공식 기회를 제공하려 했다. 그것이 2010년부터 개최한 대규모 시각 인식 대회인 ‘ILSVRC(ImageNet Large Scale Visual Recognition Challenge)’였는데, 이 대회를 통해서 AI는 또 다른 극적인 변화와 발전의 계기를 마련하게 됐다.

문병성 싸이텍 이사 moonux@gmail.com

- [AI의 역사] 76 새로운 컴퓨터 군주를 환영합니다! – 퀴즈 쇼 제퍼디와 왓슨

- [AI의 역사] 75 그림을 그리려다 생각을 해버린 GPU와 하드웨어 - 딥러닝의 발전 배경 (하)

- [AI의 역사] 74 알고리즘의 발전, 인터넷과 모바일의 데이터 – 딥러닝의 발전 배경(상)

- [AI의 역사] 78 세상의 모든 이미지를 인식하고 분류한다 – ILSVRC와 알렉스넷

- [AI의 역사] 79 가르침 없이 스스로 고양이를 찾아낸 인공 신경망 – 브레인 프로젝트의 시작과 제프 딘

- [AI의 역사] 80 검색엔진 회사가 AI 회사가 되기까지 – 앤드류 응과 브레인 프로젝트의 발전