딥시크가 새로운 대형언어모델(LLM) 업데이트를 공개하며 다시 주목받고 있다.

딥시크는 22일(현지시간) 지난 8월 출시한 'V3.1' 모델을 업그레이드한 ‘딥시크 V3.1-터미너스(DeepSeek V3.1-Terminus)’를 오픈 소스로 공개했다.

이번 업데이트는 코드 생성과 검색 기반 평가 등 ‘에이전틱 도구(agentic tool)’ 활용 과제에서 성능을 강화했으며, 기존 V3.1에서 보고된 영어 문장 내 중국어 단어 삽입 문제도 개선됐다. 현재 허깅페이스, 딥시크 iOS·안드로이드 앱, 자체 API를 통해 즉시 사용 가능하다.

딥시크 V3는 2024년 12월 처음 공개됐으나, 2025년 1월 추론 모델 'R1'의 등장으로 다소 주목을 덜 받았다.

R1은 수학·논리·복잡한 문제 해결에 강점을 보이지만 속도가 느리고 비용이 높아, 상대적으로 V3 계열이 빠른 처리 속도와 효율성을 바탕으로 일반적인 비즈니스 활용에 적합하다는 평가를 받았다. 글쓰기, 요약, 고객 응대, 기초 코딩 등 범용 작업에서 충분히 강력하면서도 저비용·고속 처리가 가능하다.

지난 8월 공개된 V3.1은 매개변수 6850억개 규모로, 미국의 폐쇄형 모델과 견줄 만한 성능을 보여 화제가 됐다.

이번 터미너스 업데이트는 언어 일관성과 도구 활용 능력 강화라는 두가지 개선에 중점을 뒀다. 딥시크는 이전 버전에서 간헐적으로 발생하던 중-영 혼용 문제와 비정상적 문자 출력을 상당 부분 해결했으며, 코드 생성에 특화된 ‘코드 에이전트(Code Agent)’와 검색·정보 종합에 특화된 ‘서치 에이전트(Search Agent)’ 성능도 크게 향상했다고 밝혔다.

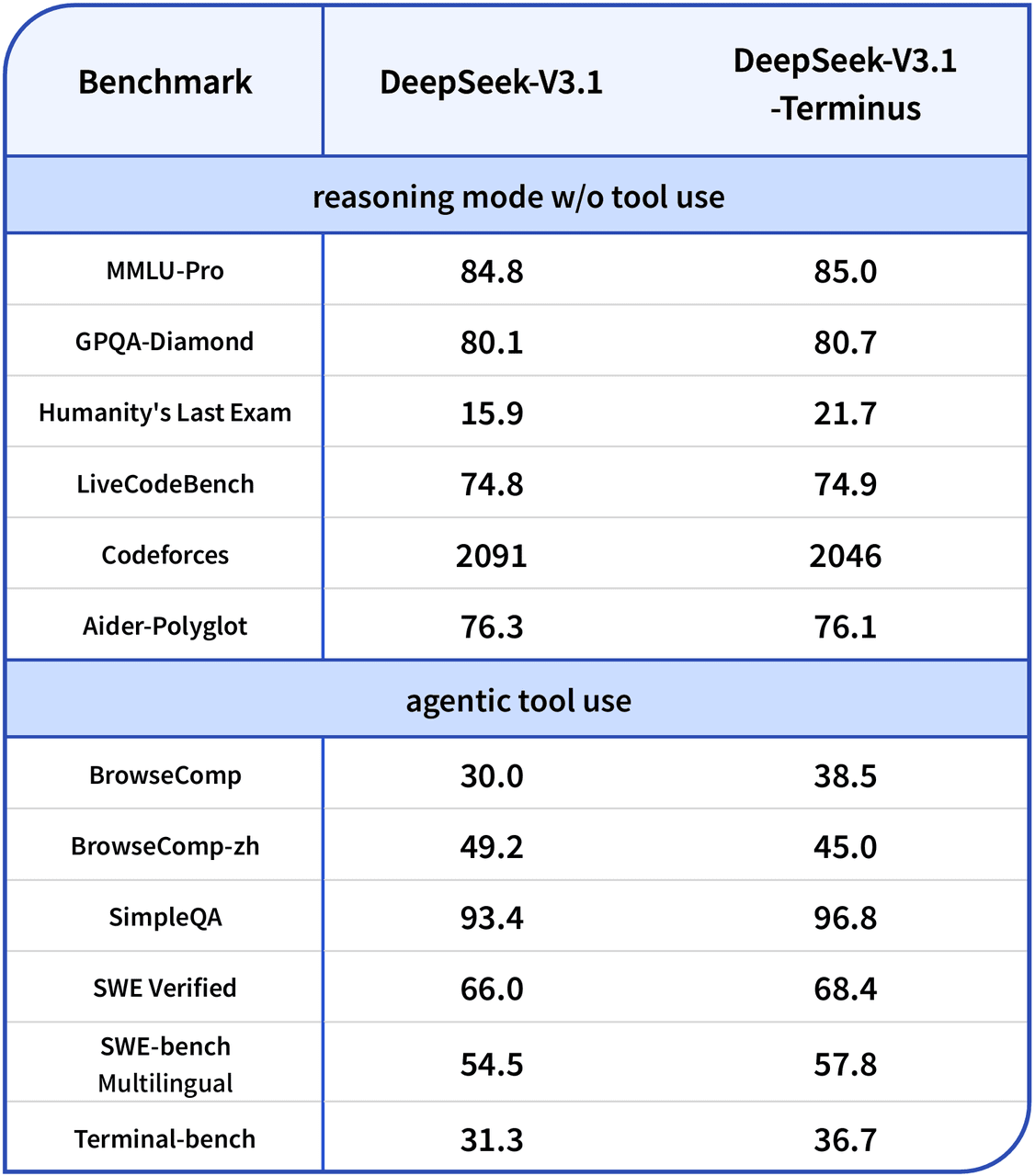

벤치마크에서도 개선된 성능이 확인됐다.

단순 질의응답(SimpleQA), 복합 탐색(BrowseComp), 코딩(SWE 베리파이드), 다국어 SWE-벤치, 터미널-벤치 등 주요 평가에서 모두 이전 버전 대비 뚜렷한 향상을 기록했다. 다만, 순수 추론(Reasoning) 능력에서는 소폭 상승에 그쳤고, 코딩 역량을 측정하는 '코드포스(Codeforces)' 점수는 다소 하락한 것으로 나타났다.

딥시크 V3.1-터미너스는 일반 대화형 ‘딥시크-챗(deepseek-chat)’ 모드와 심층 추론형 ‘딥시크-리즈너(deepseek-reasoner)’ 모드를 지원한다. 두 모드 모두 최대 12만8000토큰의 컨텍스트 창을 제공하지만, 오픈AI GPT-5(25만6000토큰), 구글 제미나이 2.5 프로(100만 토큰), 그록 4 패스트(200만 토큰)와 비교하면 다소 짧은 편이다. 출력 토큰 한도는 대화형 최대 8000토큰, 추론형 최대 6만4000토큰이다.

이용 요금은 토큰 사용량에 따라 차등 적용되며, 캐시 히트 여부에 따라 입력 비용이 달라진다. 100만 토큰 기준 캐시 히트 시 0.07달러, 캐시 미스 시 0.56달러가 부과되며, 출력 100만 토큰은 1.68달러로 책정됐다.

박찬 기자 cpark@aitimes.com