삼성전자의 연구 조직 SAIT가 700만개의 매개변수만으로 대형언어모델(LLM)의 성능을 능가하는 새로운 모델을 공개했다.

삼성전자 SAIT 캐나다 몬트리올 연구소는 8일(현지시간) 온라인 아카이브에 발표한 논문 ‘적을수록 강하다: 작은 신경망을 통한 재귀적 추론(Less is More: Recursive Reasoning with Tiny Networks)’를 통해 700만개의 매개변수의 초소형 추론 모델 ‘TRM(Tiny Recursion Model)’을 공개했다.

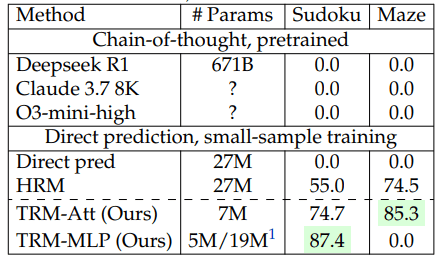

TRM은 오픈AI의 'o3-미니', 구글의 '제미나이 2.5 프로', '딥시크-R1' 등 수천억~수조개의 매개변수를 가진 최신 모델을 일부 논리 추론 과제에서 앞질렀다.

졸리쾨르-마르티노 연구원은 “복잡한 대형 모델에 의존해야만 어려운 문제를 해결할 수 있다는 생각은 함정”이라며 “중요한 것은 규모가 아니라, 사고 과정 그 자체”라고 강조했다. “작은 모델도 스스로 사고를 반복하고 답을 갱신하면, 큰 모델 못지않은 성과를 낼 수 있다”라고 덧붙였다.

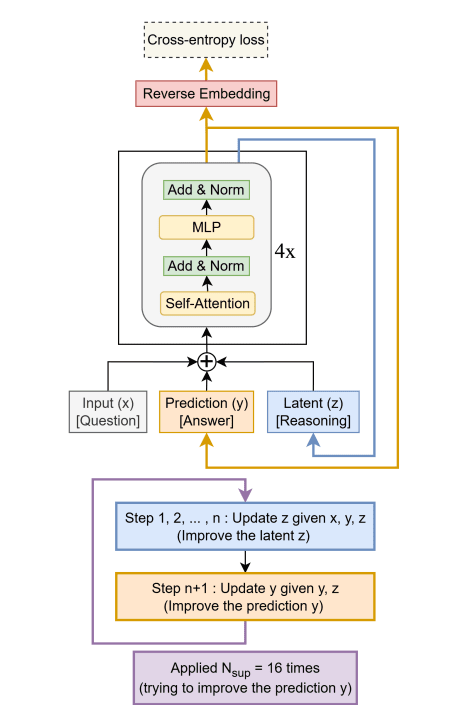

TRM은 불과 2개의 층(layer)으로 구성된 단일 신경망으로, 스스로 재귀적 추론(recursive reasoning)을 수행해 답을 계속 갱신하는 구조다. 입력값을 토대로 초기 답안을 생성한 뒤, 이를 반복적으로 수정하며 최종적으로 가장 일관된 답을 찾아낸다.

이런 방식은 복잡한 계층 구조나 수학적 근사식을 사용하는 기존의 ‘계층적 추론 모델(HRM)’을 단순화한 것으로, “작을수록 더 강력하다”라는 발상을 실증한 사례로 평가된다.

TRM은 퍼즐이나 미로(Maze) 같은 구조화된 격자 문제 추론(grid-based reasoning)에 특화돼 있으며, 실제로 도형의 패턴을 예측하는 'ARC-AGI-1'에서 45%, 'ARC-AGI-2'에서 8%의 테스트 정확도를 기록했다. 이는 수천억 개의 매개변수를 지닌 주요 LLM들의 성능을 능가하거나 근접한 수치다.

또, '스도쿠-익스트림(Sudoku-Extreme)'에서는 87.4%, '메이즈-하드(Maze-Hard)'에서는 85%의 정확도를 달성해, 기존의 계층적 추론 모델(HRM)의 성능(55%)을 크게 상회했다.

TRM의 핵심은 ‘재귀(Recursion)’가 깊이(depth)와 규모(size)를 대체할 수 있다는 점이다. 모델은 자신의 출력을 반복 검토하며 점차 더 나은 예측을 만들어 낸다.

이는 LLM이 ‘사고 사슬(CoT)’를 활용하는 방식과 비슷하지만, 훨씬 단순하고 효율적인 구조를 가진다.

또 고정 소수점(fixed point) 계산이나 복잡한 이중 네트워크 구조를 제거해, 메모리와 전력 소모를 크게 줄였다. 모델이 언제 추론을 멈출지 결정하는 경량 중단 메커니즘을 탑재해, 연산 낭비를 방지하면서도 정확도를 유지했다.

이 연구는 ‘거대화’ 위주로 진행되는 첨단 AI 연구 패러다임에 대한 도전으로 평가된다. TRM은 단일 엔비디아 'L40S' GPU만으로도 훈련이 가능하며, 대규모 GPU 클러스터가 필요한 초거대 모델과 달리 누구나 저비용으로 재현할 수 있다.

연구진은 TRM의 전체 코드를 깃허브에 공개해, 기업과 연구자가 자유롭게 수정·상용화할 수 있도록 했다.

전문가들은 이를 두고 “1만배 작지만, 더 똑똑한 모델”이라며, AI 연구의 새로운 방향을 제시했다고 평했다.

그러나 일부 연구자들은 TRM이 언어나 이미지 이해 등 비구조적 문제에는 한계가 있다며, “범용 AI라기보다 특정 퍼즐형 문제 해결에 특화됐다”라고 지적했다.

그럼에도 TRM은 “AI 발전은 더 크고 복잡한 모델이 아니라, 더 깊고 반복적인 사고 방식에서 온다”라는 가능성을 보여줬다는 평이다.

졸리쾨르-마르티노 연구원은 앞으로 TRM을 재귀 생성(recursive generative) 모델로 확장, 여러 해답을 동시 탐색하거나 추론 단계를 자동 조절하는 연구에 집중할 것을 예고했다.

박찬 기자 cpark@aitimes.com