메타의 슈퍼인텔리전스 랩스(MSL)가 인간 시연이나 보상 함수 없이도 인공지능(AI) 에이전트가 실제 행동의 결과를 기반으로 스스로 학습하고 성능을 향상할 수 있는 새로운 훈련 방식을 선보였다.

MSL은 16일(현지시간) 강화 학습(RL)의 보상 없이도 에이전트가 스스로 학습하고 기존 모방 학습을 능가할 수 있는 새로운 훈련 방식 ‘초기 경험(Early Experience)’을 온라인 아카이브를 통해 공개했다.

이 방법은 많은 인간 시연 데이터나 RL에 의존하지 않고, 에이전트가 스스로 행동한 결과를 바탕으로 학습하고 정책을 개선하도록 만들어졌다.

연구진은 에이전트의 목표는 자신의 경험을 통해 학습하고 개선해 궁극적으로 복잡한 실제 작업에서 인간을 능가하는 것이지만, 경험 데이터에서 RL을 통해 에이전트를 훈련하는 것은 검증 가능한 보상이 부족하거나 비효율적인 장기 롤아웃(예: 다중 턴 도구 사용)이 필요한 많은 환경에서 여전히 어렵다고 지적했다.

이 때문에 대부분의 에이전트는 전문가 데이터에 대한 지도 미세 조정(SFT)에 의존하는데, 이는 확장이 어렵고 일반화가 잘되지 않는다는 것이다. 초기 경험은 이런 문제를 해결하려는 것이다.

핵심 아이디어는 간단하다. 에이전트가 전문가 상태(expert states)에서 출발해 스스로 행동을 선택하고, 그로 인해 발생한 미래 상태(future states)를 수집해 학습 신호로 활용하는 방식이다.

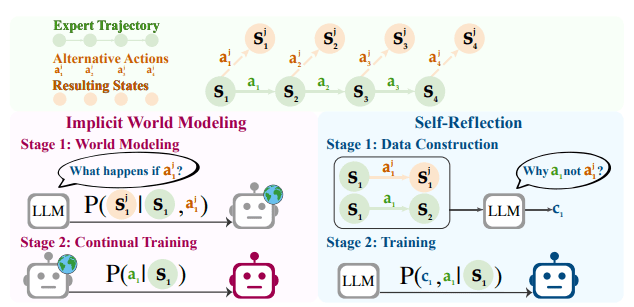

MSL은 이를 두가지 구체적인 전략으로 구현했다. 먼저 IWM(Implicit World Modeling)은 에이전트가 현재 상태(state)와 선택한 행동(action)을 바탕으로 다음 관찰(next observation)을 예측하는 방법이다. 이를 통해 에이전트 내부의 환경 모델이 강화되고, 정책과 실제 행동 간의 편차(off-policy drift)를 줄일 수 있다.

또 SR(Self-Reflection)은 동일한 상태에서 전문가 행동과 대체 행동을 비교하며, 전문가 행동이 더 나은 이유를 결과에 따라 학습하는 방식이다. 이를 통해 에이전트는 자신의 판단을 돌아보고 정책을 개선할 수 있다.

두 전략 모두 기존 모방 학습과 동일한 학습 예산과 디코딩 환경을 사용하지만, 데이터 출처가 외부가 아닌 에이전트가 직접 생성한 경험이라는 점이 특징이다.

초기 경험은 세 단계로 구성된다. 첫 단계는 데이터 수집으로, 전문가가 수행한 행동 중 일부 중요한 상태를 골라내고 에이전트가 스스로 다른 행동을 해본 뒤 결과를 기록한다.

다음 단계는 IWM 학습으로, 수집한 상태·행동·다음 상태 데이터를 이용해 에이전트가 다음 상태를 예측하도록 학습한다. 마지막으로 SR 학습 단계에서는 동일한 상태에서 전문가 행동과 에이전트 행동을 비교하고, 전문가 행동이 왜 더 좋은지 이유를 찾아 정책을 개선한다.

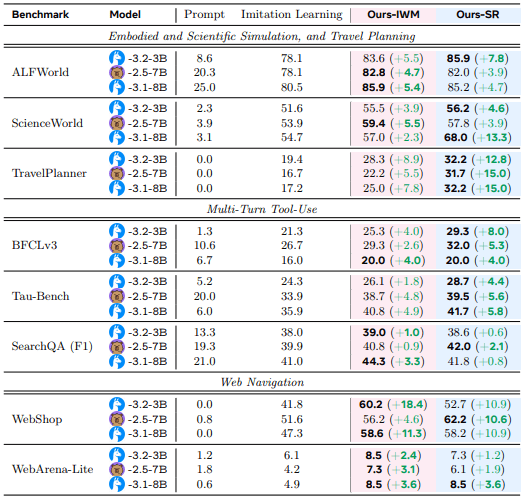

MSL은 웹 탐색, 장기 계획 설정, 과학·임베디드 과제, 다중 API 워크플로우 등 8개 언어 에이전트 환경에서 초기 경험을 평가했다. 그 결과, 모방 학습 대비 성공률 +9.6, 도메인 외 일반화(OOD) +9.4를 기록하며, 안정적인 성능 향상을 기록했다.

또 초기 경험으로 초기화한 RL에서는 모방 학습으로 시작한 RL에 비해 성공률이 최대 6.4 향상된 결과를 보였다.

특히, 전문가 시연 데이터를 적게 사용하면서도 동등하거나 더 나은 성능을 달성하는 데모 효율성이 눈에 띈다. 예를 들어, '웹숍(WebShop)' 환경에서는 전체 시연 데이터 8분의 1만 사용해도 모방 학습 전체 학습치보다 우수한 성과를 보였고, 'ALF월드'에서는 절반만으로 동등한 성능을 달성했다.

이처럼 초기 경험은 단순히 보상 없는 RL이 아니라, 에이전트가 직접 경험한 결과를 레이블로 활용하는 감독 학습(supervised learning) 방식이다.

또 보상을 확인할 수 있는 환경에서는 이후 RL을 추가하면, 초기화 단계에서 모방 학습보다 뛰어나 더 빠르고 높은 성능 향상을 얻을 수 있다.

연구진은 "이번 결과는 초기 경험이 후속 RL의 강력한 기반을 제공할 수 있다는 것을 보여주며, 모방 학습과 완전한 경험 기반 에이전트 간의 실질적인 연결고리가 될 것"이라고 강조했다.

박찬 기자 cpark@aitimes.com