# 시각장애인 A씨는 자신의 페이스북 계정에 들어가 뉴스피드에서 최근 업데이트된 친구들의 활동과 사진을 둘러본다. 예전에는 친구 B씨가 야외로 놀러나갔다는 정도밖에는 알 수 없었지만 이제는 다르다. 페이스북에 올린 사진에서 B씨가 연인과 함께 피사의 사탑 앞에서 셀카를 찍었다는 사실까지도 눈앞에 그리듯 생생하게 알 수 있게 됐다.

페이스북이 시각장애인을 위해 이미지를 설명하는 인공지능(AI) 기반의 ‘자동 대체 텍스트(Automatic Alternative Text, AAT)’ 기능을 개선한 새로운 버전을 공개했다고 20일(현지시간) IT 전문매체 엔가젯(Engadget) 등 외신이 전했다.

페이스북은 지난 2016년에 자동 대체 텍스트(AAT) 모델을 처음 선보였다. 대체 텍스트는 시각장애인의 웹 접근성을 높이는 방법 가운데 하나로 쓰이고 있다. 대체 텍스트란 텍스트가 아닌 이미지 등의 콘텐츠를 시각장애인이 좀더 잘 이해할 수 있도록 설명해주는 글이나 문구를 말한다.

페이스북의 AAT 기능은 컴퓨터비전 기술을 사용해 이미지의 설명을 자동 생성한다. 이번에 공개한 새로운 모델은 안정적으로 사진을 감지‧식별하는 성능이 기존 모델보다 10배 이상 개선됐다. 즉 기존 버전이 사진 속에서 100개 정도의 개념을 인식했다면 새로운 버전은 1200개가 넘는 개념을 식별해 더욱 상세한 사진 설명이 가능해졌다는 의미다.

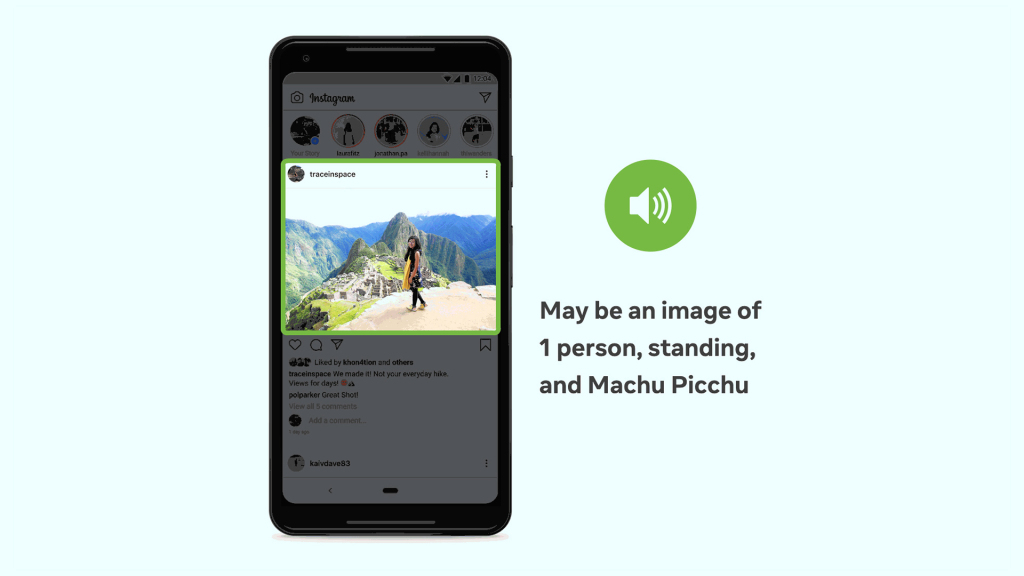

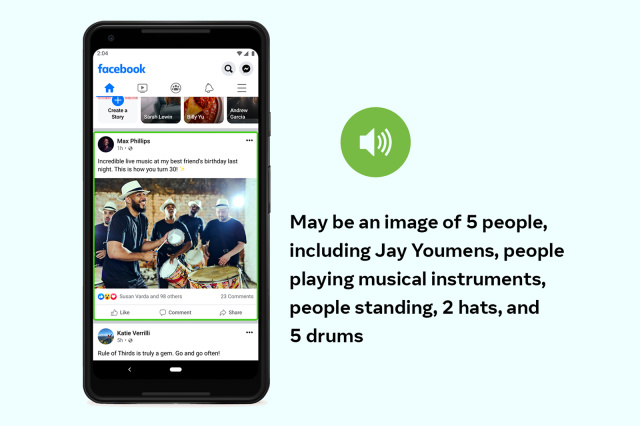

이전에는 사진 내용에 대한 간단한 요약 정도만 가능했으나, 이번 AAT 모델은 사진 속에서 사람의 위치도 인식할 수 있다. 즉 대상의 위치와 크기, 특징에 대한 상세한 설명이 가능하다. 또 사진 속의 활동과 역사적 건축물‧랜드마크, 동물의 종류 등도 인식한다. AAT 모델의 대체 텍스트 설명은 45개 언어로 제공된다.

페이스북의 기존 모델의 경우 사람이 라벨링 작업하고 점검한 데이터를 사용했다. 이는 정확성을 높이는 방법이기는 하나, 데이터 라벨링에 소요되는 시간과 노력이 너무 많이 든다는 단점이 있어 100개 정도만 안정적으로 인식할 수 있었다.

이에 페이스북은 범위 확장과 훈련시간 단축을 위해 캡션‧해시태그가 있는 인스타그램 사진 등 공개 이미지 데이터 수십억 개를 기반으로 새로운 모델을 훈련시켰다. 또 AI가 성별‧피부색‧문화적 맥락 등을 이해하도록 했다. 예를 들어 하얀 웨딩드레스가 아닌 전통 의복을 입은 사진도 어느 정도 결혼식 사진으로 인식할 수 있게 됐다.

그러나 이번 업그레이드 버전도 사진을 완벽하게 설명해내지는 못한다. 페이스북 측은 새로운 AAT 기능이 여전히 불완전하다는 점을 인정했다. AAT 사용 시에 모든 사진 설명의 시작에 ‘May be(아마‧어쩌면)’ 등과 같은 표현을 사용해 오류 가능성을 열어두거나 확실하게 인식할 수 없는 개념을 배제하는 등 더 보완해나갈 점도 있다. 시각장애인 사용자에게 사진 내용에 관한 가능한 한 많은 정보를 제공하되 올바른 정보만을 제공하겠다는 게 페이스북 측의 설명이다.

한편 페이스북 외에 마이크로소프트(MS)와 구글 등 다른 IT 대기업들도 시각장애인을 위한 AI 기반 서비스를 속속 선보이고 있다. 지난해 10월 MS는 자동으로 사진 캡션을 생성할 수 있는 고성능 이미지 캡션 처리 AI 시스템을 개발한 바 있다. 시각장애인 전용 무료 앱 ‘시잉 AI(Seeing AI)’에 추가해 일부 테스트에서는 오히려 사람보다 정확하게 사진을 묘사할 만큼 기존 모델보다 성능을 개선했다는 평가다.

AI타임스 윤영주 기자 yyj0511@aitimes.com