AI 속도를 획기적으로 높이기 위한 연구 개발이 더욱 빨라지고 있다. 수퍼컴퓨터를 통한 하드웨어 방식 뿐만 아니라 CPU를 활용한 소프트웨어 방식까지 다양한 형태로 경쟁이 치열해지고 있다.

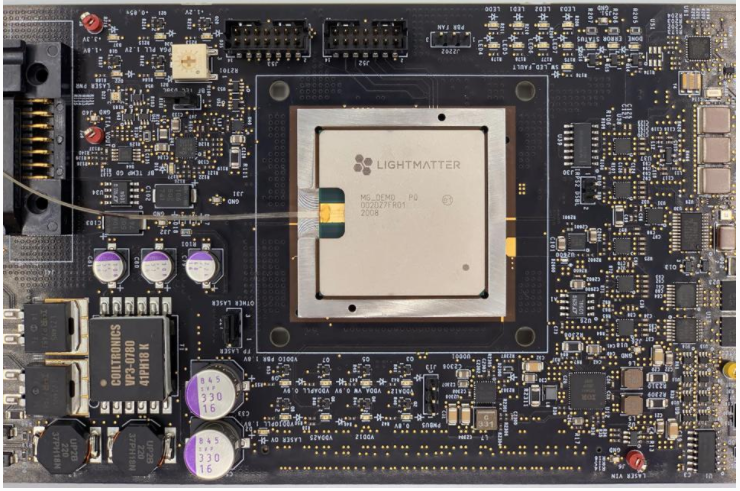

미국 스타트업 라이트매터(Lightmatter)는 지금까지 가장 빠르다고 알려진 엔비디아(NVIDIA)의 인공지능 GPU보다 적은 전력 소모와 10배 빠른 속도를 지닌 포토닉 슈퍼컴퓨터를 개발했다.

라이트매터는 통합 광학 기술을 사용하는 AI 하드웨어 회사로 MIT 출신 스타트업이다.

포브스는 7일(현지시간) 라이트매터 CEO 니콜라스 해리스(Nicholas Harris)와의 인터뷰를 통해 엔비디아보다 빠른 정보 처리가 가능한 슈퍼컴퓨터를 개발했다고 밝혔다.

니콜라스는 테크퍼스트(TechFirst) 팟캐스트에 출연해 “자연어처리 신경망인 BERT나 고급 오픈소스 딥러닝 추천모델 DLRM과 비교해 10배 이상 빠르다."라고 말했다.

엔비디아 A100은 AI 및 고성능 컴퓨팅을 위한 강력한 가속 서버 플랫폼으로 5 페타 플롭 시스템 체제다. 애플의 새로운 M1 칩은 초당 2.6 테라 플롭이다. A100이 출시된 지 1년도 채 안 돼 라이트매터에서 50 페타 플롭의 컴퓨팅 용량을 내세웠다.1000테라 플롭이 1 페타 플롭이다.

컴퓨팅은 전력 소모에 따른 발열도 중요하다. 발열은 서버에 영향을 주고 냉각 과정에서 CPU 실행 속도가 느려진다. 라이트매터는 칩에 코어를 추가해 냉각 시간을 단축시켰다.

해리스 CEO는 연말까지 인바이스(Envise)라는 제품으로 포토닉 슈퍼컴퓨터를 출시하는 것을 목표로 한다고 말했다.

인바이스는 모든 종류의 신경망을 다루는 광자 컴퓨터로 아마존 챗봇 알렉사나 애플 음성 비서 시리처럼 포토닉 슈퍼 컴퓨터에서 인바이스 가이를 실행할 수 있다. 번역, 이미지 속 개별 사물 식별이 가능하다. 개발자가 파이토치(PyTorch), 텐서플로우(TensorFlow)를 사용해 인바이스에서 신경망을 구축할 수 있다.

포브스는 "라이트매터의 기술이 정보 처리 속도가 빨라질수록 발열이 심해지고 전력 소모가 커진다는 전력 추세를 뒤집을 만하다"고 보았다.

한편, AI 소프트웨어 속도 개선을 위한 연구도 진행 중이다. 미국 텍사스 주 라이스대학교 연구팀은 7일 CPU를 활용해 GPU보다 15배 빠르게 심층신경망(DNN)을 훈련시키는 인공지능 소프트웨어를 선보였다.

전자 기술 전문 미디어 테크 엑스플로어(Tech Xplore)는 7일(현지시간) 라이스대학의 CPU를 활용한 인공지능 소프트웨어를 소개하며 CPU 벡터화 및 메모리 최적화 가속기 연구 발표를 예고했다.

심층신경망 훈련은 GPU를 이용해 행렬 곱셈 작업을 하는 것이 일반적이지만 CPU보다 약 3배 비싸다. 라이스대학 CS(Computer Science) 시리바스타바(Shrivastava) 교수는 기계 학습에 드는 비용은 AI 병목 현상이라며, 기업들은 인공지능 훈련과 조정을 위해 수백만 달러를 지출하고 있다고 밝혔다.

라이스대학 연구팀은 서브 선형 딥러닝 엔진(SLIDE)을 CPU에서 실행되도록 설계했다. 시리바스타 교수는 "GPU의 행렬 곱셈에 집착하지 않되 CPU 성능을 활용해 알고리즘 개발에 최선을 다했다. 그 결과 AI 특수 하드웨어보다 4 ~ 15 배 빠른 기계 학습이 가능하다."라고 말했다.

연구 공동 저자 라이스대학 학부생인 니콜라스 메이스버거(Nicholas Meisburger)는 "CPU는 여전히 널리 사용되는 하드웨어이며, CPU를 인공지능에 접목했을 때의 속도 개선은 과소평가할 수 없는 사실."이라고 말했다.

AI타임스 정윤아 기자 donglee0408@aitimes.com

[관련 기사] 엔비디아, 전이 학습 툴킷으로 일반 컴퓨터에서 개인화 AI 모델 가능케 한다

[관련 기사] "양자컴퓨터 해킹 막는 '양자암호기술', 국산화 필수"