구글의 4세대 TPU(Tensor Processing Unit)를 구글 클라우드를 통해 일반 대중이 사용할 수 있게 됐다. TPU는 AI 학습 및 추론에 쓰이는 구글의 반도체 칩이다.

구글이 '클라우드 넥스트 2022(Cloud Next 2022)' 행사에서 지난 6월에 공개한 TPU의 4세대 버전 TPU v4 기반 머신러닝(ML) 클러스터를 구글 클라우드로 제공한다고 더레지스터가 11일(현지시간) 보도했다.

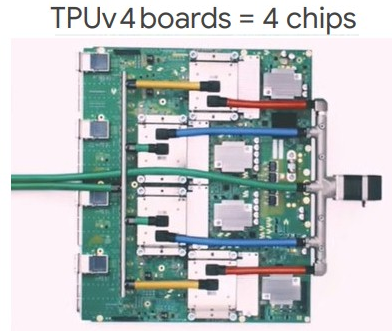

구글 클라우드의 TPU v4 기반 가속기는 가상머신(VM) 1개당 4개의 TPU 칩으로 구성된 단일 TPU 모듈에서 고속 패브릭을 통해 최대 4096개의 칩(TPU VM 1024개)을 연결한 포드(Pod)에 이르기까지 다양한 구성으로 사용할 수 있다. 각 칩의 최고 성능은 275테라플롭이며 각 포드는 최대 1.1엑사플롭의 컴퓨팅 성능을 제공한다.

구글의 TPU 가속기는 자연어 처리, 추천 시스템 및 컴퓨터 비전과 같은 대규모 AI 모델에서 속도를 높이도록 특별히 설계했다. TPU v4는 2개의 TPU v4 Pod에서 훈련된 대규모 언어모델인 PaLM(Pathways Language Model)을 비롯해 자연어 처리, 추천 시스템, 컴퓨터 비전 및 음성인식 등 대규모 AI 모델에서 빠른 속도를 자랑한다.

TPU 가속기는 본질적으로 MXU라고 하는 큰 행렬 연산 엔진의 집합이며, 고대역폭 메모리와 프로그래밍을 가능하도록 만드는 몇 개의 CPU 코어에 의해 제어된다. CPU 코어는 고속 처리를 위해 AI 행렬 연산을 MXU에 공급한다. 각 TPU VM은 각각 2개의 CPU 코어와 총 128GB의 메모리가 있는 4개의 칩으로 구성된다. TPU v4는 TPU v3보다 2배 커진 최대 32GB의 메모리에 액세스할 수 있게 해주며, 2배 더 빠른 임베딩 가속을 제공해 대규모 추천 모델 학습의 성능을 개선하는 데 도움이 된다.

TPU v4는 JAX, 파이토치 및 텐서플로우를 비롯한 다양한 ML 프레임워크를 지원한다. 구글에 따르면 TPU v4의 최대 플롭스는 TPU v3 대비 2.2배 향상됐다. TPU v4의 달러당 최대 플롭스도 1.4배 높아졌다. 연산 성능뿐 아니라 효율성도 좋아진 셈이다.

구글은 미국 오클라호마 데이터 센터에 TPU v4를 이용해 9엑사플롭스의 연산 성능을 지원하는 세계 최대 규모의 머신러닝(ML) 클러스터를 구축했다. 1엑사플롭스는 1초에 100경번의 연산을 처리한다는 의미다. 구글은 이것이 적어도 일반 대중이 액세스할 수 있는 세계에서 가장 큰 허브가 되었다고 주장했다. 또 구글은 이 허브가 시간당 90%의 탄소가 없는 에너지로 작동하고 있다고 밝혔다.

TPU v4 포드는 현재 오클라호마 지역에서 칩마다 시간당 0.97~3.22달러에 제공한다. 구글의 가장 작은 인스턴스는 1년 약정으로 월 5924달러다.

박찬 위원 cpark@aitimes.com