‘챗GPT’로 촉발된 마이크로소프트(MS)와 구글 간의 검색 전쟁이 검색 엔진을 구동하는 AI 컴퓨팅 하드웨어로 번지고 있다.

MS와 구글이 차세대 검색으로 AI 하드웨어 전투를 벌이게 됐다고 컴퓨팅 전문매체인 HPC와이어가 20일(현지시간) 보도했다.

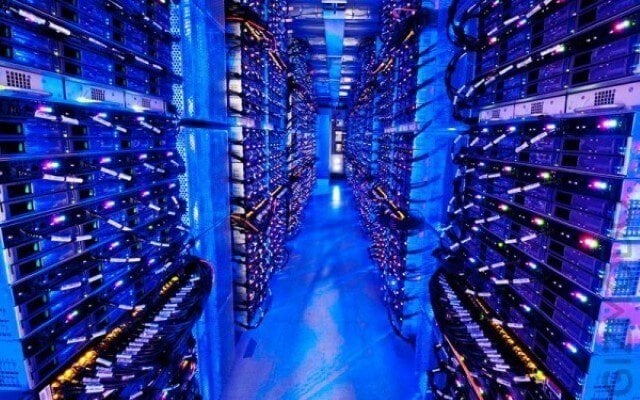

HPC와이어는 검색 엔진이 복잡한 쿼리에 대한 답변을 생성하도록 설계, 그 성공 여부는 AI 컴퓨팅을 지원하는 인프라에 달려 있다고 설명했다. AI 컴퓨팅을 위한 하드웨어 인프라는 응답 속도와 결과의 정확성에 매우 중요하다고 강조했다.

AI는 근본적으로 추론하고 예측하는 능력을 기반으로 하는 다른 스타일의 컴퓨팅인 반면 기존 컴퓨팅은 논리적 계산을 중심으로 진행된다. AI는 행렬 곱셈을 수행할 수 있는 하드웨어에서 수행되는 반면, 기존 컴퓨팅은 데이터의 직렬 처리에 뛰어난 CPU를 중심으로 이뤄졌다.

하지만 두 회사의 AI 컴퓨팅 인프라는 크게 다르며, AI 컴퓨팅 경쟁은 결국 구글의 TPU(Tensor Processing Unit)와 엔비디아의 GPU 간의 싸움이 될 것이라는 예측이다.

우선 챗GPT의 고급 버전을 사용하는 MS의 빙은 세계 5대 슈퍼컴퓨터 중 하나인 애저의 AI 슈퍼컴퓨터에서 구동될 가능성이 높으며, 이는 ms(밀리초)의 정도의 응답 속도로 검색 결과를 제공할 수 있다.

엔비디아와 협력해 구축한 MS의 AI 슈퍼컴퓨터는 28만5000개의 CPU 코어와 1만개의 GPU를 갖추고 있다. 엔비디아는 지난 11월 수만개의 A100 및 H100 GPU를 애저 인프라에 배치하는 계약을 체결했다.

에이미 후드 MS 수석부사장은 “AI 슈퍼컴퓨터를 구축하는 데 수년이 걸렸고, 규모와 속도, 유형을 맞추는 데 많은 투자가 필요했다”며 “슈퍼컴퓨터의 AI 컴퓨팅 비용은 시간이 지남에 따라 계속해서 낮아질 것이다’고 설명했다.

반면 구글은 대화형 AI 검색을 위해 대형 언어 모델 람다의 경량 버전인 바드를 출시하고, 이 모델을 클라우드 서비스의 TPU(Tensor Processing Unit) 칩으로 구동한다.

프라바카르 라그하반 구글 수석 부사장은 "바드는 람다에 비해 훨씬 작은 모델로, 훨씬 더 적은 컴퓨팅 성능을 필요로 한다"며 "즉 더 많은 사용자를 수용할 수 있으며, 더 많은 피드백을 얻을 수 있다"라고 말했다.

TPU는 구글 AI 전략의 핵심 구성 요소다. TPU는 2016년 바둑 챔피언 이세돌을 물리친 알파고를 구동한 것으로 유명하다. 대형 언어모델 람다도 TPU에서 실행되도록 개발됐다.

하지만 현 사양만으로 승부를 예측하기는 어렵다는 분석이 나왔다. 밥 오도넬 테크날리시스 리서치 수석분석가는 "AI 검색을 처리하기 위한 인프라 구축이 아직 진행 중이며, MS와 구글이 파악해야 할 사항이 많다"고 지적했다.

또 “AI 컴퓨팅이 빠르게 진화하고 있기 때문에 주어진 작업에서 5% 더 빠른 것보다 더 유연한 컴퓨팅 플랫폼을 갖추는 것이 더 중요하다”고 말했다.

박찬 위원 cpark@aitimes.com