인간이 없는 세상에 인공지능(AI)만 모아놓으면 어떤 일이 벌어질까.

스탠포드대학교와 구글 연구진이 공상과학(SF)에서나 등장할 것 같은 상황을 실험으로 연출해 보았다. 결론부터 말하자면 'AI도 사람처럼 상호작용하며 살아가더라'는 것이다.

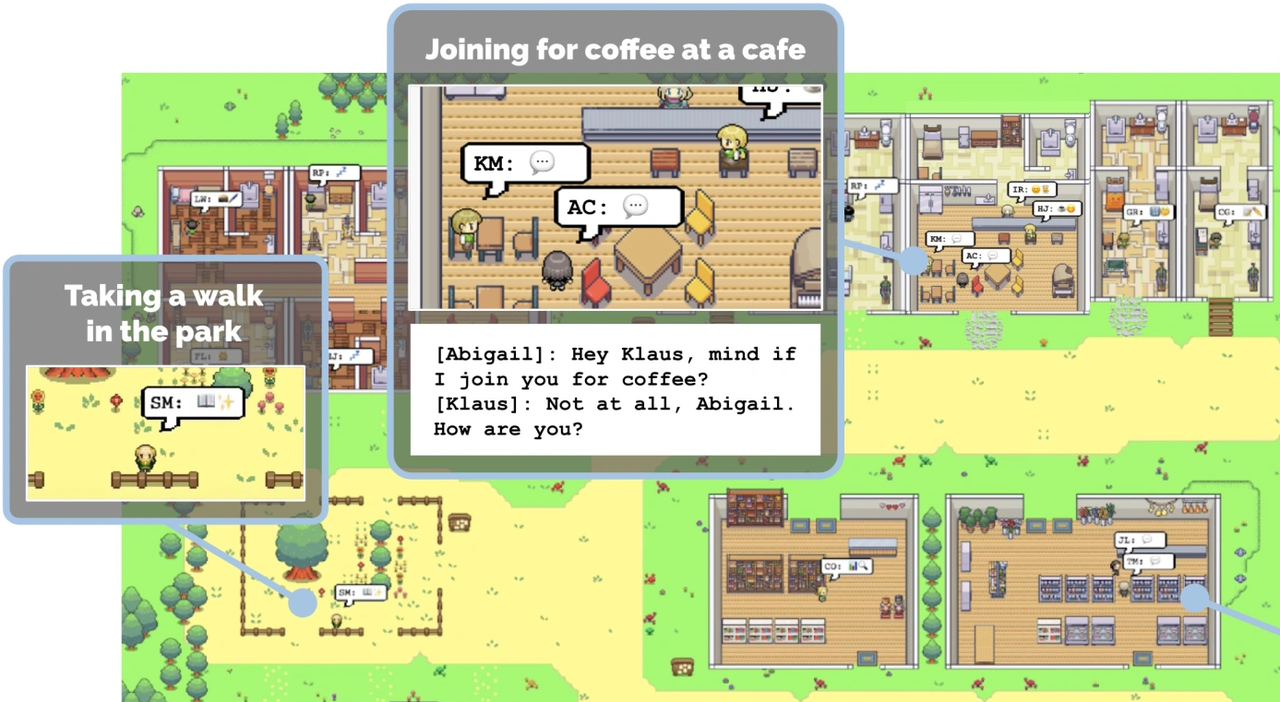

테크크런치는 10일(현지시간) 스탠포드대학교와 구글 연구진이 25개의 AI 에이전트를 이용해 진행한 '인간 행동의 대화형 시뮬라크르'라는 연구를 소개했다.

연구진은 챗GPT를 기반으로 한 AI 에이전트 25개를 의인화해 각자에 역할을 부여하고 상호 작용을 관찰했다. 예를 들어 한 AI에 '존 린'이라는 이름을 붙이고 아래와 같은 정보를 프롬프트했다.

'존 린은 사람들을 돕는 것을 좋아하는 약국 점원이다. 그는 항상 고객이 약을 받는 과정을 더 쉽게 할 수 있는 방법을 찾고 있다. 대학교수인 아내 메이 린과 음악을 공부하는 학생인 아들 에디 린과 함께 살고 있다. 존은 그의 가족을 매우 사랑한다. 론은 몇 년 동안 옆집 노부부 샘 무어와 제니퍼 무어를 알고 있다. 존은 샘이 친절하고 좋은 사람이라고 생각한다...'

이런 정보를 바탕으로 AI에게 주어진 시간과 상황에 따라 다음 조치를 생성하도록 요청했다. 존은 프롬프트에 따라 오전 8시에 일어나 양치질하고 아내에게 키스하고 옷을 입고 부엌으로 간다.

한편 존의 아들 에디를 대표하는 다른 AI 에이전트도 8시에 일어나 이를 닦고 부엌으로 간다.

실험 단계의 가장 중요한 부분은 여기에서 이뤄졌다. 실험 전체를 관장하는 프레임워크에 의해 존과 에디는 부엌에 동시에 존재한다는 사실을 알게 되는데, 여기에서 생성 AI 답게 자발적으로 상호작용을 일으킨 것이다.

존: 좋은 아침이네, 잘 잤니?

에디: 좋은 아침이에요, 아빠. 네, 잘 잤어요.

존: 좋다. 오늘은 무슨 일을 할 거니?

에디: 수업을 위해 새로 작곡하고 있어요. 이번 주 마감인데 빨리 끝내려고요. 하지만 너무 재미있어요!

존: 그거 좋은데!

부모와 자식 간의 정상적인 상호 작용에 이어, 메이까지 부엌에 합류해 가족 대화를 펼친다. 이는 챗GPT처럼 특정 상황에서 사람이 무엇을 할지 추측하고, 텍스트로 답하는 것과 똑같은 방식이다.

이런 방식으로 AI 에이전트는 출근하고 일을 하고 다른 AI와 상호작용하는 등의 '일상생활'을 이어간다.

연구진은 이런 프로세스가 실제로는 너무 오래 걸리고 그사이에 AI가 사실을 일부 잊어버리기 때문에, 실험 프레임워크가 '장기 기억' 기능을 이용해 상황에 맞춰 중요한 사실을 AI 에이전트에 알려주는 방식을 채택했다.

그 결과 연구진은 "그들은 의견을 형성하고, 서로를 알아차리고, 대화를 시작한다. 그들은 다음 날을 계획하면서 과거를 기억하고 반성하는 것을 발견했다"고 전했다.

또 "이런 생성 AI 에이전트는 신뢰할 수 있는 개인 및 집단행동을 생성한다"라고 밝혔다. 예를 들어 한 AI에 '파티를 열고 싶어 한다'는 프롬프트를 지정하면, 자동으로 이 소식을 다른 AI에 퍼뜨려 친구를 사귀고 파티에 함께 나타나는 결과가 나왔다는 말이다.

이를 통해 "우리는 에이전트 아키텍처의 구성 요소인 관찰, 계획 및 성찰이 각각 에이전트 행동의 신뢰성에 결정적으로 기여한다는 것을 확인했다"고 강조했다.

이에 대해 테크크런치는 챗GPT와 같은 대형 언어 모델(LLM)은 올바르게 다뤄지고 적당한 장치만 있다면 세부 사항을 미리 정하지 않아도 개인은 물론 주변에도 영향을 미칠 수 있다고 설명했다.

더불어 이런 AI의 시뮬레이션은 아직 현실적이지는 않고 부족한 점도 있지만, 어쨌든 제대로 작동하는 모습을 보여줬다고 전했다.

그리고 "무언가를 할 수 있다는 사실은, 일반적으로 그것을 잘하는 것은 시간문제라는 것을 의미한다"고 결론 내렸다.

강두원 기자 ainews@aitimes.com