인공지능(AI) 챗봇에게 적합한 GPU 임대 규모를 질문하고 활용하는 사례가 눈길을 끌고 있다.

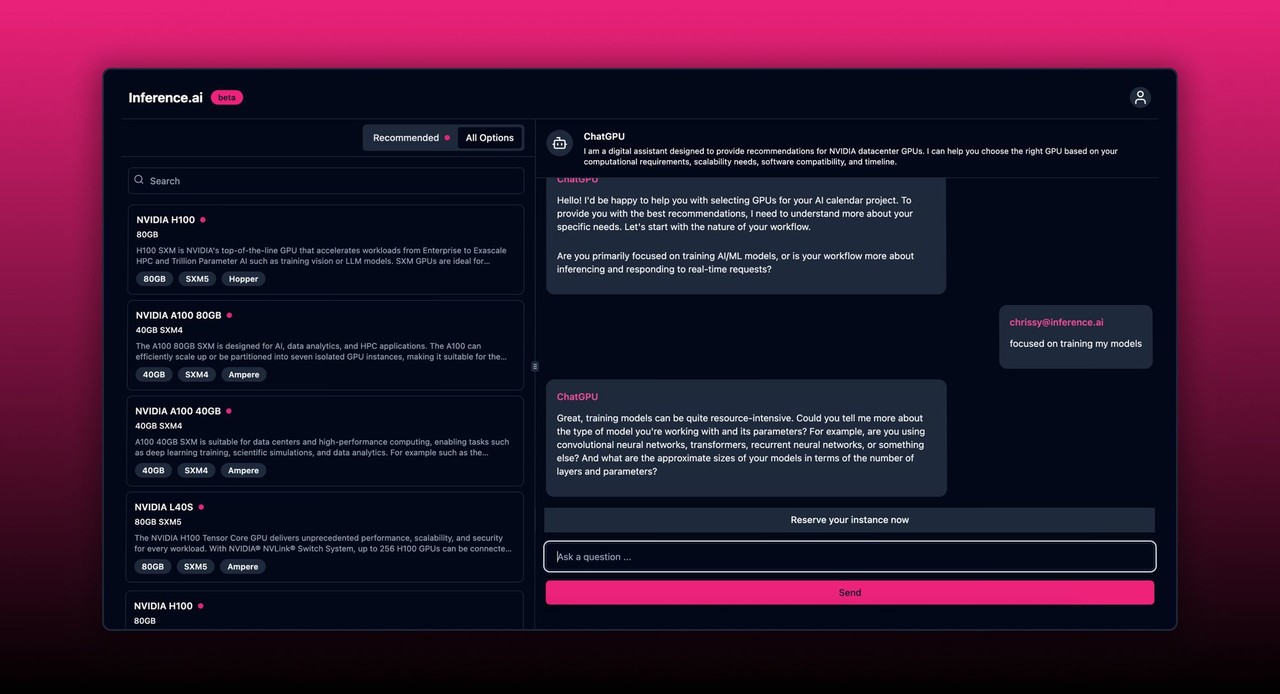

실리콘앵글은 21일(현지시간) GPU 클라우드 운영 업체인 인퍼런스닷에이아이가 생성 AI 챗봇을 활용, 기업의 훈련 및 추론 워크로드에 가장 적합한 규모의 GPU 선택을 지원한다고 보도했다.

이 회사는 기업용 GPU 클라우드를 운영하는 스타트업 중 하나다. GPU는 가격이 비쌀 뿐만 아니라 공급이 부족하기 때문에, 기업이 필요한 만큼만 임대하게 한다는 전략을 가지고 있다.

인퍼런스닷에이아이는 'H100' 등 엔비디아의 18가지 프로세서로 구성된 다양한 GPU를 제공한다. 이 외에도 'MI300X'를 포함 AMD의 4가지 모델을 제공한다.

또 이 회사는 전 세계에 분산된 데이터센터 네트워크를 구축, 기업이 어디에서나 짧은 시간 안에 GPU에 액세스할 수 있도록 해 실시간 애플리케이션 개발을 지원한다.

특히 AWS., 마이크로소프트(MS) 애저, 구글 클라우드와 같은 클라우드 대기업이 제공하는 가격보다 최대 82% 저렴한 업계 최저 가격을 제공한다고 주장한다. 이를 위해 기업이 성능 요구 사항과 예산에 따라 가장 적절한 규모의 GPU를 선택할 수 있도록 설계된 새로운 AI 챗봇을 제공하고 있다고 밝혔다.

AI 챗봇은 사용자의 AI 프로젝트에 필요한 컴퓨팅 요구 사항을 파악하기 위해 프로젝트 컨셉트에 대해 자연어로 간단한 질문을 한다. 그 다음 AI 프로젝트를 가장 빠르게 구현하기 위한 최적의 GPU 설정을 제안한다.

대부분 기업이 처음으로 AI 프로젝트에 착수하면 어떤 인프라가 필요한지 파악하는 경험이 부족하기 때문에 불확실성이 많다고 전했다. 어떤 GPU 모델이 가장 적합한지, 실제로 필요한 칩 수는 얼마나 되는지, AI 모델을 훈련하는 데 시간이 얼마나 걸리는지 전혀 알지 못한다는 설명이다.

존 유에 인퍼런스닷에이아이 CEO는 GPU 리소스를 선택하는 과정을 자동차 구입에 비유하며 “누구도 먼저 테스트 드라이브를 하지 않고는 지갑을 열지 않을 것”이라며 “사람들은 필요한 처리 능력에 대한 막연한 추측을 바탕으로 2년 GPU 약정을 구매하고 있으며, GPU는 자동차보다 훨씬 비싸다”라고 지적했다. 이어 "우리 솔루션은 고객이 비용을 지출하기 전에 GPU가 얼마나 필요한지 정확히 알려준다"라고 강조했다.

현재 베타 테스트에서 사용할 수 있는 AI 챗봇은 GPU 소싱의 전체 과정를 통해 사용자를 안내하도록 설계됐다. 첫번째 단계는 기업이 수행하고자 하는 AI 프로젝트를 일반 영어로 설명하는 것이다. 그 다음 챗봇은 정확한 컴퓨팅 요구 사항을 파악하기 위해 프로젝트에 대한 질문으로 응답한다. 예를 들어 ‘AI 모델이 처음부터 만들어지는가, 아니면 기존 모델을 활용하는가’와 같은 식이다.

챗봇이 고객의 컴퓨팅 요구 사항, 예산, 확장성 요구 사항, 소프트웨어 호환성 및 타임라인을 식별하면 기업에 가장 적합한 GPU의 정제된 목록을 제공한다. 여기에는 비용, 속도, 기타 요소의 우선 순위를 결정한 경우 특정 권장 사항과 몇가지 대안이 포함된다. 마지막으로 최종 선택이 이뤄지면, 챗봇은 이를 인퍼런스닷에이아이 영업팀에 연결해 결제 및 배포를 처리한다.

예를 들어, 고객은 만화가에게 그림을 설명하기 위해 대형언어모델(LLM)을 사용하는 AI 애플리케이션을 만드는 것을 목표로 챗봇과 대화할 수 있다. 챗봇은 설명을 요청하는 페이지 수, 아트워크 해상도, 사용할 훈련 데이터의 전체 파일 크기 등 모델의 훈련 요구 사항에 대해 질문을 한다.

유에 CEO는 “우리의 목표는 누구나 인프라 투자에 실수할 염려 없이 AI 프로젝트가 쉽게 수행될 수 있도록 하는 것”이라며 “AI를 사용해 기업이 비용을 최적화하고 프로젝트가 일정대로 완료되도록 하기 위해 필요한 GPU 용량을 계산하는 데 도움을 준다”라고 말했다.

박찬 기자 cpark@aitimes.com