대형언어모델(LLM)을 기반으로 실시간으로 채팅할 수 있게 만드는 인공지능(AI) 추론 칩 '그로크'의 성능을 끌어 올렸다. 지난 2월 출시한 그로크의 추론 속도를 1.5배가량 더 빠르게 만들었다.

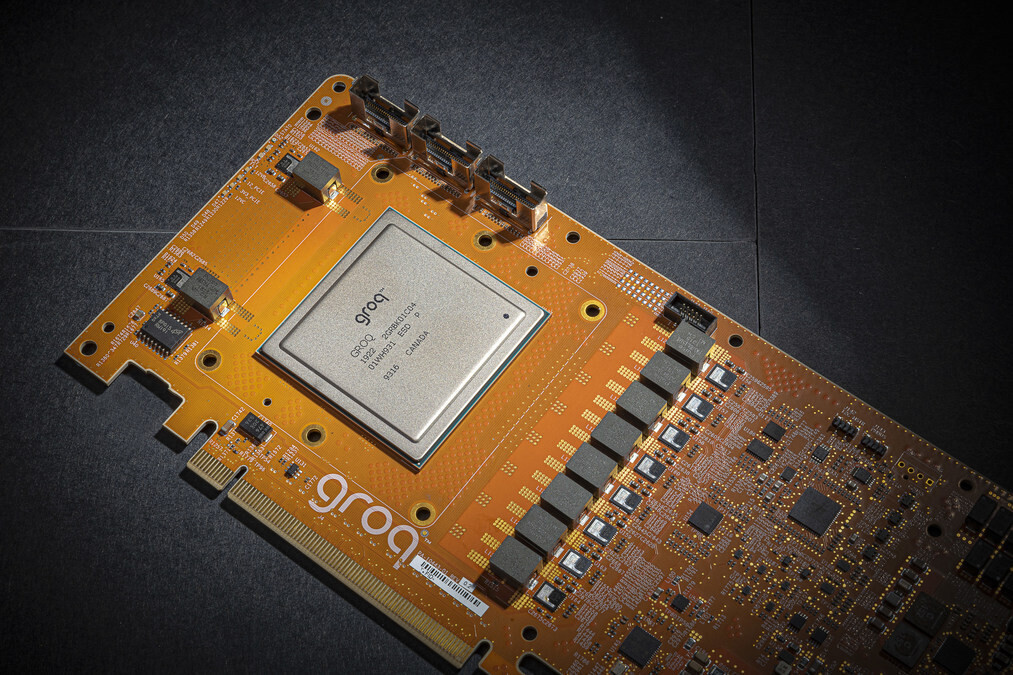

벤처비트는 8일(현지시간) AI 스타트업 그로크가 LLM과 같은 컴퓨팅 집약적인 애플리케이션의 처리 속도를 높이기 위해 최적화한 AI 칩 ‘언어 처리 장치(LPU)’의 업그레이드를 공개했다고 보도했다.

LPU는 5120개의 벡터 ALU(산술 논리 장치) 외에 320x320 행렬 곱셈을 통해 INT8에서 750TOPS(1초당 1조번의 AI 연산), FP16에서 188TFLOPS를 달성하는 TSP(Tensor-Streaming Processor) 아키텍처를 기반으로 하는 단일 코어 장치이며, 초당 80TB의 대역폭을 갖춘 230MB의 로컬 SRAM를 제공한다.

특히 이번에 공개된 LPU는 지난 2월 출시 당시 초당 800토큰에 비해 빨라진 초당 약 1256.24토큰 속도로 실시간 응답을 제공한다. 엔비디아 GPU에 비해 압도적인 속도라는 설명이다.

또 대부분의 워크로드에서 엔비디아 GPU의 10분의 1 정도의 전력만 사용한다. 가장 성능이 떨어지는 경우에도 GPU의 3분의 1에 불과하다.

기본적으로 LPU는 메타의 '라마3-8b-8192'를 사용하며, '라마3-70b'나 구글 '젬마' 및 '미스트랄' 모델 중에서 선택할 수 있다. 다른 모델도 지원할 예정이다.

오픈AI '위스퍼 라지 V3' 모델을 사용해 음성 입력도 지원한다. 오픈AI에서 구축하는 앱을 몇초 만에 그로크로 전환할 수도 있다.

한편 그로크는 개발자들에게 LPU를 통해 LLM 워크로드를 무료로 구동하는 서비스를 제공했으며, 이는 4개월 만에 사용자 28만2000명을 넘어선 것으로 알려졌다.

박찬 기자 cpark@aitimes.com