이스라엘 스타트업 AI21 랩스가 '트랜스포머' 아키텍처를 보완한 오픈 소스 대형언어모델(LLM) ‘잠바(Jamba)’의 새로운 버전을 출시했다. 기존 LLM들과 달리, 이 모델은 트랜스포머 아키텍처에 'SSM(State Space Model)' 아키텍처를 결합한 것이 특징이다.

벤처비트는 22일(현지시간) AI21이 지난 3월 공개한 LLM ‘잠바 1.0'의 새로운 버전인 ▲잠바 1.5 미니 ▲잠바 1.5 라지를 오픈 소스로 출시했다고 보도했다.

이에 따르면 잠바는 컨텍스트 창이 커짐에 따라 추론이 느려지고 메모리 공간이 많이 필요한 트랜스포머 아키텍처의 약점을 보완하기 위해 맘바 SSM 아키텍처를 트랜스포머 아키텍처에 결합했다.

2017년 구글이 개발해 공개한 트랜스포머는 LLM 대중화를 가능케 한 주역으로 꼽힌다. 하지만 트랜스포머는 한계도 명확하다. 트랜스포머 기반 모델은 입력되는 모든 정보를 처리하기 때문에 컨텍스트 창이 커질 때 느려지는 문제가 있다.

또 컨텍스트 길이가 커질수록 훨씬 더 큰 메모리 공간을 필요로 하기 때문에 하드웨어 리소스 없이 긴 컨텍스트 창을 실행하기 어렵다.

카네기멜론대학교와 프린스턴대학교 연구진이 공개한 '맘바(Mamba)'는 트랜스포머보다 AI 성능을 키우고 단점은 줄이는데 초점이 맞춰져 있다. 언어, 오디오 등 다양한 유형들을 커버하는 SSM을 활용, 입력된 정보 중 중요 데이터에 선택적으로 집중할 수 있다. 이를 위해 맘바는 각 단계들에서 어떤 정보에 집중하거나 무시할지 선택할 수 있는 특화된 레이어를 제공한다.

맘바를 변형한 잠바 1.5는 SSM과 트랜스포머의 하이브리드 형태다. 특히 25만6000 토큰 길이의 컨텍스트 창을 제공, 현존 오픈 소스 모델 중 가장 큰 처리량을 자랑한다.

또 맘바-트랜스포머 아키텍처에 ‘전문가 혼합(MoE)’ 모델을 채택, 복잡한 추론 작업을 처리할 수 있다.

MoE는 여러 모델 중 일부만을 사용해 효율을 높이는 방식으로, 이를 통해 잠바 1.5 미니는 520억 매개변수 가운데 120억개만 활성화한다. 잠바 1.5 라지는 3980억 매개변수 가운데 940억개만 사용한다. 즉, 동일한 크기의 트랜스포머 전용 모델보다 더 효율적이라는 설명이다.

특히 사용자를 대신해 작업을 수행할 수 있는 ‘AI 에이전트’ 시스템을 만드는 데 최적화, 함수 호출이나 도구 사용, JSON 모드, 인용 모드 및 구조화된 문서 개체와 같은 에이전트 기능을 지원한다.

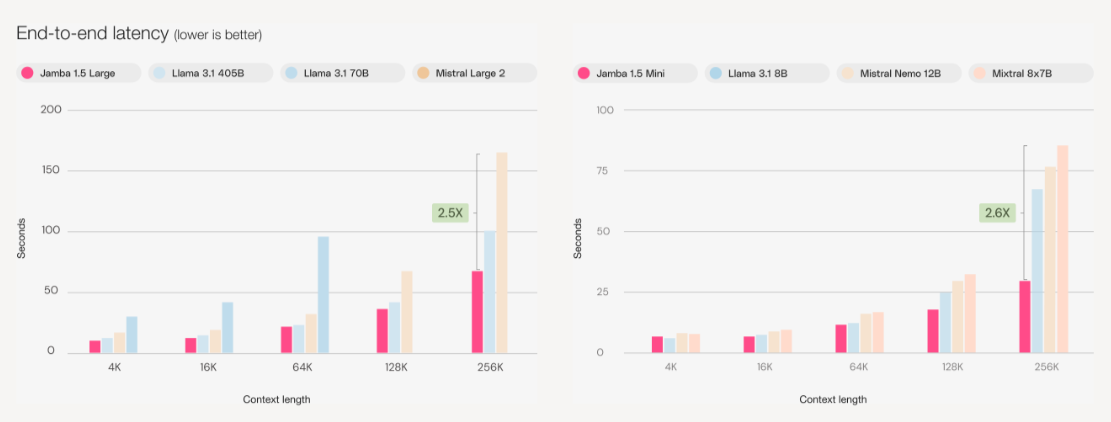

벤치마크 테스트에서는 '라마 3.1 70B' '라마 3.1 405B' '미스트랄 라지 2' 등의 오픈 소스 모델에 비해, 가장 긴 컨텍스트 창에서 2배나 빠른 응답 지연 시간을 달성했다고 밝혔다.

현재 잠바 1.5 모델은 허깅페이스에서 오픈 라이선스로 제공되며, 상업적 용도로 사용 가능하다. AI21는 AWS, 구글 클라우드, 마이크로소프트(MS) 애저, 스노우플레이크, 데이터브릭스, 엔비디아와도 파트너십을 맺고 있다.

박찬 기자 cpark@aitimes.com

- UAE, 오픈 소스 동급 최강 '팰컨 맘바 7B' 출시..."트랜스포머 아키텍처 대안"

- "트랜스포머 대체할 새 아키텍처 개발...더 많은 데이터 저비용 처리 가능"

- AI21 랩스, 트랜스포머 아키텍처 보완한 ‘잠바’ 공개

- 스노우플레이크, '라마 3.1' 한국어 지원…”국내 엔터프라이즈 진출 강화할 것”

- MS, 'o1' 빼닮은 ‘그린-MoE’ 모델 출시..."코딩·수학 뛰어난 저가형 모델"

- AI2, 오픈 소스 LMM ‘몰모’ 공개..."100배 적은 데이터 학습으로 GPT-4o 능가"

- AI21 "트랜스포머는 AI 에이전트에 안 맞아...대체 아키텍처 필요"

- '트랜스포머 대안' 맘바 아키텍처, 음성 복제 AI 모델 구축에도 활용