인공지능(AI) 호스팅 플랫폼인 허깅페이스에 등록된 AI 모델의 수가 100만개를 넘어섰다는 소식이다. 이는 1년 만에 4배 이상 증가한 수치로, 그만큼 AI 연구와 개발이 크게 늘었다는 증거다.

26일(현지시간) 아스테크니카에 따르면, 허깅페이스는 플랫폼에 호스팅된 AI 모델의 수가 100만개를 초과했다고 발표했다.

허깅페이스는 2016년 챗봇 앱으로 시작해 2020년 AI 모델을 위한 오픈 소스 허브로 전환했으며, 현재 개발자와 연구자를 위한 도구를 호스팅한다.

클레망 델랑그 허깅페이스 CEO는 "라마나 젬마, 파이, 플럭스, 미스트랄, 스타코더, 큐원, 스테이블 디퓨전, 그록, 위스퍼, 올모, 커맨드, 제퍼, 오픈ELM, 잠바, 이(Yi) 같은 유명 AI 모델뿐만 아니라 99만9984개의 다른 모델도 호스팅하고 있다"라고 말했다.

많은 모델이 등장한 이유를 “모든 작업을 수행할 수 있는 하나의 모델 보다는 특정 용도나 도메인, 언어에 맞게 미세조정된 소형 맞춤형 모델이 필요하기 때문”이라고 설명했다.

또 허깅페이스 플랫폼에는 특정 개인과 기업만을 위한 비공개 모델도 많이 올라와 있다고 덧붙였다.

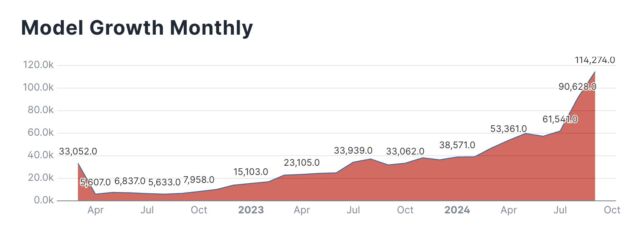

지난해 8월 25만개였던 AI 모델 수는 1년 만에 4배 가량 증가했다. 칼렙 팔그렌 허깅페이스 제품 엔지니어는 X(트위터)를 통해 “모델 수가 매달 기하급수적으로 증가하고 있다”라고 밝혔다.

허깅페이스의 AI 모델 증가는 AI 연구 및 개발의 급속한 발전을 보여준다. 또 오픈 소스의 확대를 대변하기도 한다.

다만, 상당수 모델들이 테스트 목적으로 등록된 것으로, 성능이나 품질 면에서 완성도가 떨어진다는 지적이 있다.

한편, 가장 다운로드 수가 많은 모델은 MIT의 '오디오 스펙트로그램 트랜스포머(Audio Spectrogram Transformer)'가 차지했다. 무려 1억6300만회의 다운로드를 기록했다.

뒤를 이어 현재 대형언어모델(LLM)의 시초인 구글의 'BERT'가 5420만회 다운로드를 기록했다.

허깅페이스는 "10초마다 새로운 모델이나 데이터셋을 위한 저장소가 생성되고 있다"라며 "결국 코드 저장소 수만큼의 모델이 등장할 것"으로 예상했다.

박찬 기자 cpark@aitimes.com