알리바바가 추론 모델 'QwQ'을 내놓은 지 한달 만에, 멀티모달 추론 모델 'QvQ'를 오픈 소스로 출시했다. 추론 분야에서도 오픈AI를 빠르게 추격하는 양상이다.

알리바바 큐원팀은 25일 허깅페이스를 통해 'QVQ-72B-프리뷰(Preview)'를 공개했다. 오픈 소스 모델 중 오픈AI의 'o1'과 비교하는 추론 강화 멀티모달 모델이 등장한 것은 거의 처음이라고 볼 수 있다.

연구진은 "언어와 시각은 인간의 정신 속에서 서로 얽혀 우리가 주변 세계를 인식하고 이해하는 방식을 형성하고, 추론 능력은 언어적 사고와 시각적 기억에 깊이 뿌리를 두고 있다"라며 "복잡한 물리 문제를 살펴보고, 물리학의 거장처럼 확신을 가지고 체계적으로 추론하여 해결책을 도출할 수 있는 AI를 개발하자는 영감에 따라 QVQ를 만들었다"라고 밝혔다.

QVQ는 '큐원2-VL-72B'를 기반으로 한 멀티모달 추론용 모델이라고 소개했다.

문맥을 유지하며 시각 및 언어 정보를 통합하는 계층적 구조를 사용한다. 이를 통해 정확성은 떨어 뜨리지 않고 계산 리소스를 효과적으로 사용할 수 있도록 했다. 또 텍스트와 이미지 입력을 위해 고급 트랜스포머 아키텍처를 기반으로 하는 정렬 메커니즘을 도입, 텍스트와 이미지 간 정확한 임베딩에 집중했다. 이를 통해 AI의 시각적 이해와 복잡한 문제 해결 능력을 크게 향상했다고 전했다.

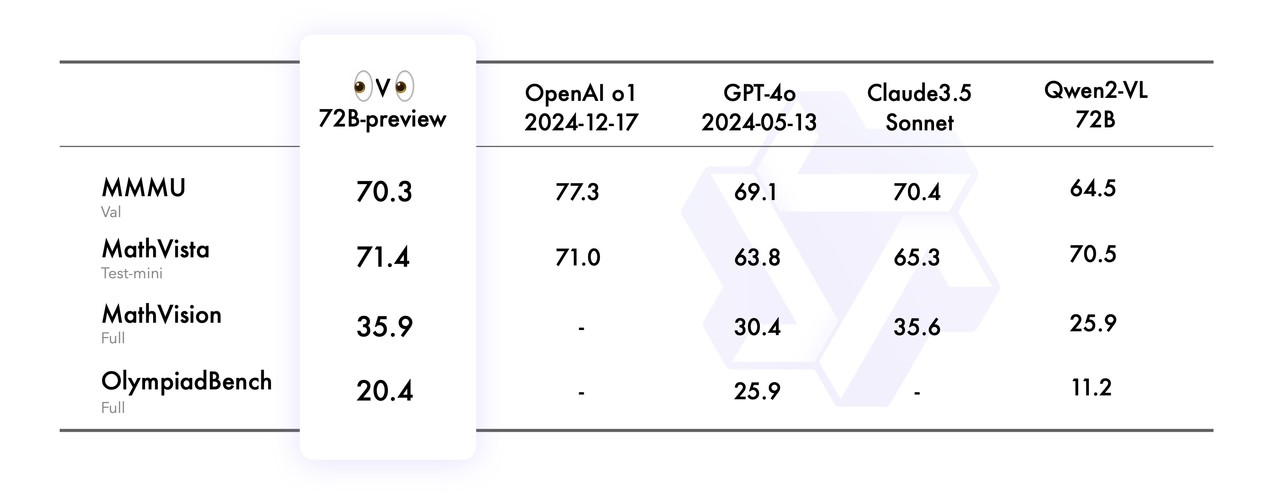

최근 출시 트렌드에 따라 벤치마크 점수를 강조했다. 이 모델은 대학 수준의 시각적 이해 및 추론 능력을 평가하는 MMMU에서 70.3점으로, 오픈AI의 o1 최신 버전인 'o1-2024-12-17(77.3점)'이나 앤트로픽의 '클로드 3.5 소네트(70.4점)'보다는 성능이 떨어진다.

그러나 도형이나 그래프 등으로 시각적 수학 능력을 측정하는 매스비스타(MathVista)에서는 71.4점으로 다른 모델을 5점 차 이상 앞섰다. 또 실제 수학 경연대회 문제에서 파생한 매스비전(MathVision)에서도 클로드를 0.3점차로 앞서며 최고 성능을 기록했다.

다만, 멀티모달 과학 벤치마크인 올림피아드벤치(OlympiadBench)에서는 'GPT-4o'점 이상 뒤처졌다.

특히 소스 모델인 큐원2VL-72B보다는 모든 벤치마크에서 0.9~10점의 성능 향상을 보였다. 이는 설명대로 멀티모달 추론 강화에 따른 것이다.

이에 대해 연구진은 "기대치를 넘는 성능을 보여줬으며, 첨단 o1과의 격차를 효과적으로 줄였다"라고 평했다. 하지만 한계가 있다는 것도 인정했다.

모델이 언어를 혼합하거나 예기치 않게 전환해 응답의 명확성에 영향을 미칠 수 있으며, 모델이 순환 논리 패턴에 갇혀 결론에 도달하지 못하고 장황한 응답을 생성할 수 있다는 것이다. 또 다단계 시각 추론 도중 이미지 콘텐츠에 대한 초점을 잃고 환각을 일으킬 수 있다고 경고했다.

한편, o1 이후 중국에서도 추론 중심 모델이 증가하는 가운데 오픈 소스 멀티모달이 등장한 것은 처음이다. 미국에서는 메타가 내년 출시할 '라마 4'를 멀티모달용 추론 모델로 개발 중이라고 밝힌 정도다.

이에 앞서 알리바바는 지난달 28일 ‘테스트-타임 컴퓨트(Test-Time Compute)’ 기술을 적용한 추론 모델인 ‘QwQ-32B-프리뷰’를 오픈 소스로 출시했다. 이처럼 한달 새 오픈 소스 추론 모델을 2종이나 출시하며, 이 분야에서도 오픈AI를 빠르게 추격하고 있다.

임대준 기자 ydj@aitimes.com

- 경쟁사들이 o1을 빨리 추격할 수 있었던 이유..."o1으로 생성한 데이터를 학습"

- 알리바바, 'o1'에 정식 도전장...오픈 소스 추론 모델 'QwQ' 출시

- 'o1' 출시 두달 만에 추론 경쟁자들 턱 밑까지 추격

- 중국서 'o1'과 경쟁하는 추론 모델 ‘딥시크-R1’ 출시

- 중국 스텝펀, 1조개 이상 매개변수 LLM ‘스텝-2’ 개발 중…수억달러 규모 투자 유치

- o1 같은 추론 모델 구축용 '강화 학습 프레임워크' 잇달아 등장

- 알리바바, 유니콘 스타트업 01.AI와 산업용 LLM 개발...업계 통합 신호탄 되나

- 알리바바, 아프리카 휴대폰에 LLM 공급..."신흥 AI 시장 선점"

- UAE, 이미지까지 추론하는 멀티모달모델 ‘라마V-o1’ 출시

- 오픈AI, o1·o3-미니에 이미지·파일 업로드 지원..."추론도 멀티모달로"

- 알리바바, 비디오 생성 AI 모델 오픈 소스 출시…추론 모델 ‘QwQ-맥스’도 공개