오픈AI의 'o1'이나 '딥시크-R1' 같은 추론 모델은 간단한 쿼리에도 너무 많이 생각하는 ‘과잉 사고(overthinking)’ 문제를 안고 있다. 사소한 문제에 과도한 계산 자원을 소모하거나 불필요한 추론 과정을 반복, 비용을 쓸데없이 키운다는 것이다.

메타와 일리노이대학교 시카고 연구진은 5일(현지시간) 추론 전문 모델의 과잉 사고 문제를 해결하기 위한 학습 방법을 온라인 아카이브에 게재했다. 논문 제목은 '더 열심히가 아니라 더 똑똑하게 생각하세요: 추론 인식 최적화를 통한 적응 추론'이다.

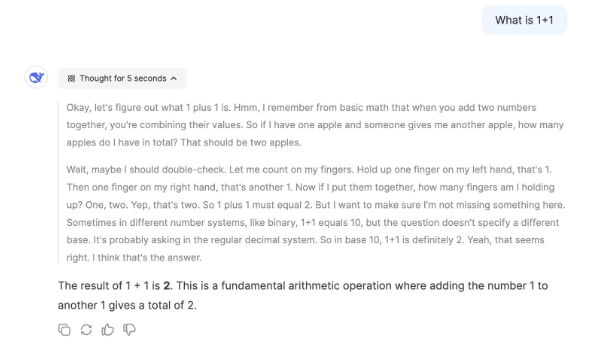

과잉 사고는 계산 비용을 크게 증가시키지만, 결과의 정확성을 높이는 데 별다른 기여를 하지 않는 경우를 말한다. 예를 들어, ‘1+1’같은 간단한 쿼리에도 o1이나 R1같은 추론 모델은 대답하기 전에 시간과 리소스를 추가로 할당한다. 이는 모델의 실용성을 크게 떨어뜨린다.

이 문제를 해결하기 위해 연구진은 모델 학습 과정에 쿼리의 난이도에 따라 추론 추적 길이를 조정하도록 모델을 훈련하는 ‘추론 예산-제한 정책 최적화(IBPO)’ 접근법을 제안했다.

IBPO는 대형언어모델(LLM)이 정해진 추론 비용 안에서 최적의 답변을 만들 수 있도록 돕는 기술이다. 이 방법은 강화학습을 활용, 모델이 스스로 다양한 답변을 시도하고 평가하며 정확하면서도 비용을 효율적으로 사용하는 최적의 답을 찾도록 한다.

이를 통해 사람이 직접 데이터를 만들어 학습하는 것보다 더 좋은 성능을 낼 수 있다.

실험 결과, IBPO를 사용하면 한정된 추론 예산 내에서 더 좋은 성능을 낼 수 있는 것으로 나타났다. 같은 조건에서 IBPO로 학습한 모델이 다른 모델보다 더 효율적이고 정확한 답을 만들어낸다는 설명이다.

한편, 이처럼 추론 모델의 과잉 사고 문제를 해결하는 시도는 계속 등장하고 있다.

지난 1월에는 텐센트와 상하이 자오퉁대학교 연구진이 모델의 반성적 사고(reflective reasoning) 능력을 유지해 불필요한 추론 과정을 줄이는 자기 학습(self-training) 접근법에 관한 논문을 발표했다. 논문 제목은 '2+3에 대해 많이 생각하지 마세요. o1 유사모델(o1-Like LLM)에 대한 과잉 사고에 관하여'다.

또, 지난해 12월에는 난징대학교와 러트거스대학교, 매사추세츠대학교 애머스트 연구진이 토큰 예산 인식 LLM 추론 프레임워크인 'TALE(Token-Budget-Aware LLM rEasoning)'에 관한 논문을 발표했다.

박찬 기자 cpark@aitimes.com