국내 인공지능(AI) 스타트업 딥오토(DeepAuto.ai)가 대형언어모델(LLM)의 장기 컨텍스트 처리의 효율을 강화하고 추론 성능을 높이는 기술을 공개했다. 이는 해외의 주요 테크 사이트에 소개됐으며, LG유플러스의 '익시오'에도 적용될 예정으로 알려졌다.

마크테크포스트는 16일(현지시간) 딥오토와 한국과학기술원(KAIST) 연구진이 긴 컨텍스트 처리를 효율적으로 해결하고 계산 비용을 효율화하는 기술을 선보였다고 소개했다.

논문은 지난달 23일 최종 수정, 온라인 아카이브에 업로드됐다. 관련 내용은 깃허브를 통해 비상업적 용도로 공유됐다.

딥오토 연구진은 LLM에서 맥락 길이를 늘이는 것은 텍스트 작성은 물론, 멀티 모달 기능과 검색 증강 생성(RAG) 등의 성능 개선에서 매우 중요하지만, 긴 컨텍스트는 급격하게 증가하는 계산 시간과 비용 등으로 인해 모델 성능 저하를 일으킨다고 지적했다.

이를 해결하기 위해 미세조정을 통하는 방법도 있지만, 재학습에 들어가는 고품질의 데이터셋 구축 등으로 인해 역시 효율적인 방법은 아니라고 봤다.

이 때문에 딥오토는 메모리 병목 현상을 완화하는 동시에 효율적인 장문맥 추론을 가능하게 하는 '인피니트HiP(InfiniteHiP)'라는 프레임워크를 소개했다.

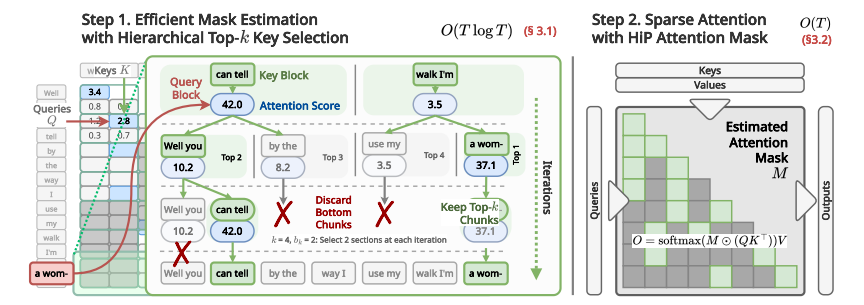

'계층적 가지치기 어텐션(Hierarchically Pruned Attention)'이라는 용어처럼, 어텐션 계산 과정에서 덜 관련성 있는 문맥을 제거하는 토큰 가지치기가 핵심이다.

즉, 추론 과정에서 중요한 토큰만 보존하고 나머지는 삭제하는 것으로, 이를 여러 단계에 걸쳐 적용해 효율성을 계속 높인다. 또 다른 가지치기와 달리, 이 방식은 완전 병렬화로 계산 효율을 높였다.

특히 KV 캐시 관리 시스템으로 메모리 활용을 최적화하고 효율적인 검색을 유지하도록 했다. 또 적응형 RoPE(Rotary Positional Embeddings) 조정을 적용, 모델이 추가 학습 없이 더 긴 출력을 내놓을 수 있도록 했다.

이를 통해 인피니트HiP을 적용한 모델은 48GB GPU에서 최대 300만개의 토큰을 처리할 수 있다고 밝혔다. 장문맥 추론에 매우 효과적이라는 방법이라고 말이다.

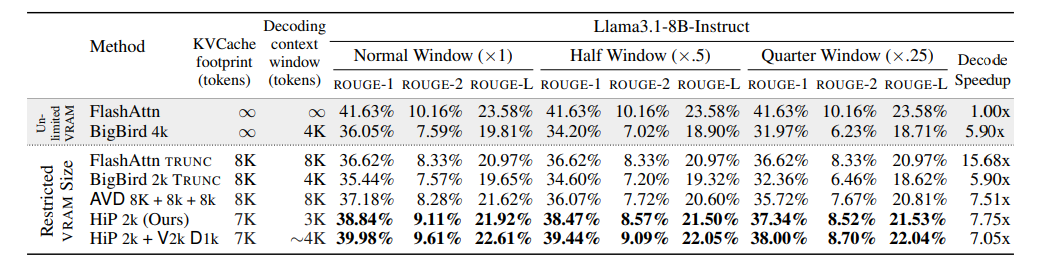

기존 방식과 비교했을 때 100만 토큰 컨텍스트에 대한 디코딩에서 18.95배의 속도 향상을 보여줬다고 전했다. 특히 KV 캐시 관리 기술은 GPU 메모리 소비를 최대 96%까지 줄였다고 강조했다.

긴 컨텍스트 성능을 평가하는 롱비치(LongBench)나 인피니트벤치(∞Bench) 등에서 첨단 방식보다 우수한 성능을 보였다. 또 디코딩 처리량은 소비자용 GPU인 'RTX 4090'에서 3.2배, 엔터프라이즈급 GPU인 'L40S'에서 7.25배나 증가했다.

딥오토는 홈페이지를 통해 이 기술이 다음 달부터 LG유플러스의 '익시오' 서비스에 적용될 예정이라고 밝혔다. 익시오의 장기 컨텍스트 추론을 가속화, 복잡한 데이터를 더 빠르고 효율적으로 처리할 수 있도록 한다는 것이다.

또 2024년에는 익시오의 기반 모델인 '엑사원'에도 관련 기술 적용을 제안했다고 밝혔다. 이 외에도 삼성종합기술원, 제일기획, 스트라드비젼 등을 파트너사로 확보했으며, 북미에서 비즈니스 네트워크를 구축 중인 것으로 알려졌다.

이 회사는 황성주 대표 등 KAIST와 서울대학교 출신 연구진이 모여 2022년 12월 설립된 회사로, 2023년에는 ‘딥테크 팁스’ 프로그램 선정에 이어 네이버 투자 유치에 성공했다.

임대준 기자 ydj@aitimes.com