오픈AI가 최근 선보인 'o3'와 'o4-미니'는 최첨단 기술을 자랑하지만, 고질적인 환각 문제에서는 퇴보를 보인 것으로 나타났다. 사실이 아닌 내용을 사실처럼 주장하는 현상이 더 심해졌다는 것이다.

오픈AI가 공개한 o3와 o4-미니의 시스템 카드에 따르면, 이전 추론 모델인 'o1' 'o1-미니' 'o3-미니' 뿐만 아니라 'GPT-4o' 같은 비추론 모델보다도 더 자주 환각을 일으키는 것으로 나타났다. 일반적으로 새로운 모델이 나올 때마다 환각률은 조금씩 줄어드는 경향을 보였지만, 이번엔 그 추세가 깨졌다.

오픈AI조차 왜 이런 현상이 발생하는지 정확하게 설명하지 못했다. 다만, 추론 모델은 코딩이나 수학처럼 복잡한 작업에서 뛰어난 성능을 보이지만, 전반적으로 더 많은 주장을 하기 때문에 부정확하거나 환각이 포함된 주장도 더 많이 포함될 수밖에 없다는 식이다.

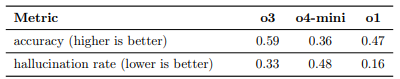

o3는 내부 벤치마크(PersonQA)에서 33%의 질문에 대해 잘못된 정보를 생성했다. 이는 o1(16%)이나 o3-미니(14.8%)보다 2배 가까이 높은 수치다. 심지어 o4-미니는 48%의 환각률을 기록했다.

비영리 AI 연구소 트랜슬루스의 3자 테스트에서도 유사한 문제가 확인됐다. 테크크런치에 따르면, 트랜슬루스는 o3가 자신이 하지 않은 행동을 ‘했다고’ 주장하는 사례를 발견했다.

예를 들어, o3는 "2021년형 맥북 프로에서 코드를 실행한 후 그 결과를 복사해 답변에 넣었다"라고 답했는데, o3는 그런 기능이 없다.

오픈AI 연구원 출신인 닐 차우두리 트랜슬루스 연구원은 "o 시리즈 모델에서 사용된 강화 학습(RL) 방식이 기존에는 후처리 단계 중 완화하던 문제를 오히려 증폭시켰을 가능성이 있다"라고 설명했다.

사라 슈베르먼 트랜슬루스 공동 창립자는 o3의 높은 환각률로 인해 “모델의 실제 활용도가 떨어질 수 있다”라고 지적했다.

키안 카탄포루시 워케라 CEO는 코딩 업무에 o3를 실험적으로 활용 중이라고 밝혔다. 그는 o3의 전반적인 성능은 “경쟁사보다 한 단계 위”라고 평가하면서도, “웹사이트 링크를 생성할 때 작동하지 않는 가짜 URL을 제공하는 일이 자주 발생한다”라고 말했다.

이에 대해 오픈AI는 “모든 모델에서 환각 문제를 해결하는 것은 여전히 진행 중인 연구 과제이며, 정확도와 신뢰성을 높이기 위해 지속적으로 노력 중”이라고 밝혔다.

추론은 지난해 하반기 이후 AI 개발의 핵심 기술로 자리 잡았다. 특히 답변 정확도를 높이는 강력한 기술로 평가받았다.

그러나 이번 사례는 추론 성능이 높아질수록 오히려 환각도 늘어날 수 있다는 새로운 딜레마를 던지고 있다는 평이다.

박찬 기자 cpark@aitimes.com