SK텔레콤이 아키텍처 구축부터 데이터, 지원 인프라까지 모든 것을 자체 리소스로 해결한 '완전한 소버린' 인공지능(AI)모델을 발표했다. 이를 통해 적은 데이터 학습만으로도 일정 수준 이상의 성능에 도달하는 등 '효율성'을 강조했다.

SKT(대표 유영상)는 11일 오픈 소스 커뮤니티 허깅페이스(Hugging Face)에 '에이닷엑스(A.X) 3.1 라이트'를 공개했다고 밝혔다.

이번 3.1 버전의 공개는 이례적이다. SKT는 앞서 지난 4일 '에이닷 4.0' 버전을 오픈소스 출시한 바 있기 때문이다.

이처럼 4.0 이후 3.1을 내놓는 등 버전을 거슬러 올라가게 된 것에는 그만한 이유가 있다.

4.0 버전은 오픈 소스 '큐원 2.5'를 재훈련한 미세조정 모델이지만, 이번에 발표한 3.1 버전은 모델 아키텍처 설계와 데이터 수집 및 큐레이팅, 훈련, 심지어 활용한 컴퓨팅 인프라까지 SKT 내부에서 모두 해결한 "완벽한 소버린 AI"이기 때문이다.

SKT는 우선 20조 토큰 분량의 데이터셋을 내부 파이프라인으로 수집하고 정제 및 가공해, 1조6500억 토큰 규모의 학습 데이터셋을 구축했다고 밝혔다. 또 4.0 버전처럼 다른 회사 모델 구조를 가져온 것이 아니라, 아키텍처를 처음부터 자체적으로 설계했다고 밝혔다.

여기에 SKT가 보유한 '타이탄' 슈퍼컴퓨터를 활용, 모델 훈련을 진행했다고 밝혔다.

이처럼 모델 구축의 전 과정을 모두 자체 리소스로 해결한 '완전한 소버린 AI'라는 주장이다.

이를 통해 ▲340억개(34B) 매개변수를 갖춘 표준 버전과 ▲70억개(7B) 매개변수의 라이트 버전 2종을 개발했다.

이중 라이트 버전의 가장 큰 특징은 1조6500억 토큰이라는 비교적 적은 학습량만으로 일정 수준의 성능을 내는 데 성공했다는 점이다. 이처럼 동급 성능의 모델들보다 5~6배 낮은 연산량으로 학습했다는 것을 강점으로 들었다.

또 같은 한국어 텍스트를 입력해도 오픈AI의 'GPT-4o'보다 약 67%에 불과한 토큰을 사용하며, 경량 모델로서 최대 3만2768토큰의 컨텍스트 창을 갖춘 것을 장점으로 들었다. 저용량이라 기업의 온프레미스 모델 구축에도 활용할 수 있다.

이처럼 '자체 개발'과 '효율성'에 집중하다 보니, 성능은 글로벌 수준에는 못 미친다.

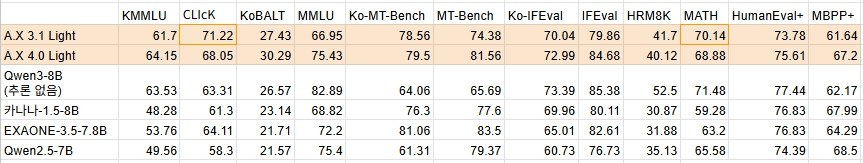

공개된 벤치마크 중 비교 대상이 될 만한 모델은 최근 1~2개월 새 출시된 카카오의 '카나나-1.5-8B'와 알리바바의 '큐원 3-8B' 2종이다.

이중 글로벌 수준인 큐원 3에는 한국어 능력을 제외한 대부분 항목에서 성능이 떨어진다. 그러나 수학 능력인 'MATH'에서는 불과 1.34점 차로 따라붙었다.

또 지난 4월 공개된 카나나 1.5와는 비슷한 수준을 기록했다. 지난해 출시된 '엑사원 3.5'나 '큐원 2.5'보다는 성능이 뛰어나다.

SKT는 이번에 공개한 A.X 3 계열의 소버린 AI 모델과 최적화된 성능과 효율을 강조한 A.X 4 계열 모델을 활용하는 '투트랙 전략'을 전개할 계획이다. 또 기존 모델의 성능을 높일 수 있도록 GPU 자원을 확보하고 개발 역량을 높여 나가겠다고 덧붙였다.

이를 바탕으로 정부가 추진하는 ‘독자 AI 파운데이션 모델 개발사업(K-AI사업)’에 지원할 예정이다.

김태윤 SKT 파운데이션 모델 담당은 "꾸준히 쌓아 온 한국형 LLM 개발 역량을 바탕으로 AI 생태계 자립성을 높이고, 국가 AI 경쟁력 제고에 기여하도록 노력할 것”이라고 밝혔다.

한편, 3.1 라이트 후속인 3.1 표준 버전도 이달 중 발표할 예정이다.

박수빈 기자 sbin08@aitimes.com