사무실 장치들로도 인공지능(AI) 모델을 효율적으로 구동할 수 있는 방법이 공개됐다. 이번 주부터 출하된 엔비디아의 개인용 AI 컴퓨터 'DGX 스파크(Spark)'를 기존 애플의 M3 장치와 조합한 결과다.

미국 스타트업 엑소 랩스(EXO Labs)는 16일(현지시간) 다양한 하드웨어 환경에서 LLM을 효율적으로 구동할 수 있는 오픈 소스 프레임워크 ‘엑소(EXO)’를 선보였다.

이 회사는 지난해 11월에도 비싼 GPU를 사용하는 대신, 4대의 맥 미니 M4와 1대의 맥북 프로 M4 맥스를 연결해 알리바바의 '큐원 2.5 코더-32B'를 실행해 화제가 됐다. 이를 구현하는 소프트웨어 도구가 엑소다.

이처럼 특정 GPU나 가속기에 구애받지 않고, 데스크톱과 노트북, 워크스테이션, 서버, 태블릿, 심지어 휴대폰까지 쉽게 구할 수 있는 장치를 연결해 LLM 추론을 분산 처리하는 것이 핵심 목표다.

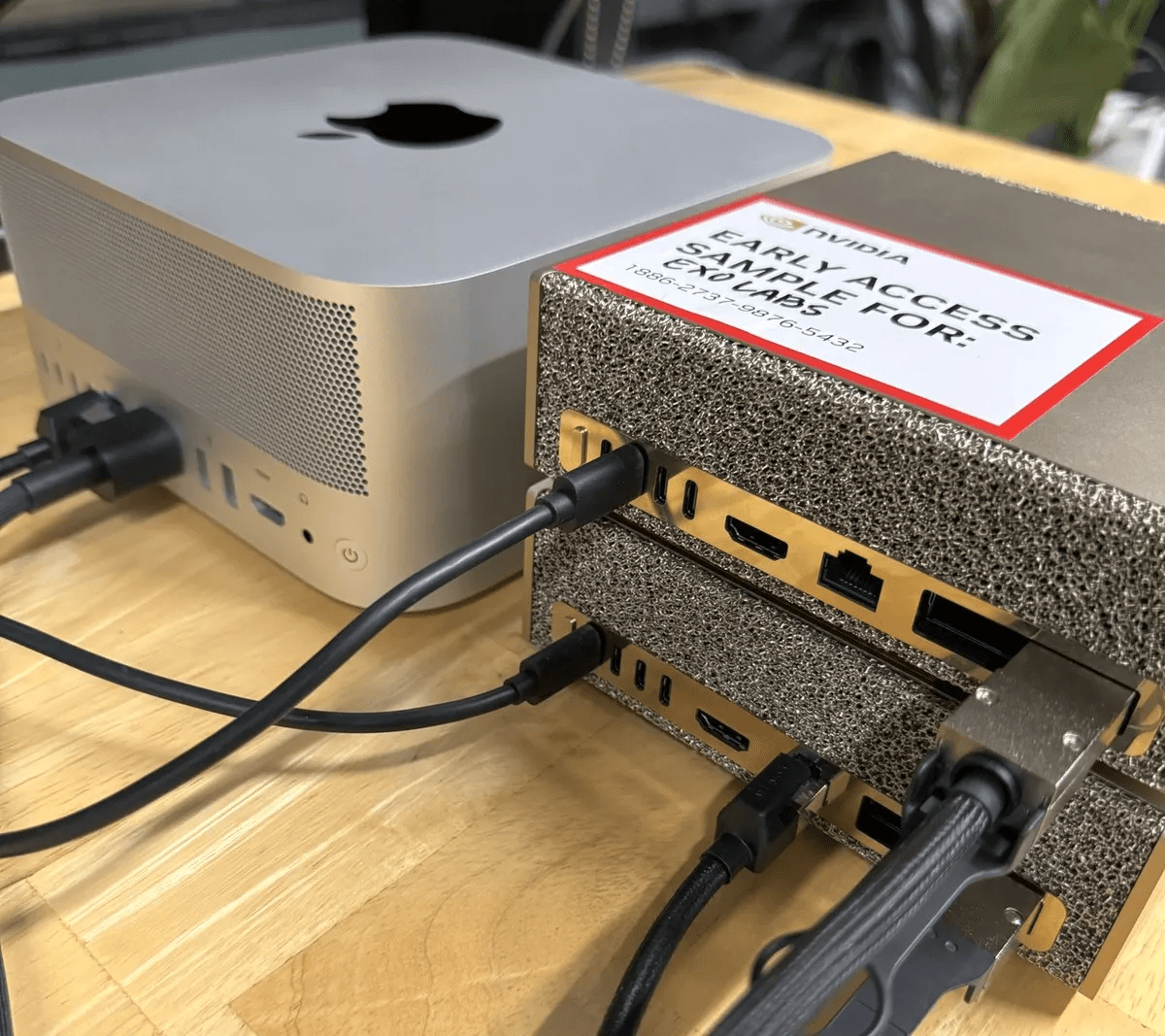

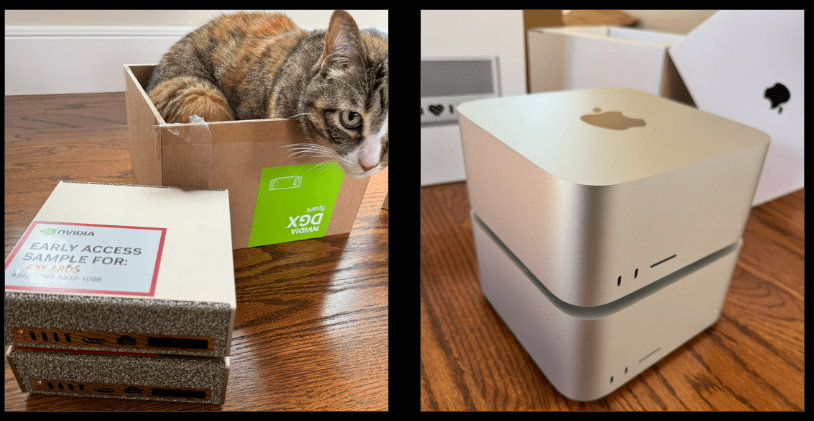

이번에 공개된 데모에서는 엔비디아의 DGX 스파크 시스템 2대와 애플 M3 울트라 탑재 맥 스튜디오(Mac Studio)를 결합해, 각 장치의 장점을 극대화했다. DGX 스파크는 엔비디아가 초기 테스트용으로 이 회사에 전달한 샘플을 사용했다.

DGX 스파크는 강력한 연산 능력을, 맥 스튜디오는 빠른 데이터 이동 속도를 제공한다. EXO 1.0은 두 시스템을 하나의 추론 파이프라인으로 통합해 효율적인 작업 분산을 실현했으며, 초기 테스트에서 놀라운 성능을 보여줬다.

LLM 추론은 크게 두 단계로 나뉜다. 첫번째 '프리필(prefill)' 단계에서는 모델이 사용자 입력을 읽고 처리하는데, 연산 집약적이어서 DGX 스파크의 강력한 GPU가 적합하다.

두번째 '디코드(decode)' 단계에서는 토큰을 하나씩 생성하는 과정이 대역폭 제한에 영향받는데, M3 울트라의 넓은 메모리 버스가 이상적이다.

EXO는 이 두 단계를 장치별로 나누고, 모델 내부 데이터를 레이어 단위로 스트리밍해 시스템 간 대기 없이 동시에 처리하도록 설계했다.

벤치마크 결과, 메타의 '라마-3.1 8B'에서 EXO는 맥 스튜디오를 단독 사용할 때보다 거의 3배 빠른 속도를 기록했다. DGX 스파크의 프리필 속도를 유지하면서 M3 울트라의 빠른 토큰 생성 시간을 확보해, 전체 성능은 약 2.8배 향상됐다.

이번 실험은 비교적 작은 80억 매개변수 모델과 8000토큰 입력 기준으로, 더 큰 모델이나 긴 입력에서는 성능 향상이 더 커질 것으로 기대했다.

이런 ‘분리형 추론(disaggregated inference)’은 새로운 개념은 아니지만, EXO는 이를 실용적으로 구현한 점이 주목된다. 단일 대형 가속기를 구매하는 대신, 기존 하드웨어를 효율적으로 활용해 AI 성능을 극대화할 수 있다는 가능성을 보여준다.

엔비디아도 앞으로 출시할 루빈(Rubin) CPX 플랫폼에서 비슷한 원리를 적용할 계획이다. 프리필 단계는 고집적도의 루빈 CPX 프로세서가, 디코드 단계는 대용량 HBM3e 메모리와 표준 루빈 칩이 담당하는 식이다.

EXO는 아직 실험 단계로, 오픈 소스 버전(0.0.15-alpha)은 2025년 3월 기준이다. 정식 1.0 버전은 아직 공개되지 않았다.

소비자용 플러그 앤 플레이 소프트웨어는 아니지만, 연구용 도구로서 혼합 하드웨어를 활용한 분리형 추론의 가능성을 입증하고 있다는 평이다.

박찬 기자 cpark@aitimes.com