데이터센터 중심의 인공지능(AI) 기술이 엣지단으로 퍼지면서 점점 다양해지는 추세다. 엣지 AI는 스마트폰, 자율주행차, 지능형 CCTV, 빌딩 내 자동감지 시스템, 공장 자동화 솔루션 등 다양한 용도로 사용된다.

물론 용도나 서버와의 거리 및 한계 전력량과 가성비 등 요소에 따라 서로 다른 스펙이 요구된다.

EE타임스는 20일(현지시간) 이같은 사실에 주목해 기존 메모리 반도체 기술만으로는 엣지 AI 애플리케이션을 제대로 구동할 수 없고, 차세대 메모리 기술을 적재적소에 사용할 필요가 있다고 분석했다.

엣지 AI 범위가 넓어 용도가 천차만별이라는 얘기다. 실제로 엣지 AI를 넓게 해석하면, 클라우드 데이터센터를 제외한 외부의 모든 AI 지원 시스템이라고 말할 수 있다. 가까이는 클라우드에서 바로 연결되는 기업 데이터센터나 사내 서버부터, 멀리는 자율주행을 위한 컴퓨터 비전, 스마트폰 카메라 센서까지 다양한 영역을 포함한다.

애플리케이션별 수요는 많고 다양하며 크기, 전력 소비량, 저전압 작동, 신뢰성, 내열성 등 다양한 요소를 고려해야 한다.

대표적으로 데이터센터에서는 GDDR, HBM, 옵테인이 인기를 끌고 있으며, 엔드포인트 애플리케이션에는 LPDDR과 온칩 SRAM이 경쟁한다. 또한 MRAM과 ReRAM과 같은 차세대 메모리는 새로운 AI 애플리케이션을 가능케 한다.

◇'고성능 메모리'가 필요한 엣지 데이터 센터

엣지 데이터 센터는 엣지 AI에서 중요한 시장 중 하나다. 클라우드 데이터센터로 보내기에는 민감한 개인정보를 처리하기 위해 병원이나 연구소, 금융, 방산 시설 등이 대표적인 엣지 데이터 센터다.

이 시스템들을 구동하기 위해서는 더 빠른 D램(DRAM)과 SSD보다 훨씬 빠른 비휘발성메모리(NVM)가 필요하다.

스마트모듈러테크놀로지 메모리 제품 설계·개발자인 페콘 굽타는 "AI 알고리즘이 개발되고 훈련되고 있는 애플리케이션에서 고속의 메인 메모리에 DRAM처럼 짧은 대기 시간의 메모리가 필요하다"고 설명했다.

이에 페콘 굽타는 DRAM에서는 최근 서버에서 주로 사용하는 RDIMM(Registered Dual In-line Memory Module), LRDIMM(Load Reduced DIMM)이, 스토리지 일부 영역에서는 SSD보다 빠른 NVDIMM(비휘발성 DIMM)이 필요하다고 덧붙였다.

그는 "최근 추세는 엣지 서버에서 복잡한 알고리즘을 더 잘 실행할 수 있도록 만드는 것"이라며, "서비스 제공업체들은 RDIMM, LRDIMM, NVDIMM과 같은 가용성이 높은 영구 메모리를 사용해 이런 엣지 서버에 더 많은 메모리와 처리 능력을 추가하고 있다"고 강조했다.

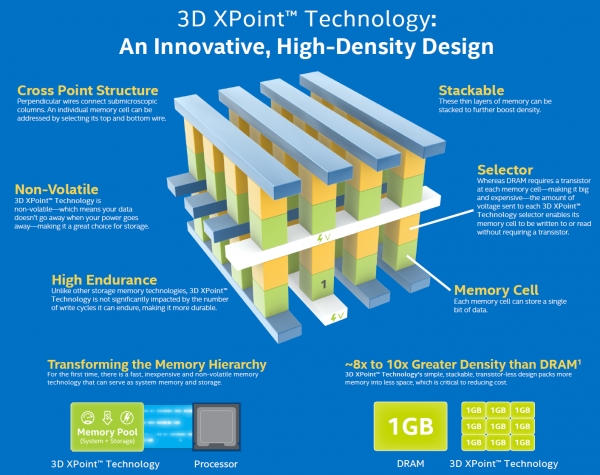

굽타는 3D X포인트 기술을 이용한 인텔 옵테인 메모리를 이에 적합한 솔루션 중 하나로 꼽았다.

인텔은 지난해 4월 옵테인 DC(데이터센터) 퍼시스턴트 메모리를 공개했다. 제품은 메모리 모듈 형태에 서버의 DIMM 슬롯을 장착했다. 이를 통해 스토리지 특징을 가진 RAM처럼 동작한다.

인텔은 이를 통해 데이터센터에서 처리해야 할 데이터가 늘어날수록 생기는 병목 현상을 해결할 수 있다고 밝혔다.

EE타임스는 최근 옵테인이 경쟁력 있는 가격으로 DRAM과 낸드 플래시를 연결하는 매력적인 대안을 떠오르고 있다고 전했다.

고성능의 엣지 데이터 센터와 엣지 서버 애플리케이션에서는 클라우드와 비슷하게 GPU와 같은 AI 컴퓨팅 가속기가 힘을 얻고 있다.

이를 위한 메모리로 업체들은 GDDR(Graphics DDR) 기술과 HBM을 주로 사용한다.

GDDR은 'GDDR SDRAM'을 말하며, GPU용으로 설계된 일종의 DRAM이다. DDR로 널리 알려진 스마트폰이나 컴퓨터에 쓰이는 DDR DRAM보다 높은 메모리 대역폭을 자랑한다.

HBM(High Bandwidth Memory)은 고대역폭메모리로 GDDR보다 더 높은 메모리폭을 달성하기 위해 설계됐다. 메모리 다이를 적층해 대역폭을 크게 높이는 기술을 사용했다.

둘 다 GPU 기반의 AI 애플리케이션에서 요구되는 극히 높은 메모리 대역폭을 구현한다.

EE타임스는 가장 까다로운 AI 모델 교육을 위해 사용되는 HBM2E는 3.6Gbps, 460GB/s의 메모리 대역폭을 제공한다고 설명했다. 상용화된 기기의 전력요구량 중 가장 높은 성능을 제공하는 메모리 중 하나다.

엔비디아의 모든 데이터센터 제품은 HBM을 탑재했다.

프랭크 페로 람부스 IP코어 제품 마케팅 담당 상무는 "GDDR6는 엣지의 AI 추론 애플리케이션에도 사용된다"며 "GDDR6가 에지 AI 추론 시스템의 속도, 비용 및 전력 요건을 충족할 수 있다"고 말했다.

GDDR6는 18Gbps를 전달할 수 있으며 72GB/s를 제공한다. GDDR6 D램 4개를 탑재하면 300GB/s에 가까운 메모리 대역폭을 제공한다.

페로는 "GDDR6는 AI 추론과 ADAS 응용에 사용된다"며 "메모리 대역폭 수요가 증가함에 따라 GDDR6를 사용하는 설계가 증가할 것"이라고 덧붙였다. 다른 DDR DRAM과 높은 대역폭 격차로 엣지 AI에서의 GDDR6 수요가 늘어날 것이라는 설명이다.

한편 GDDR6는 GPU용으로 설계됐지만 다른 가속기에도 사용할 수 있는 것으로 나타났다. 최근에는 저가의 훈련용으로 제작된 FPGA 기반의 AI 가속기에 GDDR을 결합해 속도를 높인 경우도 있다.

페로는 에지 AI 애플리케이션에서는 HBM과 GDDR 모두 중용되겠지만, 가격과 성능, AI 추론 능력 등을 비교할 때 GDDR6가 제일 적합한 제품이라고 전했다.

HBM은 그래프코어의 IPU와 같은 고성능 데이터 센터용 AI칩에 사용된다. 높은 성능을 제공하지만 일부 애플리케이션에서는 비용 부담이 있을 수 있다.

◇저전력·고효율이 필요한 추론을 위한 엣지 AI

데이터센터 외부의 엣지 AI 시스템은 대체적으로는 추론에 초점을 맞춘다. 여기에는 비용과 전력의 한계가 있다. 고비용·고전력·고사양의 GDDR이나 HBM을 사용하기에는 적합하지가 않다.

추론을 계산할 때 일부 AI 가속기는 임베디드(내장형) 메모리를 사용한다. 작은 메모리를 효율적으로 사용해 AI 추론을 실행한다.

가전제품의 음성제어를 위한 싱티어트의 AI 솔루션이나, 자이어팔콘의 스마트폰용 카메라 추론 장치가 대표적이다.

저전력이나 초저전력 시스템에는 그것을 위한 ASIC(주문형반도체)를 사용한다. ASIC은 용도에 따라 다양한 메모리 조합을 사용한다.

단일 대용량 SRAM을 장착하면 성능은 올라가지만 성능 병목현상이 발생할 수 있다. 저렴한 오프칩 DRAM은 많은 전력을 사용한다. 분산형 로컬 SRAM은 빠르고 전력효율도 높지만, 단일 SRAM만큼의 성능을 발휘하기는 어렵다.

이에 제프 테이트 플렉스 로직스 CEO는 분산형 SRAM, 벌크 SRAM, 오프칩 DRAM 간에 적절한 균형을 찾으려면 다양한 성능 시뮬레이션이 필요하다고 말했다. 다이 크기, 패키지 비용, 사용된 DRAM 수량을 적절히 계산해 가격당 추론 처리량을 최대화해야 한다는 것이다.

플렉스 로직스의 AI칩은 대기 시간이 짧은 스트리밍 영상을 분석하는 등 실시간 작동이 필요한 에지 AI 추론 애플리케이션에 활용될 예정이라고 말했다. ADAS 시스템, 보안 영상 분석, 의료 영상과 품질 보증, 검사 애플리케이션이 포함된다.

◇ 미래를 위한 MRAM·ReRAM, 차세대 메모리 장치

최근에는 MRAM, ReRAM 등 차세대 메모리가 AI 애플리케이션의 미래로 떠오르고 있다.

최근 자이어팔콘은 MRAM을 사용해 AI 성능을 높이는 기술을 적용하고 있다. 이를 통해 최첨단 애플리케이션의 컴퓨팅과 전력 요구량을 획기적으로 줄일 수 있다.

현재 개발된 MRAM은 정밀도가 떨어진다는 특성이 있지만, 이진 신경망(BNN)에서는 안정적으로 기능하도록 만들 수 있다.

스핀메모리의 앤디 워커 제품 부사장은 "이중 신경망은 숫자가 -1이나 +1일 확신이 줄어들어도 안정적으로 작동할 수 있다는 점에서 독특하다"며 잘못 쓰인 메모리 비트에도 신경망은 작동할 수 있다고 설명했다.

EE타임스는 MRAM 셀에는 BNN의 이진 상태와 일치하는 두 개의 상태가 있어 BNN에 적합하다고 설명했다.

워커는 "엣지 AI의 경우 고성능 정확도가 요구되지는 않지만 에너지 효율과 메모리 내구성의 개선이 매우 중요하다"며 게다가 MRAM의 비휘발성은 전력이 없는 상태에서도 메모리를 저장할 수 있는 장점이 있다고 강조했다.

단순히 메모리뿐만 아니라 낸드 플래시를 대체할 수도 있다는 것이다. SRAM과 임베디드 플래시 메모리를 통합할 수 있어 다이의 면적을 줄이고 SRAM의 방전과 같은 문제를 해결할 수 있다.

또 다른 에지 AI 애플리케이션용 메모리로는 ReRAM(Resistive RAM)이 떠오르고 있다. 최근 ReRAM을 사용해 컴퓨터의 뛰어난 딥러닝기반의 훈련 능력에 사람의 두뇌와 같은 추론 능력을 더하는 기술이 개발됐다.

위비트 나노는 실리콘 옥사이드(SiOx) 기반의 ReRAM 기술을 기반으로 AI 신경망용 ReRAM을 개발했다. 지난달 이탈리아 밀란 폴리텍 대학의 연구원들이 위비트 나노의 ReRAM을 사용해 AI 자기학습 시연에 성공했다.

밀란 대학은 위비트 나노의 ReRAM을 이용해 ▲딥러닝에서 선형 연산을 활용해 시각 이미지를 분석하는 인공 신경망인 CNN(컨볼루션 신경망)의 효율성과 ▲인간의 뇌를 모방한 SNN(스파이킹 신경망)의 특징을 결합했다.

연구팀은 위비트 나노의 ReRAM을 사용한 추론 하드웨어로 CNN의 효율성과 SNN의 변화 가능성을 통합했다.

이전에 취득한 정보로 훈련된 과제를 잊지 않으며, 새로운 정보를 학습할 수 있도록 하는 새로운 하드웨어 설계를 개발했다는 것이다.

조건이 변함에 따라 진화할 수 있는 성질은 뉴로모픽 컴퓨팅에서 유용하다.

현재의 신경망 네트워크는 훈련받은 일을 잊지 않고서는 새로운 일을 배울 수 없다. 하지만 인간의 뇌는 이것을 쉽게 수행한다.

AI에서는 알고리즘이 데이터에서 자체 패턴을 찾아 라벨이 없는 데이터세트에 대해 추론을 수행하는 '무감독 학습'이라고 말한다. 궁극적으로 새로운 작업을 현장에서 학습하고 주변 환경에 적응할 수 있는 ReRAM 지원 에지 AI 시스템을 만들 수 있다는 것이다.