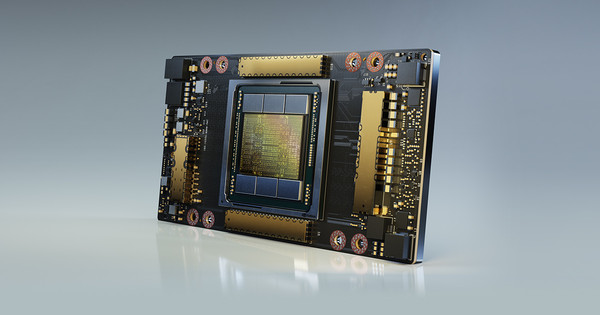

엔비디아가 인공지능(AI) 슈퍼컴퓨팅 플랫폼을 구동하는 새로운 A100 80GB GPU를 공개했다. A100 80GB GPU는 이전 모델 대비 2배 높아진 메모리를 지원해 높은 속도를 제공한다.

80GB 메모리는 HBM2e 기술을 적용했다. 기존 A100 40GB GPU의 고대역폭 메모리를 두 배 지원하며 초당 2TB 이상의 메모리 대역폭을 제공한다.

브라이언 카탄자로(Bryan Catanzaro) 엔비디아 응용 딥 러닝 리서치 부문 부사장은 “고성능컴퓨팅(HPC)과 AI 분야에서 최상의 연구 결과를 내기 위해서는 방대한 모델을 구축해야 하는데, 이는 어느때보다 더 높은 메모리 용량과 대역폭을 요구하고 있다"며 "A100 80GB GPU는 불과 6개월 전에 출시된 이전 모델 보다 2배 높은 메모리를 제공한다"고 말했다.

A100 80GB GPU는 발표된 엔비디아 DGX A100과 DGX 스테이션 A100 시스템에서 이용할 수 있다. 각 제품은 이번 분기 출시된다.

엔비디아는 "AI 훈련에서 DLRM과 같은 추천 시스템 모델에는 수십억명의 사용자와 수십억개의 제품을 나타내는 방대한 테이블을 포함하고 있다"며 "A100 80GB GPU는 최대 3배 빠른 속도를 제공하므로 기업은 이러한 유형의 모델을 신속하게 재훈련해 매우 정확한 추천 서비스를 제공할 수 있다"고 전했다.

확장된 메모리를 바탕으로 새로운 GPU는 GPT-2 자연어 처리 모델과 같이 단일 HGX 탑재 서버에서 더 많은 매개변수를 가진 방대한 모델을 훈련할 수 있다. 이를 통해 많은 시간이 소요되고, 여러 노드에서 느리게 실행될 수 있는 데이터 혹은 모델을 위한 병렬처리 아키텍처의 필요성을 없앤다.

엔비디아는 기상 예측과 양자 화학과 같은 분야의 과학 애플리케이션을 빠르게 가속화할 수 있다고 설명했다.

마쓰오카 사토시(Matsuoka Satoshi) 일본 이화학연구소(RIKEN) 컴퓨터 사이언스 센터 이사는 “빠르고 충분한 메모리 대역폭과 용량은 슈퍼컴퓨팅 애플리케이션의 높은 성능을 구현하는 데 필수적"이라고 밝혔다.