지난해 6월 크로아티아 체스 선수 '안토니오 라딕'이 운영하는 구독자 100만 명이 넘는 체스 유튜브 계정이 콘텐츠의 유해성과 위험성을 이유로 차단됐다. 인공지능(AI)이 소셜 미디어상 체스 이야기를 인종 차별주의적인 대화로 오해한 것.

사건의 발단은 헤이트 스피치(hate-speech)를 감지하는 AI 기반 소프트웨어가 ‘흑색 말’과 ‘백색 말’ 등 체스 말 색깔에 대한 대화를 오인한 데에서 비롯됐다. 미국 카네기멜론대 연구진은 최근 안토니오 라딕의 체스 유튜브 채널이 차단된 것과 관련해 AI 알고리즘의 결함을 조사, 체스에 대한 일부 대화 내용이 혼동을 불러온 것으로 추정했다.

지난 18일(현지시간) IT 전문매체 테크 익스플로어 등 외신에 따르면 연구진은 안토니오 라딕과 그랜드마스터(국제 체스 연맹에서 부여하는 체스 선수의 최상위 칭호)인 히카루 나카무라의 대화에서 체스 말을 가리키는 ‘흑 대 백(black vs. white)’ 관련 부분이 문제가 됐을 가능성이 있다고 전했다. 인종 차별적 언어를 자동 감지하는 AI 소프트웨어가 이 같은 ‘흑’과 ‘백’을 언급한 발언을 오해해 유해 콘텐츠로 잘못 인식‧작동됐을 수 있다는 설명이다.

카네기멜론대 언어기술연구소(LTI)의 아시크 쿠다바크슈 과학자는 유튜브가 이에 대한 명확한 설명 없이 24시간 만에 채널을 복구했다고 말했다. 그는 ”유튜브가 어떤 툴을 사용하는지 정확히 알 수는 없으나, 만약 인종 차별적 언어를 감지하기 위해 AI 기술을 이용한다면 이 같은 사고가 발생할 수 있다“고 전했다. 이번 일은 안토니오 라딕처럼 유명인에게 공개적으로 일어나 눈길을 끌었지만, 실제 일반인들도 이 같은 일을 비일비재하게 겪었을 수 있다는 것이다.

연구진은 이러한 가설이 가능한지 알아보기 위해 두 가지 최첨단 음성 분류기(speech classifier)를 테스트했다. 해당 음성 분류기는 헤이트 스피치 감지가 가능한 일종의 AI 소프트웨어다. 연구진은 인기 있는 체스 유튜브 채널 5곳에서 수집된 68만 개 이상의 코멘트를 대상으로 분류기를 사용했다. 적어도 분류기 1개가 헤이트 스피치로 표시한 약 1000개의 코멘트를 무작위로 추출, 표본 조사를 했다.

연구진이 해당 코멘트들을 수작업으로 검토한 결과 82%에 달하는 코멘트 대다수가 헤이트 스피치를 포함하지 않는 것으로 나타났다. ‘흑(black)’이나 ‘백(white)’, ‘공격(attack)’, ‘위협(threat)’ 등과 같은 단어들이 분류기에서 걸린 것으로 보인다는 게 연구진의 설명이다. 다른 기계학습(ML) 기반 AI 프로그램들과 마찬가지로 이러한 분류기는 다량의 데이터를 토대로 훈련되며, 정확도는 사용된 데이터 세트에 따라 달라질 수 있다.

예를 들어 사진 훈련 데이터 세트를 기반으로 ‘게으른 개’와 ‘활동적인 개’를 식별한다고 하자. 활동적인 개의 사진의 경우에는 넓게 펼쳐진 잔디를 배경으로 개가 멀리서 달리고 있는 모습이 많았다. 테스트 결과 AI 프로그램은 종종 개가 사진에 없는데도 잔디가 많이 보이는 사진을 활동적인 개의 사진으로 식별하는 것이다.

이번 체스 사건의 경우도 마찬가지다. 연구진은 많은 훈련 데이터 세트가 체스 대화 예시를 거의 포함하고 있지 않기 때문에 분류가 잘못될 가능성이 있다고 지적한다. 연구 논문은 이달 국제인공지능학회 ‘AAAI’ 연례회의에서 발표됐다.

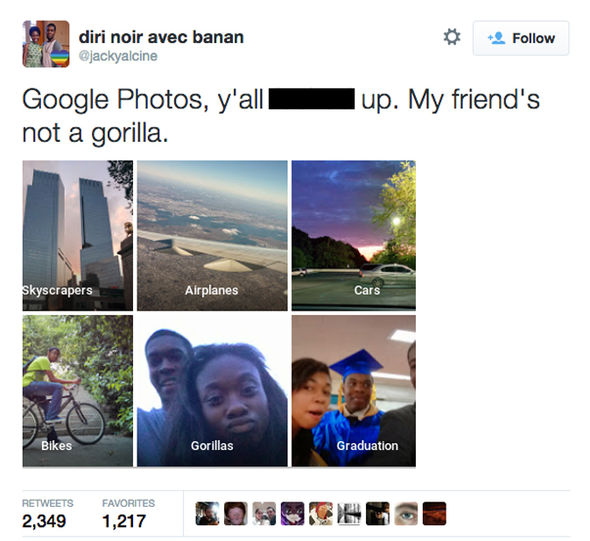

한편 AI 알고리즘의 결함과 문제점을 지적하는 목소리는 꾸준히 제기돼왔다. 특히 AI 알고리즘의 편향성 쟁점이 화두에 오른 것은 한두 번이 아니다. 지난 2015년에도 구글 포토의 이미지 인식 알고리즘도 흑인 두 명을 ‘고릴라’로 분류‧표시해 논란이 됐다. 구글은 해당 오류를 수정하지 못한 채 결국 알고리즘에서 문제의 키워드를 삭제 조치한 바 있다.

AI타임스 윤영주 기자 yyj0511@aitimes.com

[관련기사] 미 프린스턴대, 얼굴인식AI 인종·성차별 줄이는 도구 개발... 데이터셋 대폭 수정하는 '리바이스'