주어진 이미지에 대해 설명하거나 질문에 답변하는 새로운 인공지능(AI) 언어 이미지 모델이 나왔다.

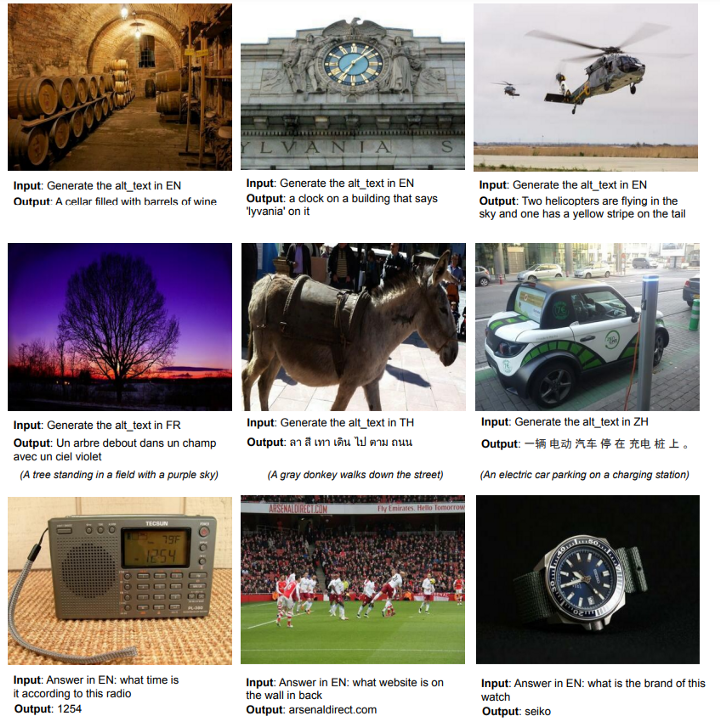

구글은 100개 이상의 언어로 다양한 작업을 수행하도록 훈련한 언어 이미지 모델 ‘팔리(PaLI)’를 최근 블로그에 공개했다. PaLI는 시각을 활용한 질의 응답, 이미지 캡션, 객체 감지, 이미지 분류, 광학 문자 인식(OCR), 텍스트 추론 등 작업을 통합 수행한다.

이미지 캡션은 이미지와 텍스트를 입력하면 이미지를 분석해 텍스트 설명을 제공한다. 시각 질의 응답(Visual Question Answering)은 이미지에 대한 질문에 답변을 제공하는 기능이다. 시각적 상식 이해는 이미지로 부터 상식 정보와 이해를 추론한다. OCR은 이미지에 포함된 텍스트를 컴퓨터가 이해할 수 있는 텍스트로 변환할 수 있다.

PaLI 모델 아키텍처는 입력 텍스트를 처리하는 트랜스포머 인코더와 출력 텍스트를 처리하는 예측 결과가 다시 입력으로 들어가는 자동회귀 트랜스포머 디코더로 구성된다.

이미지를 처리하기 위해 트랜스포머 인코더에는 비전 트랜스포머(ViT)로 처리한 이미지를 나타내는 '시각적 단어'도 입력할 수 있다. ViT는 이미지를 고정된 크기의 패치로 나눠서 각 패치를 단어처럼 트랜스포머에 입력, '시각적 단어'를 사용해 이미지 클래스를 예측한다.

PaLI 모델은 총 170억개 매개변수를 제공한다. 언어 부분을 위한 130억개와 시각적 부분을 위한 40억개로 나뉜다.

언어 이미지 모델의 사전 훈련을 위해 공개적으로 사용할 수 있는 이미지와 텍스트로 구성된 109가지의 다국어 언어 이미지 데이터세트인 WebLI를 구축하고, 100억 개의 이미지와 120억개의 이미지를 설명하는 대체 텍스트를 수집했다.

또 클라우드 비전(Cloud Vision) API를 사용해 이미지에 OCR을 수행했다. 웹 텍스트 주석과 함께 290 개의 이미지-OCR 쌍을 생성했다.

구글은 PaLI가 다국어 시각적 캡션과 시각적 질문 답변 모두에서 경쟁 모델보다 더 나은 결과를 얻었다고 밝혔다.

또 시각, 언어 및 시각-언어 작업 전반에 걸쳐 향상된 성능을 보여준다고 설명했다. PaLI 모델의 시각적 및 언어적 부분과 둘 사이의 상호 작용 모두에서 규모가 중요하다. 특히 여러 언어로 비전 및 언어 작업을 수행하려면 실제로 대규모 모델과 데이터가 필요하다.

모델 확장성과 관련해 이미지 및 언어 모델 구성 요소를 함께 확장해 최적의 성능을 얻을 수 있으며, 더 적은 수의 매개 변수가 필요한 시각적 구성 요소를 확장하는 것이 특히 중요하다.

박찬 위원 cpark@aitimes.com