MIT-IBM왓슨 AI 연구소가 음향 정보를 사용해 공간 환경을 시각화하고 특정 위치에서 들리는 소리를 시뮬레이션하는 AI 모델을 개발했다고 MIT뉴스가 1일(현지시간) 보도했다.

소리는 발생 위치와 청취자 위치는 물론 공간 사이의 물체나 벽의 재질, 창문이나 출입구 등의 영향을 받기 때문에, 사람도 들리는 소리를 통해 공간의 구조나 환경을 어느 정도 예측할 수 있다.

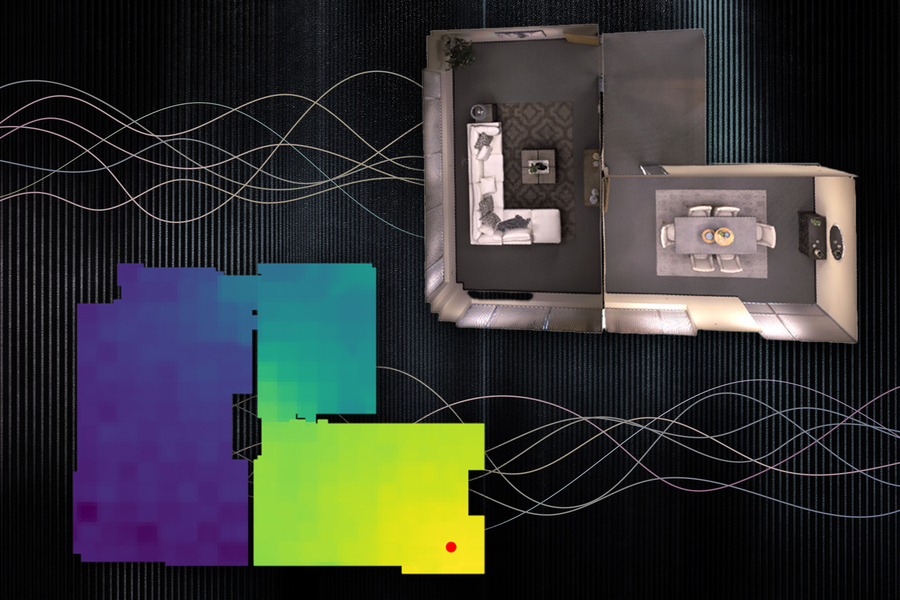

연구소가 개발한 기술은 인공지능(AI) 모델이 녹음된 소리를 통해 공간의 3D 구조를 학습, 소리로 공간 구조를 시각적 렌더링하는 방식이다. 즉 소리만 듣고도 공간을 3D로 그려내는 기술이다.

게다가 청취자가 임의 지점으로 이동하면 소리가 어떻게 들리는지까지 예측한다. 이를 위해 신경 음향장(NAF)이라는 모델을 사용해 청취자의 위치 이동에 따른 소리 변화는 물론 주변 환경의 변화에 따른 소리 영향까지 합쳐, 실제와 흡사한 결과를 얻어냈다.

공간 음향 정보 모델링(영상=MIT)

연구진은 이 기술이 메타버스와 같은 가상 및 증강 현실에서의 응용되는 것은 물론 현실 세계에도 도움이 될 수 있다고 말했다. 두이런 수석연구원은 "예를 들어 수중 탐사 로봇은 주변 환경에서 소리의 음향 특성을 모델링함으로써 시각만으로 할 수 있는 것보다 더 멀리 있는 것을 감지할 수 있다"고 말했다.

또 건물이나 도시와 같이 더 복잡한 공간에 적용할 수 있도록 모델을 계속 개선할 계획이다.

박찬 위원 cpark@aitimes.com

관련기사