인공지능(AI) 엔지니어링 컨소시엄인 ML커먼스가 최근 데이터센터를 구성하는 하드웨어 인프라의 성능을 측정하는 'ML퍼프(MLPerf) 추론' 결과, 엔비디아 제품이 전반적으로 우수한 성능을 보인 가운데 테스트에 참여한 다른 기업 제품도 대부분 성능이 크게 향상된 것으로 나타났다.

ML퍼프는 ML커먼스가 마련한 벤치마크 테스트 기준이다. ML퍼프 추론은 참여기 업들이 이 기준을 토대로 자사 제품을 테스트하고, 그 결과를 ML커먼스에 제출하는 형태로 이루어진다.

다만 테스트는 참여기업이 원하는 항목만 진행하기 때문에 그 자체로만 평가할 수 있고, 전체 비교 분석은 불가능하다.

ML커먼스는 5일(현지시간) 블로그에 이같은 내용의 'ML퍼프 추론 3.0' 벤치마크 결과를 발표했다.

ML퍼프 추론 3.0에서는 약 6700개의 추론 성능 결과와 약 2400개의 전력 효율성 측정 결과를 제공한다. 이번 벤치마크 결과, 일부 벤치마크 테스트에서 50% 이상의 전력 효율성 증가와 60% 이상의 성능 향상을 기록한 것으로 나타났다.

이번 테스트에는 알리바바, 아수스, MS, 씨튜닝, 데시, 델, 기가바이트, H3C, HPE, 인스퍼, 인텔, 크라이, 레노버, 모페트, 네트릭스, 뉴칩스, 뉴럴 매직, 엔비디아, 퀄컴, 퀀타 클라우드, 리벨리온, 시마, 슈퍼마이크로, VM웨어, 엑스퓨전 등이 참여했다.

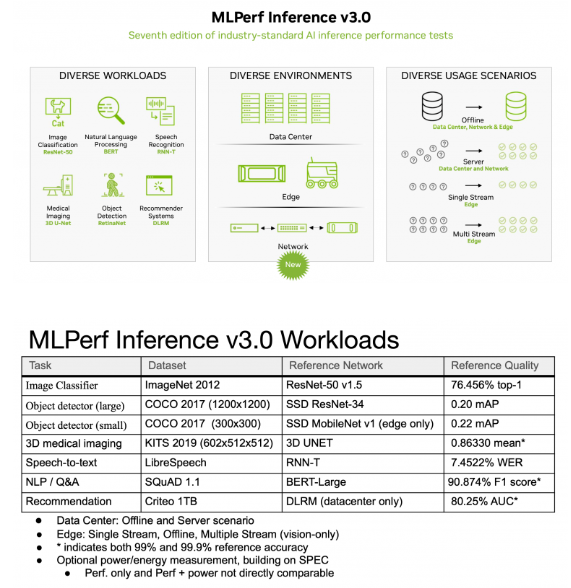

ML퍼프 추론 3.0 테스트는 이미지 분류, 객체 감지, 추천, 음성 인식, 자연어처리 및 3D 의료 이미지로 구성된 옵션에 대해 벤치마크를 실행할 수 있다. 각 옵션에 지정된 데이터 세트와 AI 모델을 사용해 테스트 참가자의 데이터 센터 및 에지 시스템의 추론 성능을 측정한다.

이번 벤치마크 테스트의 가장 큰 추세는 전반적으로 놀라운 성능 향상을 이뤘다는 점이다.

예를 들어 인텔의 새로운 가속기 AMX는 GPU 기반 시스템만큼 빠르지는 않았지만 이전 세대 제품에 비해서는 개선된 것으로 나타났다.

또 퀄컴은 '클라우드 AI 100' 칩 18개를 탑재한 데이터센터 서버 플랫폼이 매우 우수한 오프라인 성능과 전력효율성을 기록했다고 제출했다. 퀄컴은 소프트웨어 최적화를 통해 최초의 ML퍼프 1.0 테스트 이후 최대 86%의 성능 향상과 최대 52%의 전력 효율성을 개선했다고 자평했다.

VM웨어는 델 및 엔비디아와 협력해 엔비디아 호퍼 시스템을 가상화한 결과, 128개 논리 CPU 코어 중 16개 CPU 코어만 사용하면서 베어 메탈 성능의 205% 중 94%를 달성했다고 보고했다. 나머지 112개 CPU 코어는 추론 워크로드를 실행하는 머신의 성능에 영향을 주지 않고 가상화를 통해 다른 워크로드에 사용할 수 있었다.

한편 현재 AI 추론의 가장 큰 추세는 챗GPT와 같은 LLM의 대규모 추론이었다. GPT급 모델은 ML퍼프 벤치마크 제품군에 포함되지 않았지만 2분기 훈련 벤치마크에는 포함될 예정이다.

박찬 위원 cpark@aitimes.com