엔비디아가 미국 코넬대학교와 공동으로 비디오 생성 인공지능(AI) 모델인 '비디오LDM(Video Latent Diffusion Model)'을 개발해 공개했다고 뉴아틀라스는 23일(현지시간) 보도했다.

엔비디아가 이번에 개발한 '비디오LDM'은 텍스트로 입력한 설명에 따라 최대 2048x1280픽셀 해상도의 동영상을 초당 24 프레임 속도로 최대 4.7초까지 생성할 수 있는 비디오 생성 AI다.

'스테이블 디퓨전'을 기반으로 텍스트에서 이미지를 생성하도록 사전 훈련한 잠재 확산 모델(LDM)을 수천개의 비디오로 미세조정해 이미지를 애니메이션화하는 방법을 학습했다.

이를 통해 특정 기간 동안 시간에 따라 이미지의 각 부분에서 예상되는 변경 사항을 예측하는 작업을 수행한다. 전체 프레임 시퀀스 중에서 일련의 키프레임을 생성한 다음 다른 LDM을 사용해 키프레임 사이에 프레임을 채워 전체 시퀀스를 완성한다.

비디오LDM에는 최대 41억 개의 매개변수가 있고, 그중 27억 개만이 비디오 미세조정에 사용됐다. 이것은 최근 생성 AI 모델들의 규모에 비하면 상당히 작은 수준이지만 효율적인 LDM 접근 방식을 통해 시간적으로 일관성있는 고품질의 다양한 비디오를 생성할 수 있었다.

특정 이미지를 사후 학습시켜 개인화된 비디오 생성하는데 비디오LDM을 활용할 수 있다. 예를 들어 고양이 이미지를 사용해 잔디에서 노는 고양이의 비디오를 생성하도록 지시하면 원본 이미지와 같은 고양이가 등장하는 비디오가 생성된다.

이 모델의 시간 내 컨볼루션 합성(Convolutional-in-time synthesis) 기능을 활용해 단위시간 동안 생성되는 프레임의 샘플링을 늘리면 화질은 약간 떨어지지만 초당 24 프레임에서 7.3초 길이의 긴 비디오를 생성할 수도 있다.

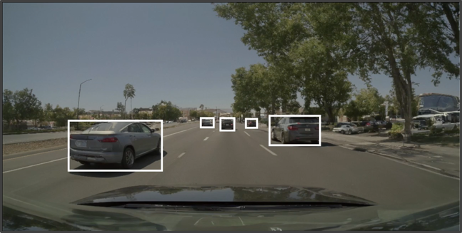

특히 이 방식을 적용하면 1024x512 픽셀 해상도로 최대 5분 동안 지속되는 운전 장면을 제작할 수 있다. 경계 상자를 기반으로 생성된 초기 프레임을 사용해 다음 비디오를 만들어 특정 운전 시나리오를 시뮬레이션할 수 있다.

또한 이 모델은 동일한 초기 프레임에서 다양한 시나리오의 비디오를 생성할 수 있다.

비디오LDM은 2023년 6월 18일부터 캐나다 밴쿠버에서 열리는 컴퓨터 비전 및 패턴 인식에 관한 IEEE 컨퍼런스에서 발표될 예정이다. 어디까지나 연구 단계의 프로젝트이기 때문에, 이것이 엔비디아의 서비스나 제품에 어떻게 전개될지는 아직 알 수 없다.

박찬 위원 cpark@aitimes.com