미국 연구진이 인공지능(AI)을 활용해 음악을 들을 때 나타나는 뇌파 신호를 분석해 음악을 재구성하는 데 성공했다. 뇌졸중, 루게릭병 등 신경 질환 환자들이 뇌에서 생각하는 것을 언어로 나타내는 데 활용할 수 있을 뿐 아니라, 강세나 억양과 같은 음악적 요소를 가미한 의사소통을 가능케 하는 기술로 발전할 수 있다는 평가다.

가디언은 15일(현지시간) 미국 UC버클리 연구진이 국제 학술지 ‘플로스 바이올로지’를 통해 음악을 듣는 간질 환자의 뇌파를 분석해 음악을 재구성하는 기술을 발표했다고 소개했다.

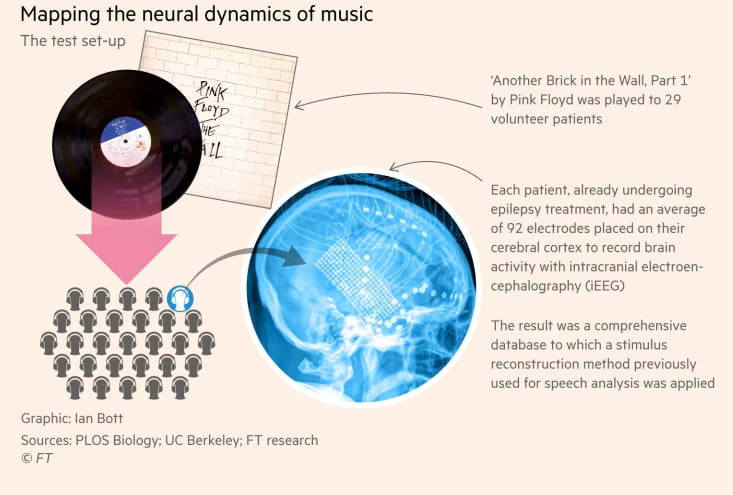

이에 따르면 연구진은 간질 치료를 위해 뇌 수술을 진행할 때 수술실에서 록그룹 핑크 플로이드의 대표곡 '어나더 브릭 인 더 월(Another Brick in the Wall, Part 1)'을 약 3분 동안 재생했다. 환자 뇌 부위 표면에 총 92개의 전극을 삽입해 음악이 흐르는 동안 뇌파를 기록했고, AI로 분석한 다음 해당 곡에 사용된 단어와 소리를 재구성했다.

그 결과 실제 환자들에게 들려준 원곡과 비슷한 음악이 만들어졌다. 음악의 멜로디뿐 아니라 가사의 일부도 재현하는 데 성공했다.

연구진은 총 29명 환자의 뇌파를 통합 분석한 결과, 원곡으로 볼 수 있을 정도로 재현이 가능했다고 밝혔다. 가사 중 ‘그저 벽 속의 벽돌이었을 뿐(All in all, it’s just another brick in the wall)’이라는 후렴구를 알아들을 수 있을 정도로 재현했다.

이전에도 비슷한 사례가 있었으나, 가사까지 재현한 것은 처음으로 알려졌다.

연구를 주도한 로버트 나이트 UC버클리 신경과학 교수는 “물속에서 이야기하는 것처럼 들리긴 하지만, 이번 결과물은 우리의 첫 시도일 뿐”이라며 “전극의 밀도를 높여 뇌파를 더 정확히 수집하면 음악 재구성의 품질을 높일 수 있을 것”이라고 말했다.

더불어 일상적인 대화와 음악이 뇌의 다른 부분을 자극한다는 것도 확인했다. 일상적인 대화를 할 때는 우뇌가 주로 활성화된 반면, 음악을 들을 때는 좌뇌 활성이 더 커지는 것으로 나타났다. 연구진은 이런 차이가 대화와 음악을 다루는 뇌 영역이 다르기 때문으로 분석했다.

나이트 교수는 “음악에는 언어적인 표현뿐 아니라 리듬과 강세, 억양 같은 다양한 요소가 들어 있다는 점에서 본질적으로 감정적이고 운율적”이라며 “이 같은 정보를 뇌가 어떻게 처리하고, 뇌가 기록한 정보를 다시 음악으로 만들 수 있는지 확인했다”고 설명했다.

이번 연구는 뇌파를 감지해 인간의 사고와 컴퓨터를 연결하는 뇌-컴퓨터 인터페이스(BCI) 기술을 기반으로 하고 있다. 뇌파로 물건을 컨트롤할 수 있는 헤드셋, 생각만으로도 자유자재로 움직이는 로봇 팔 등도 BCI 기술에 해당한다.

이번 연구는 언어 능력에 문제가 생긴 뇌질환 환자를 돕는 것은 물론, 사람과 컴퓨터를 잇는 BCI 기술의 발전으로 이어질 수 있을 전망이다. 연구진은 이번에 개발한 기술을 바탕으로 음악을 상상했을 때 나타나는 뇌파로 음악을 재구성하는 연구를 이어갈 예정이다.

루도비치 벨리어 UC버클리 신경학 박사는 “뇌파 신호에서 음악적 특징을 구분할 수 있었다”며 “뇌파를 분석해 사람들이 듣고 있는 음악을 복원하는 것은 물론 사람들의 생각을 읽는 것도 가능해질 것”이라고 말했다.

이번 연구에 사용한 Pink Floyd의 'Another Brick In The Wall (Part 1)'

박찬 기자 cpark@aitimes.com