인텔이 노트북과 PC에서 로컬로 생성 인공지능(AI)를 실행할 수 있는 새로운 엣지용 AI 칩을 출시하며 '온디바이스 AI'에 속도를 내고 있다.

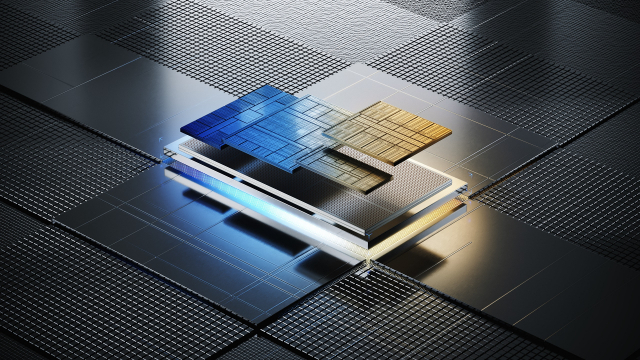

인텔은 14일(현지시간) 뉴욕에서 ‘AI 에브리웨어’ 행사를 열고 코드명 ‘메테오레이크’인 신형 모바일 중앙처리장치(CPU) ‘인텔 코어 울트라(Intel Core Ultra)’를 출시했다. 앞서 인텔은 코어 울트라 프로세서가 ‘AI PC’ 시대를 여는 시발점이라 소개한 바 있다.

펫 겔싱어 인텔 CEO는 “AI 혁신이 세계 GDP 3분의 1을 차지할 전망으로, 클라우드뿐만이 아니라 PC와 엣지에서 효과적으로 온디바이스로 AI를 통합하고 실행할 수 있는 기술이 필요하다”라고 강조했다.

인텔 코어 울트라는 PC용 CPU 중 최초로 신경망처리장치(NPU)를 탑재해 AI 성능을 강화했다. 이를 통해 네트워크 없이도 온디바이스 AI 실현이 가능하다. 실제 인텔 코어 울트라를 탑재한 노트북은 메타의 ‘라마2-7B’를 인터넷 연결 없이도 구동할 수 있다.

AI 연산에 쓰이는 그래픽처리장치(GPU) 성능도 전 세대 대비 2배 향상했다. 이를 통해 총 34테라플롭스(TP) 연산이 가능하고, 결과적으로 생성 AI 성능이 1.7배 강화됐다. 게다가 인텔이 처음으로 극자외선(EUV) 노광장비를 도입한 ‘인텔4’ 7나노 공정 기반으로 생산, 와트당 성능은 2.5배 향상됐다.

인텔은 마이크로소프트(MS), 어도비 등 100개 이상 소프트웨어 공업업체와 협력했다. 경쟁 플랫폼에 비해 더 크고 광범위한 AI 강화 애플리케이션 세트가 인텔 코어 울트라에서 실행된다는 의미다. 인텔은 그 예로 어도비 프리미어 프로에서 작업하는 콘텐츠 제작자가 경쟁사 대비 40% 성능 우위에 있다고 주장했다.

또 델, MS, 레노버, 삼성, LG 등 수십개의 노트북과 PC 제조사에서 코어 울트라를 사용하고 있다고 밝혔다.

이처럼 기술 기업들이 일제히 인텔 코어 울트라에 관심을 갖는 큰 이유는 한정된 컴퓨팅 자원 때문이다. 클라우드에서 구동하는 대규모 생성 AI는 학습과 추론에 천문학적인 비용이 든다. 엔비디아나 AMD의 GPU 가격이 폭등한 데다 반도체 수급 자체가 어렵고, AI가 작동할 때마다 드는 전기료도 부담이다. '챗GPT' 가동 비용은 일반 검색의 100~200배에 달한다. 각 기기가 중앙 클라우드의 연산 부담을 덜어줄 필요성이 커지고 있다.

AI가 확산하면서 트래픽이 늘어날 전망이지만 통신 인프라의 한계도 여전하다. AI가 전통적인 IT 기기 외 차량, 로봇, CCTV 등 카메라 등 반도체가 필요한 온갖 기기에 적용될 수 있음을 감안하면, 통신 연결 없이도 자체 구동 가능한 온디바이스 AI의 필요성은 더욱 커진다. 이 때문에 인텔 외에도 퀄컴이나 AMD 등 칩 업체들은 물론 심지어 엔비디아와 애플까지도 최근 온디바이스 AI에 올인하고 있다.

겔싱어 CEO는 "특히 MS 같은 기업은 원격 데이터 센터에서 AI 응용 프로그램을 실행하는 것이 너무 비용이 많이 들기 때문에, 로컬 PC 실행법을 찾아야 할 것"이라며 "MS 애저 클라우드에 접속한 10억개의 윈도우 장치에서 워크로드를 실시간으로 실행하는 것은 사실상 불가능하다"라고 지적했다.

그는 “경제성을 실현하려면 MS가 데이터 센터와 PC 사이의 데이터양을 100분의 1로 줄여야 한다”라고 말했다.

이는 내년초 출시할 윈도우 12에 '코파일럿' 기능이 탑재, AI가 사용자와 실시간 대화하며 업무를 대신 처리해 줄 수 있기 때문이다.

한편 이날 인텔은 새로운 '5세대 제온(Xeon)' 프로세서도 공개했다. 5세대 제온 프로세서는 서버용 CPU다. 클라우드와 같은 대규모 서버에 장착돼 엔비디아의 GPU와 함께 생성 AI를 구동하는 데 사용된다.

이전 세대 대비 일반 컴퓨팅 성능은 21% 향상, 다양한 고객 워크로드에서 와트당 평균 성능이 36% 더 높아졌다.

또 새로운 AI 칩 '가우디3(Gaudi3)' 시제품을 공개했다. 가우디3는 이전 세대보다 처리 속도를 최대 4배 향상하고 고대역폭 메모리HBM(HBM) 탑재 용량이 1.5배 늘어나 대형언어모델(LLM) 처리 성능을 높였다.

엔비디아의 GPU인 'H100'과 AMD의 최신 AI 칩 'MI300X'와 치열한 경쟁이 예상된다.

박찬 기자 cpark@aitimes.com