법률 분야 인공지능(AI) 도구의 정확성을 높이기 위해 검색 증강 생성(RAG) 기법을 도입하지만, 여전히 일정 비율로 부정확한 정보를 생성한다는 연구 결과가 나왔다. 법률 분야에서 AI 도구에 대한 벤치마킹과 공개 평가의 필요성이 대두된다는 지적이다.

벤처비트는 7일(현지시간) 스탠포드 대학 연구진이 법률AI 도구들이 ‘주요 AI 법률 연구 도구의 신뢰성 평가(Assessing the Reliability of Leading AI Legal Research Tools)’라는 연구 결과를 공개했다고 보도했다.

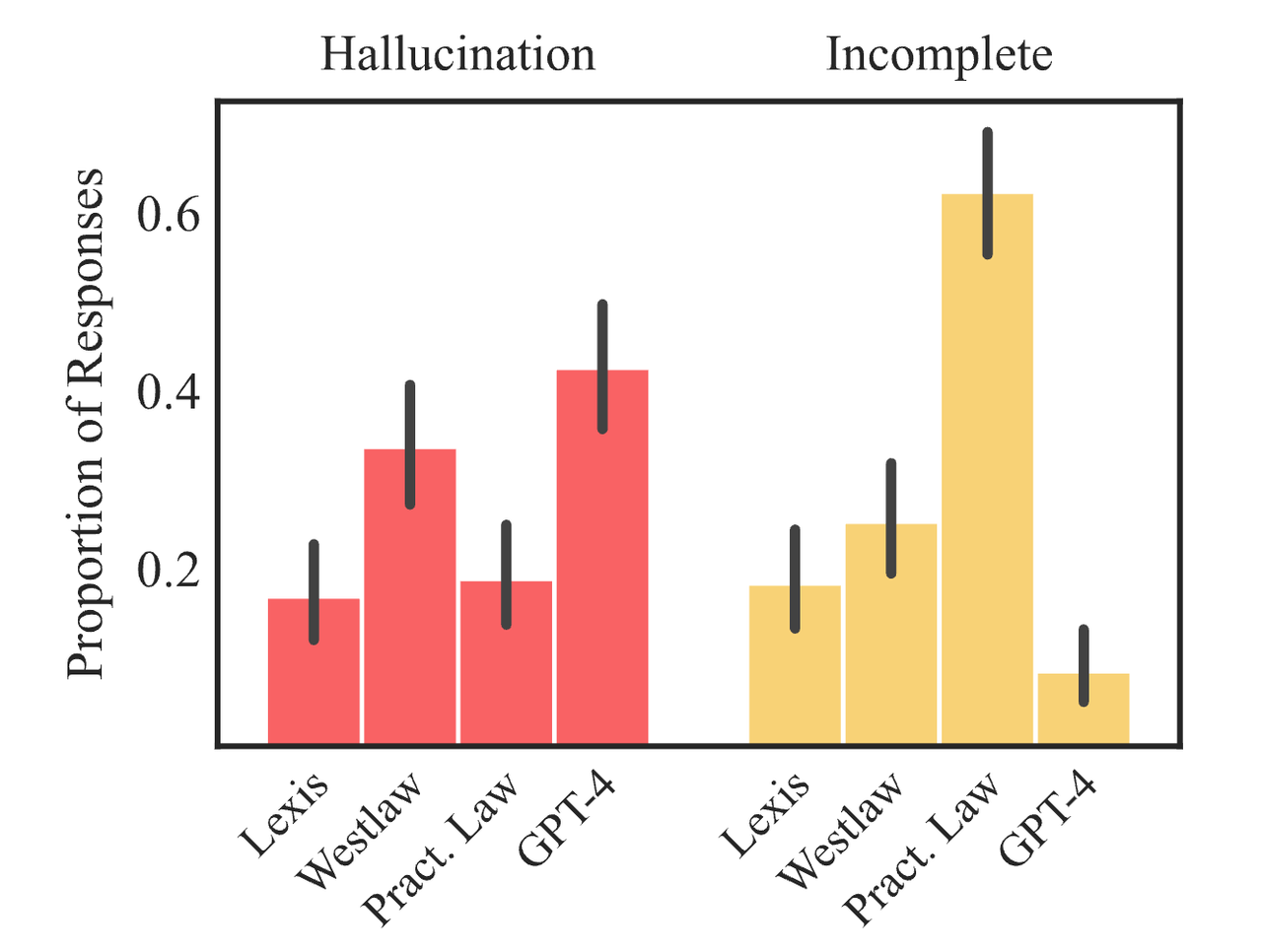

이에 따르면 연구진이 수작업으로 구성된 200개 이상의 법률 질의에 대해 주요 법률 AI 도구와 'GPT-4'를 비교했다. 그 결과 범용 챗봇에 비해서는 환각이 덜한 편이지만, 법률 AI 도구는 여전히 높은 비율로 환각을 일으켰다.

대부분 법률 AI 도구는 환각을 줄이기 위해 RAG 기법을 사용한다. 단순한 LLM 시스템은 훈련 중에 습득한 지식에만 의존하는 반면, RAG 시스템은 먼저 지식 베이스에서 관련 문서를 검색해 응답에 대한 컨텍스트를 제공한다.

이 때문에 RAG는 다양한 도메인에서 환각을 줄이려는 기업들에게 표준이 되고 있다.

그러나 RAG를 적용한 법률 AI 서비스도 여전히 신뢰성이 떨어지는 것으로 나타났다.

렉시스넥시스와 톰슨 로이터 등의 도구는 각각 17% 이상, 34% 이상의 시간 동안 잘못된 정보를 생산했다. RAG 시스템도 환각 없는 결과를 보장하지 못한다는 의미다.

연구진은 이에 대해 법률 질문이 종종 명확한 단일 답변을 가지지 않으며, 문서 집합에서 이를 검색하는 것이 어려울 수 있다고 지적했다. 예를 들어, 시스템은 여러 시점의 다양한 출처에서 정보를 찾아야 하기 때문에 무엇을 검색할지 결정하는 것이 어려울 수 있으며, 어떤 경우에는 질의가 새로운 것이거나 법적으로 불확실해 명확하게 답변할 수 있는 문서가 없을 수도 있다는 설명이다.

또 법률상의 문서의 관련성은 RAG 시스템처럼 텍스트 유사성만으로 결정되지 않는다고 지적했다. 텍스트상으로는 관련이 있는 것처럼 보이지만, 실제로는 관련이 없는 문서를 검색하면 시스템 성능에 부정적 영향을 미칠 수 있다고 밝혔다.

연구진은 “다른 AI 분야에서와 마찬가지로, 법률 기술 산업은 RAG에 의존해 환각 없는 제품을 자신있게 주장해 왔다”라며 “이러한 주장들을 평가하기 위해 법률 RAG 도구를 대상으로 연구했으며, 이러한 마케팅 주장과는 달리 법률 RAG가 환각 문제를 해결하지 못했다는 것을 보여줬다”라고 말했다.

물론 한계에도 불구하고, 범용 AI에 비해 RAG는 환각을 감소시킨다고 밝혔다. 또 법률 AI 도구에 대한 투명성과 객관적인 벤치마킹이 필요하다고 강조했다.

실제 변호사의 거의 4분의 3이 사례 법률 검토, 계약 초안 작성, 문서 검토, 법률 메모 작성 등의 업무에 법률 AI 제품를 사용할 계획인 것으로 알려졌다. 그러나 제품을 선택할 수 있도록 테스트하고 벤치마킹하는 솔루션이 거의 없다는 설명이다.

박찬 기자 cpark@aitimes.com